Package Management

dpkg

管理软件包

dpkg 意即 Debian 包管理器(Debian PacKaGe manager)。dpkg 是一个可以安装、构建、删除及管理 Debian 软件包的命令行工具。

其它的一些工具如 dpkg-deb 和 dpkg-query 等使用 dpkg 作为执行某些操作的前端。

现在大多数系统管理员使用 Apt、Apt-Get 及 Aptitude 等工具,不用费心就可以轻松地管理软件。

尽管如此,必要的时候还是需要用 dpkg 来安装某些软件。

常见命令及文件位置

dpkg 命令的语法:

dpkg [<option> ...] <command>

dpkg 相关文件的位置在 /var/lib/dpkg

/var/lib/dpkg/status 包含了被 dpkg 命令(install、remove 等)所修改的包的信息

/var/lib/dpkg/status 包含了可用包的列表

安装/升级软件

在基于 Debian 的系统里,用以下命令来安装 .deb 软件包。要是已经安装了软件包,就会升级它。

sudo dpkg -i package.deb

从文件夹里安装软件

在基于 Debian 的系统里,用下列命令从目录中逐个安装软件。这会安装 /opt/software 目录下的所有以 .deb 为后缀的软件。

sudo dpkg -iR /opt/software

显示已安装软件列表

以下命令可以列出 Debian 系的系统中所有已安装的软件,同时会显示软件版本和描述信息。

dpkg -l

查看指定的已安装软件

用以下命令列出指定的一个已安装软件,同时会显示软件版本和描述信息。

dpkg -l package

查看软件安装目录

以下命令可以在基于 Debian 的系统上查看软件的安装路径。

dpkg -L package

查看 deb 包内容

下列命令可以查看 deb 包内容。它会显示 .deb 包中的一系列文件。

dpkg -c package.deb

显示软件的详细信息

以下命令可以显示软件的详细信息,如软件名、软件类别、版本、维护者、软件架构、依赖的软件、软件描述等等。

dpkg -s package

查看文件属于哪个软件

用以下命令来查看文件属于哪个软件。

dpkg -S /path/file

移除/删除软件

以下命令可以用来移除/删除一个已经安装的软件,但不删除配置文件。

sudo dpkg -r package

清除软件

以下命令可以用来移除/删除包括配置文件在内的所有文件。

sudo dpkg -P package

Debian 打包入门

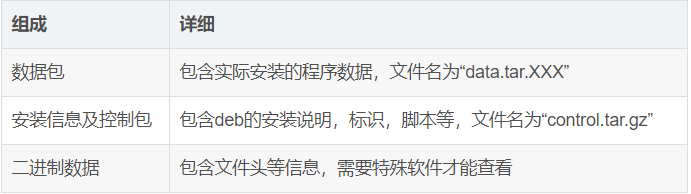

deb包本身有三部分组成:

注:原文写的不是很好,具体学习还是看官方的 Debian 新维护者手册

Cardbook 是用于管理基于 CardDav 和 vCard 标准的联系人的Thunderbird扩展。

使用 dh_make 在当前目录下创建一个 debian 目录。

$ dh_make\

--native \

--single \

--packagename cardbook_1.0.0 \

--email minkush@example.com

一些重要的文件,比如 control、rules、changelog、copyright 等文件被初始化其中。所创建的文件的完整列表如下:

$ find debian

debian

debian/manpage.sgml.ex

debian/cardbook.doc-base.EX

debian/changelog

debian/control

debian/postrm.ex

debian/postinst.ex

debian/source

debian/source/format

debian/README.Debian

debian/manpage.1.ex

debian/salsa-ci.yml.ex

debian/rules

debian/cardbook.cron.d.ex

debian/README.source

debian/preinst.ex

debian/prerm.ex

debian/copyright

debian/cardbook-docs.docs

debian/README

debian/manpage.xml.ex

在当前目录执行 dpkg-buildpackage -us -uc -ui 将会在上层目录创建一个空的包文件以及四个名为 .changes、.deb、 .dsc、 .tar.gz 的文件。

.dsc文件包含了所发生的修改和签名.deb文件是用于安装的主要包文件。.tar.gz(tarball)包含了源代码。

这个过程也在 debian/cardbook/usr/share/doc/cardbook 目录下创建了 README 和 changelog 文件。它们包含了关于这个包的基本信息比如描述、作者、版本。

检查这个包安装的内容:

$ dpkg -c cardbook_1.0.0_amd64.deb

/usr

/usr/share

/usr/share/doc

/usr/share/doc/cardbook

/usr/share/doc/cardbook/README.Debian

/usr/share/doc/cardbook/changelog.gz

/usr/share/doc/cardbook/copyright

build-essential

在 Ubuntu 中安装构建基础包(build-essential),只需要在终端中简单输入这个命令:

sudo apt update && sudo apt install build-essential

构建基础包(build-essential)实际上是属于 Debian 的。在它里面其实并不是一个软件。它包含了创建一个 Debian 包(.deb)所需的软件包列表。这些软件包包括 libc、gcc、g++、make、dpkg-dev 等。构建基础包包含这些所需的软件包作为依赖,所以当你安装它时,你只需一个命令就能安装所有这些软件包。

请不要认为构建基础包是一个可以在一个命令中神奇地安装从 Ruby 到 Go 的所有开发工具的超级软件包。它包含一些开发工具,但不是全部。

Package converter

- alien:Alien is really designed to be used to convert from alien file formats to the packaging format used by the distribution you run it on.

- gentoo-zh:gentoo 本质是通过 bash 安装软件,因此,可以参考此仓库尝试手动安装软件。

Is linux binary universal to all kinds of distributions?

This is two questions:

Is a Linux binary universal to all distributions?

It depends:

- If the program is using nothing outside the Linux kernel, it will be universal except for the 32- or 64-bit question. A Linux “hello world” (a minimalistic program that just prints “hello world” to a terminal window) could probably be independent of the distribution.

- If the program is using any non-kernel library or service (which is most of Linux, the kernel is fairly small), there are differences in which libraries are included, which versions these libraries are and where they are located. So in this (most common) case distributions are not equal.

Why do many commercial programs say that they only work on one or a few distributions?

Because there is a very large number of Linux distributions, and nobody wants to test their program on all of them.

A commercial vendor will normally say that they support only the distributions they have tested their software on. It may or may not work on other distributions, from the vendor’s perspective the point is just that you can’t complain if it does not work on a distribution they don’t support.

Which distributions are selected for testing depends on what the vendor expects their customers to be using. Commercial/professional programs commonly pick enterprise distributions, possibly through a reasoning similar to “people who paid for their OS are more likely to pay for our software”, possibly simply by counting the distributions used by their existing customers.

See also Mark Shuttleworth (the guy that is the reason we have an Ubuntu in the first place) on [binary compatibility between Ubuntu and Debian](https://wiki.ubuntu.com/MarkShuttleworth#What about binary compatibility) - Debian is the closest distribution relative of Ubuntu.

APT

Debian 使用一套名为 Advanced Packaging Tool(APT)的工具来管理包系统。在基于 Debian 的 Linux 发行版中,有各种工具可以与 APT 进行交互,以方便用户安装、删除和管理的软件包。apt-get 便是其中一款广受欢迎的命令行工具,但是最常用的命令都被分散在了 apt-get、apt-cache 和 apt-config 这三条命令当中,apt 命令的引入就是为了解决命令过于分散的问题。(简单来说就是:apt = apt-get、apt-cache 和 apt-config 中最常用命令选项的集合)

| apt 命令 | 取代的命令 | 命令的功能 |

|---|---|---|

| apt install | apt-get install | 安装软件包 |

| apt remove | apt-get remove | 移除软件包 |

| apt purge | apt-get purge | 移除软件包及配置文件 |

| apt update | apt-get update | 刷新存储库索引 |

| apt upgrade | apt-get upgrade | 升级所有可升级的软件包 |

| apt autoremove | apt-get autoremove | 自动删除不需要的包 |

| apt full-upgrade | apt-get dist-upgrade | 在升级软件包时自动处理依赖关系 |

| apt search | apt-cache search | 搜索应用程序 |

| apt show | apt-cache show | 显示装细节 |

| apt list | 列出包含条件的包(已安装,可升级等) | |

| apt edit-sources | 编辑源列表 |

列出所有手动安装软件

apt-mark showmanual

查看软件包依赖

当你在 Linux 中安装一个软件包,有时这个软件包还需要其他的软件包来使它工作正常。这些额外的软件包就叫作这个包的依赖。假如这些软件包之前没有在系统中被安装,那么这些依赖在安装这个软件包的同时会被自动安装上。

使用 apt show 来查看依赖

你可以使用 apt show 命令 来展示一个包的详细信息。其中依赖信息就是其中一部分,你可以在以 “Depends” 打头的那些行中看到它们。

例如,下面展示的是使用 apt show 展示 ubuntu-restricted-extras 这个包的详细信息:

$ apt show ubuntu-restricted-extras

Package: ubuntu-restricted-extras

Version: 67

...

Depends: ubuntu-restricted-addons

Recommends: libavcodec-extra, ttf-mscorefonts-installer, unrar

...

如你所见,ubuntu-restricted-extras 包依赖于 ubuntu-restricted-addons 这个软件包。

但你得小心的是依赖包还可能依赖于其他包,这样一直循环往复直到尽头。但幸好 APT 包管理器可以为你处理这些复杂的依赖关系,自动地安装所有的依赖(大多数情况下)。

什么是推荐包?

你注意到了上面结果输出中以 “Recommends” 开头的那些行了吗?

推荐包不是软件包的直接依赖,但它们可以开启软件包的一些额外功能。

正如你上面看到的那样, ubuntu-restricted-extras 包有 ttf-mscorefonts-installer 这个推荐包,用来在 Ubuntu 上安装 Microsoft 的字体。

这些推荐包也会默认被一同安装上,假如你想显式地禁止这些推荐包的安装,你可以像下面这样使用 –-no-install-recommends 选项。

sudo apt install --no-install-recommends package_name

使用 apt-cache 来直接获取依赖信息

上面通过 apt show 的方式会获取到大量信息,假如你想在脚本中获取到依赖信息,那么 apt-cache 命令将会给你一个更好且更简洁的输出结果。

apt-cache depends package_name

使用 dpkg 来查看一个 DEB 文件的依赖

apt 和 apt-cache 都作用于软件仓库中的软件包,但假如你下载了一个 DEB 文件,那么这两个命令就不起作用了。

在这种情形下,你可以使用 dpkg 命令的 -I 或 --info 选项。

dpkg -I path_to_deb_file

依赖信息就可以在以 “Depends” 开头的那些行中找到。

使用 apt-rdepends 来查看依赖及依赖的依赖

假如你想查看更多关于依赖的信息,那么你可以使用 apt-rdepends 工具。这个工具可以创建完整的依赖树。这样你就可以得到一个软件包的依赖以及这些依赖的依赖。

它不是一个常规的 apt 命令,所以你需要从 universe 软件仓库中安装上它:

sudo apt install apt-rdepends

这个命令的输出通常很多,取决于依赖树的大小。

eading package lists... Done

Building dependency tree

Reading state information... Done

shutter

Depends: procps

Depends: xdg-utils

imagemagick

Depends: imagemagick-6.q16 (>= 8:6.9.2.10+dfsg-2~)

imagemagick-6.q16

Depends: hicolor-icon-theme

Depends: libc6 (>= 2.4)

Depends: libmagickcore-6.q16-6 (>= 8:6.9.10.2)

Depends: libmagickwand-6.q16-6 (>= 8:6.9.10.2)

hicolor-icon-theme

libc6

Depends: libcrypt1 (>= 1:4.4.10-10ubuntu4)

Depends: libgcc-s1

libcrypt1

Depends: libc6 (>= 2.25)

apt-rdepends 工具的功能非常多样,它还可以用来计算反向依赖。这意味着你可以查看某个特定的包被哪些软件包依赖。

apt-rdepends -r package_name

输出可能会非常多,因为它将打印出反向依赖树。

$ apt-rdepends -r ffmpeg

Reading package lists... Done

Building dependency tree

Reading state information... Done

ffmpeg

Reverse Depends: ardour-video-timeline (>= 1:5.12.0-3ubuntu4)

Reverse Depends: deepin-screen-recorder (5.0.0-1build2)

Reverse Depends: devede (4.15.0-2)

Reverse Depends: dvd-slideshow (0.8.6.1-1)

Reverse Depends: green-recorder (>= 3.2.3)

Repository Mirror

You can use deb mirror to have the best mirror picked for you automatically.

apt-get now supports a ‘mirror’ method that will automatically select a good mirror based on your location. Putting:

deb mirror://mirrors.ubuntu.com/mirrors.txt precise main restricted universe multiverse

deb mirror://mirrors.ubuntu.com/mirrors.txt precise-updates main restricted universe multiverse

deb mirror://mirrors.ubuntu.com/mirrors.txt precise-backports main restricted universe multiverse

deb mirror://mirrors.ubuntu.com/mirrors.txt precise-security main restricted universe multiverse

on the top in your /etc/apt/sources.list file should be all that is needed to make it automatically pick a mirror for you based on your geographical location.

There are many command line tools available to find the best APT mirrors based on download speed. I have tested the following tools and they are working just fine in my Ubuntu 20.04 LTS desktop.

- Apt-select

- Apt-smart

apt-fast

apt-fast: A shellscript wrapper for apt that speeds up downloading of packages.

$ sudo apt-get install aria2

$ sudo add-apt-repository ppa:apt-fast/stable

$ sudo apt-get update

$ sudo apt-get -y install apt-fast

$ sudo nano /etc/apt-fast.conf

MIRRORS=('https://mirrors.bfsu.edu.cn/ubuntu/,https://mirrors.tuna.tsinghua.edu.cn/ubuntu/')

apt-aria2

#!/bin/bash

## apt-aria2: To help download packages faster via aria2, instead of wget.

## Author: Anjishnu Sarkar

## Version: 0.5

## Acknowledgement: This script is a rewrite of the apt-fast script by

## Matt Parnell (admin@mattparnell.com) (http://www.mattparnell.com)

## Usage: Same as apt-get. Using the option "-y" always.

## BUG:

## *) If this script is interuppted, then next time aria2 starts downloading

## the same from the begining. Can be solved - something to do with .st file.

## TODO:

## *) Start installing via apt-get as soon as first package is downloaded

## and also keep downloading at the same time. This however might lead

## to dependencies not being satisfied.

## Initialization(s):

Download="False"

Install="True"

Confirm="True"

UniqueName="$RANDOM"

Options="$@"

## Checking for commands which requires download

while test -n "${1}"

do

case "${1}" in

install|upgrade|dist-upgrade|source|build-dep)

## Download

Download="True"

;;

update|remove|autoremove|purge|dselect-upgrade|clean|autoclean|check)

## Anything other than download

Download="False"

;;

-d) ## Download only (don't install)

Install="False"

;;

-y) ## No need to ask for confirmation

Confirm="False"

;;

*)

## Nothing to be done. If any wrong options/commands are given then

## let apt-get handle it.

;;

esac

shift

done

## In case download is true

if [ "$Download" == "True" ];then

## Installing pre-requisite(s): aria2

if ! which aria2c > /dev/null; then

echo "Aria2 not installed. Installing aria2 first via apt-get"

apt-get -y --force-yes install aria2

fi

ArchiveDir=/var/cache/apt/archives/

cd ${ArchiveDir}/partial

PrintUris=$(apt-get --yes --print-uris ${Options})

if [ $? -ne 0 ];then

echo "Aborting."

exit 1

fi

PackageInfo=$(echo "$PrintUris" | awk '/Reading package/,/After this operation/')

# echo "$PrintUris" | grep ^\' | cut -d\' -f2 > "$UniqueName"-uris.txt

echo "$PrintUris" | grep "http:" | cut -d\' -f2 > "$UniqueName"-uris.txt

NumberOfPackages=$(wc -l "$UniqueName"-uris.txt | awk '{print $1}')

## Print info

echo "$PackageInfo"

echo "Number of packages to be downloaded: $NumberOfPackages"

## Check whether package has already been installed or not

InstallUpgradeMsg=$(echo "$PackageInfo" | grep \

-e "The following NEW packages will be installed:" \

-e "The following packages will be upgraded:")

if [ -z "$InstallUpgradeMsg" ];then

rm -f "$UniqueName"-uris.txt

exit 0

fi

## In $InstallUpgradeMsg is not null, then proceed...

## If confirm is true

if [ "$Confirm" == "True" ];then

echo -n "Do you want to continue [y|n]? "

read Ans

case "$Ans" in

y|yes|"") ;;

n|no|*) echo "Abort."

rm -f "$UniqueName"-uris.txt

exit 1 ;;

esac

fi

if [ $NumberOfPackages -ne 0 ];then

## Downloading the packages

echo "Proceeding with downloading ..."

while read DebUrl

do

DebName=$(basename "$DebUrl")

echo "$DebName"

AptConf="/etc/apt/apt.conf"

if [ -f "$AptConf" ];then

http_proxy=$(grep -i "http::proxy" "$AptConf" | cut -d \" -f2)

fi

if [ -n "$http_proxy" ];then

echo "Using proxy..."

aria2c -c -s 10 -j 10 --http-proxy=$http_proxy "$DebUrl"

else

echo "Not using proxy..."

aria2c -c -s 10 -j 10 "$DebUrl"

fi

if [ $? -eq 0 ];then

mv $DebName ${ArchiveDir}

fi

done < "$UniqueName"-uris.txt

fi

rm -f "$UniqueName"-uris.txt

# echo "Installing..."

if [ "$Install" == "True" ];then

apt-get -y --force-yes ${Options}

fi

else

## Cases when download is false

apt-get ${Options}

fi

PPA

软件仓库是一组文件,其中包含各种软件及其版本的信息,以及校验和等其他一些详细信息。每个版本的 Ubuntu 都有自己的四个官方软件仓库:

- Main - Canonical 支持的自由开源软件。

- Universe - 社区维护的自由开源软件。

- Restricted - 设备的专有驱动程序。

- Multiverse - 受版权或法律问题限制的软件。

你可以在 这里 看到所有版本的 Ubuntu 的软件仓库。你可以浏览并转到各个仓库。

这些信息存储在系统的 /etc/apt/sources.list 文件中。如果查看此文件的内容,你就会看到里面有软件仓库的网址。# 开头的行将被忽略。

Ubuntu 不会在官方仓库中立即提供新版本的软件。他们需要一个步骤来检查此新版本的软件是否与系统兼容,从而可以确保系统的稳定性。这意味着它需要经过几周才能在 Ubuntu 上可用,在某些情况下,这可能需要几个月的时间。

为获取最新版本的软件,需要使用 PPA,PPA (Personal Package Archives) 允许开发者上传要构建的 Ubuntu 源包,并通过 Launchpad 作为 apt 的软件仓库发布。

通过如下命令添加 PPA 软件仓库并获取最新版本软件:

sudo add-apt-repository <PPA_info>

sudo apt-get update

sudo apt-get install <package_in_PPA>

当你使用 PPA 时,它不会更改原始的 sources.list 文件。相反,它在 /etc/apt/sources.d 目录中创建了两个文件,一个 .list 文件和一个带有 .save 后缀的备份文件。这是一种安全措施,可以确保添加的 PPA 不会和原始的 sources.list 文件弄混,它还有助于移除 PPA。

开发人员为他们的软件创建的 PPA 称为官方 PPA。但有时,个人会创建由其他开发人员所创建的项目的 PPA。为什么会有人这样做? 因为许多开发人员只提供软件的源代码。

如果 PPA 不适用于你的系统版本,你可以点击应用程序 PPA 页面的 View package details,在这里,你可以单击软件包以显示更多详细信息,还可以在此处找到包的源代码和 DEB 文件。建议 使用 Gdebi 安装这些 DEB 文件 而不是通过软件中心,因为 Gdebi 在处理依赖项方面要好得多。

就安全性而言,很少见到因为使用 PPA 之后你的 Linux 系统被黑客攻击或注入恶意软件。到目前为止,我不记得发生过这样的事件。官方 PPA 可以不加考虑的使用,使用非官方 PPA 完全是你自己的决定。根据经验,如果程序需要 sudo 权限,则应避免通过第三方 PPA 进行安装。

APT Proxy

-

Create a new configuration file named proxy.conf.

sudo touch /etc/apt/apt.conf.d/proxy.conf -

Open the proxy.conf file in a text editor.

sudo vi /etc/apt/apt.conf.d/proxy.conf -

Add the following line to set your HTTP proxy.

Acquire::http::Proxy "http://user:password@proxy.server:port/"; -

Add the following line to set your HTTPS proxy.

Acquire::https::Proxy "http://user:password@proxy.server:port/"; -

Save your changes and exit the text editor. Your proxy settings will be applied the next time you run Apt.

OR create a new file under the /etc/apt/apt.conf.d directory, and then add the following lines.

Acquire {

HTTP::proxy "http://127.0.0.1:8080";

HTTPS::proxy "http://127.0.0.1:8080";

}

OR

sudo -E apt install

OR …

Snap & Flatpak

什么是Snap应用

如果你在使用Ubuntu 18.04/20.04 LTS版本的Ubuntu系统,会发现系统里面多了一个应用格式包——.snap包。Snap包是Ubuntu 16.04 LTS发布时引入的新应用格式包。

当你在安装完snap后,你会发现在在根目录下会出现如/dev/loop0的挂载点,这些挂载点正是snap软件包的目录。Snap使用了squashFS文件系统,一种开源的压缩,只读文件系统,基于GPL协议发行。一旦snap被安装后,其就有一个只读的文件系统和一个可写入的区域。应用自身的执行文件、库、依赖包都被放在这个只读目录,意味着该目录不能被随意篡改和写入。

squashFS文件系统的引入,使得snap的安全性要优于传统的Linux软件包。同时,每个snap默认都被严格限制(confined),即限制系统权限和资源访问。但是,可通过授予权限策略来获得对系统资源的访问。这也是安全性更好的表现。

Snap可包含一个或多个服务,支持cli(命令行)应用,GUI图形应用以及无单进程限制。因此,你可以单个snap下调用一个或多个服务。对于某些多服务的应用来说,非常方便。前面说到snap间相互隔离,那么怎么交换资源呢?答案是可以通过interface(接口)定义来做资源交换。interface被用于让snap可访问OpenGL加速,声卡播放、录制,网络和HOME目录。Interface由slot和plug组成即提供者和消费者。

目前,Ubuntu的相关产品已以snap包的形式发布,例如Ubuntu MAAS,Juju,Multipass,MicroK8s,MicroStack等等。

snap “canonical-livepatch” has “install-snap” change in progress

Snap 包是 Ubuntu 16.04 LTS 发布时引入的新应用格式包。目前已流行在很多 Linux 发行版上。并且可以很方便地安装常用软件,如 VLC、Sublime Text、VSCode、Node、WPS等

当你在安装完 Snap 后,你会发现在在根目录下会出现如 /dev/loop0 的挂载点,这些挂载点正是 Snap 软件包的目录。

-

原因是软件之前安装了一次,只是安装失败。

snap changessnap abort 5 ## 5 为安装失败软件的 ID -

现在重新安装

一些软件最好在官网下载或在 Snap 中下载,官方 Repository 可能并不新,比如 VLC。

Is just a way to indicate that supplementary material is being downloaded.

If one keeps Ubuntu’s system monitor open at the same time, it’s quite evident that “Automatically connect eligible plugs and slots …” means a download is in progress.

所以,解决办法是用 proxychains。

Speed Up Downloading

This simple tutorial shows how to speed up the downloading process of snap application package by associating IP address with the snapcraft server in Ubuntu.

1.) Open terminal either via Ctrl+Alt+T keyboard shortcut or by searching for ‘terminal’ from application menu. When terminal opens, run command:

dig fastly.cdn.snapcraft.io

fastly.cdn.snapcraft.io is deprecated. Get more Snapcraft Download CDNs

In the terminal output, copy the IP address under ‘ANSWER SECTION’.

2.) Then run commands to edit the hosts file:

sudo gedit /etc/hosts

Type user password (no asterisk) when it prompts and hit Enter.

When the files opens in gedit text editor, paste following line:

151.101.42.217 fastly.cdn.snapcraft.io

Replace the IP address with which you got in step 1, and finally save the file.

为Snapd设置代理

Snap,全称SnapCraft,是一个全新的应用软件环境。在Snap中,软件被封装在类似于Docker的容器中,即开即用,可随时获取,这一切由其后台服务snapd提供支持。Ubuntu从18.04开始,就引入它作为系统的一部分,而其他的Linux发行版(如Deepin)也可以通过软件管理工具进行安装(如sudo apt install snapd)。

SnapCraft将软件包分发在自己的服务器上。然而,因为众所周知的原因,访问位于海外的Snap服务器异常缓慢,不加代理的情况下,下载速度会持续降到十几KB每秒。这使得我们不得不想办法通过代理服务器进行加速。

一般地,Linux上的一些应用程序会通过读取环境变量http_proxy和https_proxy来应用代理服务器设置,典型的有Chrome。然而,Snap比较特别,它不会从环境变量中上述环境变量中读取代理服务器设置,因此直接使用export http_proxy=[代理服务器地址]或export https_proxy=[代理服务器地址]是不起作用的。

那么,有何正确的方法?

/etc/environment是一个Shell脚本,snapd会读取它,应用其中指定的配置信息。因此,设置代理服务器的正确目标,实际上就是这里。

在/etc/environment中加入:

http_proxy=http://[服务器地址]:[端口号]

https_proxy=http://[服务器地址]:[端口号]

然后重启snapd服务:

sudo systemctl restart snapd

A system option was added in snap 2.28 to specify the proxy server.

sudo snap set system proxy.http="http://<proxy_addr>:<proxy_port>"

sudo snap set system proxy.https="http://<proxy_addr>:<proxy_port>"

除了修改environment文件,也可以修改snapd服务的配置文件,在其加入Environment信息,信息内容实际上就是“方法一”中设置代理服务器的语句。

运行以下命令,打开snapd的配置文件:

sudo systemctl edit snapd.service

在打开的文本编辑器中,加入以下语句:

[Service]

Environment=http_proxy=http://proxy:port

Environment=https_proxy=http://proxy:port

最后重新加载snapd服务:

sudo systemctl daemon-reload

sudo systemctl restart snapd.service

注意事项

一般的本地代理都不支持HTTPS,所以https_proxy的值也只能是http地址,否则会出现如下错误:

cannot install "conjure-up": Post https://api.snapcraft.io/v2/snaps/refresh: proxyconnect tcp: EOF

Snap 深远意义

近日,Ubuntu推出了Snap应用包格式,受到各主流发行版和软件基金会欢迎.这有何深远意义?

-

farseerfc

首先「受到各主流发行版和软件基金会欢迎」這句可是 Ubuntu 的人說給媒體人的,別的發行版都還沒表態,見我另一個回答

Flatpak 和 Snap package 技术上有何区别?各有何优劣?如何看待两者的发展前景? - fc farseer 的回答

然後,容器技術的重要性和 Linux 上第三方軟件開發商打包困難的問題很多人都提到了,都說得不錯,不再複述。

我就提一下爲什麼 Ubuntu 要做這個,爲什麼 Ubuntu 要在這個時候大張旗鼓推這個。

在操作系統領域幾十年來經久未變的一點是,操作系統本身不重要,重要的是能跑在其上的應用程序,現在的話說是生態環境。而應用程序不是針對操作系統本身撰寫,應用程序是針對操作系統提供的API/SDK撰寫,換句話說,掌握了API/SDK的控制權,就掌握了最寶貴的應用程序開發者,操作系統本身就得以長久發展。這就是爲什麼 Windows 遠比 Mac 賣得好的道理,Windows 掌握着桌面操作系統裏最穩定的SDK,幾十年來保持兼容性未曾變過,而 Mac 時常破壞 API 兼容性使得老程序不能再跑在新系統上。這個道理

How Microsoft Lost the API War

這篇文章闡述得非常明白。

GNU/Linux 乃至整個 FOSS 社區,在這一點上,其實非常另類。 GNU 系統從來沒有把「保持程序兼容性以吸引用戶和開發者」放在首要目標,GNU 的首要目標是「給用戶以自由」。那麼 GNU/Linux 的應用程序兼容性不好麼?並不見得,幾十年前的 ed/vi/xterm 程序現在還好好得跑在 各大發行版上,一些程序比 Windows 上的軟件還要古老很多。但是這並不是 GNU/Linux 和各大發行版致力於保護兼容性的結果,而是這些軟件「自由」的結果。因爲他們自由且開源,發行版維護者們可以拿他們的源代碼重新編譯以利用新的軟件庫新的 ABI ;因爲他們自由而且開源,上游維護者可以不斷更新他們的代碼讓他們適應新的技術新的框架新的 API ;因爲他們自由而且開源,當上游開發者放棄項目不再開發的時候,還會有有志之士挺身而出接替開發維護的職責。換句話說,在 Linux 發行版上,軟件的兼容性好是軟件自由的直接結果。

這就是現在 GNU/Linux 發行版們打包軟件發佈軟件的模式,大家努力的目標是給予用戶自由。這一模式在自由開源軟件上非常有效,但是面對閉源軟件就不那麼有效了。閉源軟件的源代碼在開發者手上,沒有發行版打包者做銜接工作,所以閉源軟件在 GNU/Linux 上發佈起來非常困難。軟件的自由,除了乾淨放心保證隱私外對普通用戶來說沒有立竿見影的優勢,只對軟件開發者們有意義,所以 GNU/Linux 發行版一直是程序員的天堂,用戶的地獄。

而 Ubuntu 作爲一個發行版,並沒有共享傳統發行版的自由精神。從一開始,Ubuntu努力的首要目標就不是給用戶自由,而是擴大普通用戶的基數。Ubuntu看到,對普通用戶而言,閉源軟件尤其是商業軟件同等重要甚至可能更重要,普通用戶寧願忍受不自由,寧願放棄隱私放棄控制權,也不願使用那些表面粗質功能匱乏的開源替代。所以 Ubuntu 需要打破傳統發行版的發佈方式,讓商業閉源軟件也能在 GNU/Linux 上輕鬆發佈。

而且這條路的可行性早就驗證過了。Google 通過給 Linux 內核上包裝一層 Apache 協議的「自由性中立」的 userland 層,禁錮住了 GPL 的病毒傳播性,開發出 Android 系統,發展出 Android 之上的生態環境,吸引到了無數開發者爲其平臺寫(大部分閉源)軟件。另一點 Valve 通過 Steam 作爲兼容層,附帶大量依賴庫並保持 API 足夠穩定,同時充當遊戲開發者和 Steam 兼容層之間的橋樑,也順利地招攬到不少遊戲開發商爲 Steam 移植 Linux 平臺遊戲。這兩個先例都啓迪 Ubuntu ,這件事可以做並且可以做好。

並且現在做 Snap 對 Ubuntu 有一個重大的好處,在於壟斷 SDK 控制權。Snap 架空了發行版提供的包管理器,甚至架空了發行版本身(提供的依賴庫),從而對開發者而言,針對 Snap 提供軟件包就不需要考慮發行版(這是好事)。如果 Snap 受到足夠多的開發者支持,發展出成熟的生態,那麼 Ubuntu 也就不再發愁今後的推廣之路了,因爲 Ubuntu 上的 Snap 支持必然比別的發行版要好。目前 Snap 上發佈或者安裝軟件包需要 Ubuntu One 身份認證,屬於中央化的 App Store 模式,這給予 Ubuntu 最直接的控制權(而不是 Ubuntu 宣稱的把控制權從發行版交還給開發者),到時候 Ubuntu 攜應用以令用戶,用戶並沒有選擇的權利和自由。另一點,Ubuntu要做手機系統做IoT系統,面向的用戶群就是 Android/iOS 的用戶群,這樣的用戶群下,用自由開源的生態在短期內顯然難以抗衡,所以必須引入商業生態,從而提供類似的軟件商店也是 Ubuntu 的必由之路。

最開始的時候,Ubuntu 最大的敵人是微軟,這是它的 launchpad 上第一個 bug

Bug #1 (liberation) “Microsoft has a majority market share†: Bugs : Ubuntu(Ubuntu第一个BUG:微软在新的桌面 PC 市场中占有多数市场份额。这是 Ubuntu 和其他项目旨在修复的错误。)

現在 Ubuntu 和微軟成爲了合作關係,然後矛頭調轉直指一衆發行版,司馬昭之心可以想象。

问题

那用snap不需要依赖了吗?还是自带依赖?

回答

snap沒看懂它準備怎麼搞, flatpak的做法似乎是分成「框架包」和「軟件包」,框架包是類似 gtk3 、qt5 這種非常大的東西,整個作爲一個框架,軟件包依賴框架包,然後自帶一些小的不屬於框架的依賴。

问题

“因爲他們自由而且開源”

请问这里的“自由”的精确含义是什么?

回答

「用户可以自由地运行,拷贝,分发,学习,修改并改进该软件」(什么是自由软件?) 注意自由和開源並不是等價的,有些軟件,比如 kindle 的系統,是完全用 GPL 協議開源的,可以隨意獲取,但是很難修改它的軟件裝到 kindle 上去用。有另一些軟件,雖然沒有用開源協議開源,但是相對能很容易地獲取到源碼並且修改使用,比如很多大學的研究項目可以直接問負責人要到源碼。

-

梦断代码

并不受欢迎啊,基于ubuntu的一大堆发行版,比如mint,zorin,直接不管snap,反而使用flatpak。

说实话,snap挺作死的,当初unity桌面做的好好的,非要砍掉,snap应用却不砍,很迷惑,unity想统一桌面和手机,snap就是新的应用商店,还可以跨电脑和手机,可以说野心很大。可是unity没了,snap留着干嘛?

说是跨发行版,其实它太致命了,它同时支持桌面应用和命令行应用,然而都做的不行,比如neovim,装了snap版的,然而neovim这货又是远程通信支持语言的。比如node.js,同时用snap版的nvim和nodejs会发现nvim根本用不了node.js,因为snap这容器直接把这俩货隔离了。这只是其中一个。桌面应用简直群魔乱舞,wps好几个版本,都是不同人上传的,这不像flathub,flathub有点像github,可以直接像提pr一样给作者提交新版本,而snap,只要某软件作者不维护,你想用新的只能另开一个。

重点是snap还闭源,所以没法搭建镜像,其他厂商想接入也不好接入。

Difference between Snap and Flatpak

Flatpak is designed to install and update “apps”; user-facing software such as video editors, chat programs and more.

snaps can install anything which contains a kernel, printer drivers, audio subsystems and more.

Snap and Flatpak are the software behind two universal Linux app stores: the Snap Store and Flathub.

AppImage Wiki 做得对比图表。

群讨论

openSUSE 群

Flatpak使用bubblewrap来隔离应用程序,bwrap是非常轻量化的沙箱程序,因此攻击面极小。但bwrap需要用户对Linux程序工作方式有准确的了解(使用哪些syscall),Flatpak相当于充当了一个bwrap的前端帮助控制bwrap权限。

目前Flatpak的问题在于seccomp权限太过广泛,但目前Flatpak维护者已经意识到了这个问题(注释:在他们踩了一次坑之后),已经计划打算解决了。

另一个问题是程序请求的权限过于广泛,但这更多是一个决策问题而不是技术问题,而且你可以用Flatseal手动调整权限。

Flatpak你不能用常规程序方式来理解,每个程序都是一个完全独立的空间,只有给予了权限才有对应访问权,也可以用Portals调用文件选择器来获得单独一个文件的完全访问权,Flatpak版的Steam是把所有程序配置文件放在~/.var/app里面了,类似安卓下面的分区存储做法。

AppImage就只是个自挂载程序,自带的文件透明挂载到它自己的根文件系统下面,所以依然依赖主机的一部分库。所以是的,跟打包者用的系统有关系。

Flatpak不是这种机制,每个Flatpak空间是完全空白的,需要打包者自己选择加入哪些东西,所以Flatpak跨发行版的兼容性也更好。

良好打包的AppImage可以有很好的跨发行版兼容性,但是代价就是需要手工测试每个发行版下面的效果。在跨发行版兼容性这点上我更看好Flatpak。

最后,不要跟我提Snap,我不想碰那个东西,也对它没有研究的兴趣。

Flatpak确实有很多可取之处,或者不能说是Flatpak可取,而是Linux桌面软件生态现状决定了,只有更激进的手段才能改变现状。

AppImage那种策略还是过于不痛不痒了,结果就是程序仅仅是被打包成一个个单文件,但背后的库依赖地狱、权限隔离问题一个都没解决。

但AppImage作者的想法本来也不是靠AppImage颠覆,他是希望Linux能够重新恢复LSB,确保发行版之间的兼容性本身可靠而不是依赖Flatpak这些技术,就类似于Windows上的软件不需要什么沙箱模拟器,你几乎可以保证旧版本的软件能在新版本运行。

其实也可以说明,微软那种在桌面上采取的策略,很可能难以在Linux社区里推广开来,微软那种做法,确保绝对的向下兼容性,不是谁都有精力来做的。

比如说如果让微软来做Wayland,那微软根本就不会把Wayland做出来,而是把X11一直迭代、削减臃肿功能直到性能和现代化图形技术栈的性能相匹敌,同时确保向下兼容性。而最新一代的X11很可能和最早的X11已经彻底不一样了,甚至会有“检测程序版本然后自动匹配对应的X11功能”这些奇怪的兼容性策略出来。或许有一天微软会把新项目叫做Wayland,但这个改名也仅仅是营销目的而不是技术目的。

毕竟LSB已经没了,Ubuntu甚至砍掉32位兼容性,也可以说明其实Linux这边并没有太多人在乎这问题。

毕竟“反正源代码都在那,重新编译一遍不就好了吗”

Fedora 群

空のあお, [2/28/22 8:25 PM] 软件有不同版本的依赖 这些依赖很难共存 有些旧版依赖还有更旧的依赖 不说二进制兼容,有些连源码兼容都搞不定 就算搞定了,一段时间过后依赖升级了,还是得坏 flatpak的做法是维护abi稳定的qt和gtk两大ui库和必要桌面库的runtime,用来公用 通过容器隔离app,让每个app自己构建所需的特定依赖到容器里

竹林里有冰, [2/28/22 8:33 PM] sandbox他是用bubblewrap实现的吧,你可以直接使用bubblewrap,应该一样可以做到他的沙盒化,更小巧一点 bubblewrap的缺点就是需要针对每个程序写上配置,除了有点麻烦其他倒还不错

Neomonk Zen, [2/28/22 8:36 PM] 也不知flatpak的软件仓库,有没什么审核机制来防止恶意软件,如果没有的话,那还蛮可怕的,想想Chrome和Android的软件市场,都有很多恶意软件

Robin Lee, [2/28/22 8:39 PM] 没有深入的审核,跟各大发行版的官方包差不多,但flatpak可以限制应用权限

使用 Flatpak

The official Flatpak PPA is the recommended way to install Flatpak. To install it, run the following in a terminal:

sudo add-apt-repository ppa:flatpak/stable

sudo apt update

sudo apt install flatpak

Flathub is the best place to get Flatpak apps. To enable it, run:

sudo flatpak remote-add --if-not-exists flathub https://flathub.org/repo/flathub.flatpakrepo

To complete setup, restart your system. Now all you have to do is install some apps!

sudo flatpak remote-modify flathub --url=https://mirror.sjtu.edu.cn/flathub

Flathub 中部分软件由于重分发授权问题,需要从官方服务器下载,无法使用镜像站加速。比如 NVIDIA 驱动、JetBrains 系列软件等。

如果您中断了某次安装,重新下载可能会出现找不到文件的问题。您可以使用 flatpak repair 解决相关的问题。

Asian Font Problems with Flatpak

如果你遇到了游戏中无法显示亚洲字体的问题,这是因为 org.freedesktop.Platform 并没有包含合适的字体文件进去。首先尝试挂载你的本地字体:

flatpak run --filesystem=~/.local/share/fonts --filesystem=~/.config/fontconfig com.valvesoftware.Steam

如果上述命令不起作用,考虑动手 hack 一下:直接将字体文件复制进 org.freedesktop.Platform 的目录下以启用字体,例如

# replace ? with your version and hash

/var/lib/flatpak/runtime/org.freedesktop.Platform/x86_64/?/?/files/etc/fonts/conf.avail

/var/lib/flatpak/runtime/org.freedesktop.Platform/x86_64/?/?/files/etc/fonts/conf.d

/var/lib/flatpak/runtime/org.freedesktop.Platform/x86_64/?/?/files/share/fonts

tasksel: Install Group Software

安装

sudo apt install tasksel

list tasks

tasksel --list-tasks

displays description

tasksel --task-desc dns-server

install

sudo apt install dns-server

pacstall

An AUR-inspired package manager for Ubuntu

AppImage

Linux apps that run anywhere

Extract files from an AppImage

unpack: your.AppImage --appimage-extract

Re-package: appimagetool-x86_64.AppImage -v AppDir

解包 AppImage 文件,将 libfcitxplatforminputcontextplugin.so 或 libfcitx5platforminputcontextplugin.so 拷贝到 squashfs-root/usr/plugins/platforminputcontexts 目录下,重新打包。

strings libQt5Core.so.5 | grep "5\."

strings libfcitx5platforminputcontextplugin.so | grep "5\."

包管理器的进化](https://linux.cn/article-9931-1.html)

今天,每个可计算设备都会使用某种软件来完成预定的任务。在软件开发的上古时期,为了找出软件中的 bug 和其它缺陷,软件会被严格的测试。在近十年间,软件被通过互联网来频繁分发,以试图通过持续不断的安装新版本的软件来解决软件的缺陷问题。在很多情况下,每个独立的应用软件都有其自带的更新器。而其它一些软件则让用户自己去搞明白如何获取和升级软件。

Linux 较早采用了维护一个中心化的软件仓库来发布软件更新这种做法,用户可以在这个软件仓库里查找并安装软件。在这篇文章里, 笔者将回顾在 Linux 上的如何进行软件安装的历史,以及现代操作系统如何保持更新以应对软件安全漏洞(CVE)不断的曝光。

手动安装软件

曾几何时,软件都是通过 FTP 或邮件列表(LCTT 译注:即通过邮件列表发布源代码的补丁包)来分发的(最终这些发布方式在互联网的迅猛发展下都演化成为一个个现今常见的软件发布网站)。(一般在一个 tar 文件中)只有一个非常小的文件包含了创建二进制的说明。你需要做的是先解压这个包,然后仔细阅读当中的 README 文件, 如果你的系统上恰好有 GCC(LCTT 译注:GNU C Compiler)或者其它厂商的 C 编译器的话,你得首先运行 ./configure 脚本,并在脚本后添加相应的参数,如库函数的路径、创建可执行文件的路径等等。除此之外,这个配置过程也会检查你操作系统上的软件依赖是否满足安装要求。如果缺失了任何主要的依赖,该配置脚本会退出不再继续安装,直到你满足了该依赖。如果该配置脚本正常执行完毕,将会创建一个 Makefile 文件。

当有了一个 Makefile 文件时, 你就可以接下去执行 make 命令(该命令由你所使用的编译器提供)。make 命令也有很多参数,被称为 make 标识flag,这些标识能为你的系统优化最终生成出来的二进制可执行文件。在计算机世界的早期,这些优化是非常重要的,因为彼时的计算机硬件正在为了跟上软件迅速的发展而疲于奔命。今日今时,编译标识变得更加通用而不是为了优化哪些具体的硬件型号,这得益于现代硬件和现代软件相比已经变得成本低廉,唾手可得。

最后,在 make 完成之后, 你需要运行 make install (或 sudo make install)(LCTT 译注:依赖于你的用户权限) 来“真正”将这个软件安装到你的系统上。可以想象,为你系统上的每一个软件都执行上述的流程将是多么无聊费时,更不用说如果更新一个已经安装的软件将会多复杂,多么需要精力投入。(LCTT 译注:上述流程也称 CMMI 安装, 即Configure、Make、Make Install)

软件包

package(LCTT 译注:下文简称“包”)这个概念是用来解决在软件安装、升级过程中的复杂性的。包将软件安装升级中需要的多个数据文件合并成一个单独的文件,这将便于传输和(通过压缩文件来)减小存储空间(LCTT 译注:减少存储空间这一点在现在已经不再重要),包中的二进制可执行文件已根据开发者所选择的编译标识预编译。包本身包括了所有需要的元数据,如软件的名字、软件的说明、版本号,以及要运行这个软件所需要的依赖包等等。

不同流派的 Linux 发行版都创造了它们自己的包格式,其中最常用的包格式有:

- .deb:这种包格式由 Debian、Ubuntu、Linux Mint 以及其它的变种使用。这是最早被发明的包类型。

- .rpm:这种包格式最初被称作红帽包管理器Red Hat Package Manager(LCTT 译注: 取自英文的首字母)。使用这种包的 Linux 发行版有 Red Hat、Fedora、SUSE 以及其它一些较小的发行版。

- .tar.xz:这种包格式只是一个软件压缩包而已,这是 Arch Linux 所使用的格式。

尽管上述的包格式自身并不能直接管理软件的依赖问题,但是它们的出现将 Linux 软件包管理向前推进了一大步。

软件仓库

多年以前(当智能电话还没有像现在这样流行时),非 Linux 世界的用户是很难理解软件仓库的概念的。甚至今时今日,大多数完全工作在 Windows 下的用户还是习惯于打开浏览器,搜索要安装的软件(或升级包),下载然后安装。但是,智能电话传播了软件“商店”(LCTT 译注: 对应 Linux 里的软件仓库)这样一个概念。智能电话用户获取软件的方式和包管理器的工作方式已经非常相近了。些许不同的是,尽管大多数软件商店还在费力美化它的图形界面来吸引用户,大多数 Linux 用户还是愿意使用命令行来安装软件。总而言之,软件仓库是一个中心化的可安装软件列表,上面列举了在当前系统中预先配置好的软件仓库里所有可以安装的软件。

包管理器

包管理器用来和相应的软件仓库交互,获取软件的相应信息。下面对流行做一个简短介绍。

基于 PRM 包格式的包管理器

更新基于 RPM 的系统,特别是那些基于 Red Hat 技术的系统,有着非常有趣而又详实的历史。实际上,现在的 YUM 版本(用于 企业级发行版)和 DNF(用于社区版)就融合了好几个开源项目来提供它们现在的功能。

Red Hat 最初使用的包管理器,被称为 RPM(红帽包管理器Red Hat Package Manager),时至今日还在使用着。不过,它的主要作用是安装本地的 RPM 包,而不是去在软件仓库搜索软件。后来开发了一个叫 up2date 的包管理器,它被用来通知用户包的最新更新,还能让用户在远程仓库里搜索软件并便捷的安装软件的依赖。尽管这个包管理器尽职尽责,但一些社区成员还是感觉 up2date 有着明显的不足。

现在的 YUM 来自于好几个不同社区的努力。1999-2001 年一群在 Terra Soft Solution 的伙计们开发了Yellowdog Updater(YUP),将其作为 Yellow Dog Linux 图形安装器的后端。杜克大学Duke University喜欢这个主意就决定去增强它的功能,它们开发了Yellowdog Updater, Modified(YUM),这最终被用来帮助管理杜克大学的 Red Hat 系统。Yum 壮大的很快,到 2005 年,它已经被超过一半的 Linux 市场所采用。今日,几乎所有的使用 RPM 的的 Linux 都会使用 YUM 来进行包管理(当然也有一些例外)。

Dandified Yum(DNF)是 YUM 的下一代接班人。从 Fedora 18 开始被作为包管理器引入系统,不过它并没有被企业版所采用,所以它只在 Fedora(以及变种)上占据了主导地位。DNF 的用法和 YUM 几乎一模一样,它主要是用来解决性能问题、晦涩无说明的API、缓慢/不可靠的依赖解析,以及偶尔的高内存占用。DNF 是作为 YUM 的直接替代品来开发的,因此这里笔者就不重复它的用法了,你只用简单的将 yum 替换为 dnf 就行了。

Zypper 是用来管理 RPM 包的另外一个包管理器。这个包管理器主要用于 SUSE(和 openSUSE),在MeeGo、Sailfish OS、Tizen 上也有使用。它最初开发于 2006 年,已经经过了多次迭代。除了作为系统管理工具 YaST 的后端和有些用户认为它比 YUM 要快之外也没有什么好多说的。

基于 Debian 的包管理器

作为一个现今仍在被积极维护的最古老的 Linux 发行版之一,Debian 的包管理系统和基于 RPM 的系统的包管理系统非常类似。它使用扩展名为 “.deb” 的包,这种文件能被一个叫做 dpkg 的工具所管理。dpgk 同 rpm 非常相似,它被设计成用来管理在存在于本地(硬盘)的包。它不会去做包依赖关系解析(它会做依赖关系检查,不过仅此而已),而且在同远程软件仓库交互上也并无可靠的途径。为了提高用户体验并便于使用,Debian 项目开始了一个软件项目:Deity,最终这个代号被丢弃并改成了现在的 Advanced Pack Tool(APT)。

在 1998 年,APT 测试版本发布(甚至早于 1999 年的 Debian 2.1 发布),许多用户认为 APT 是基于 Debian 系统标配功能之一。APT 使用了和 RPM 一样的风格来管理仓库,不过和 YUM 使用单独的 .repo 文件不同,APT 曾经使用 /etc/apt/sources.list 文件来管理软件仓库,后来的变成也可以使用 /etc/apt/sources.d 目录来管理。如同基于 RPM 的系统一样,你也有很多很多选项配置来完成同样的事情。你可以编辑和创建前述的文件,或者使用图形界面来完成上述工作(如 Ubuntu 的“Software & Updates”)。

现今大多数的 Ubuntu 教程里都径直使用了 apt。 单独一个 apt 设计用来实现那些最常用的 APT 命令的。apt 命令看上去是用来整合那些被分散在 apt-get、apt-cache 以及其它一些命令的的功能的。它还加上了一些额外的改进,如色彩、进度条以及其它一些小功能。

基于 Arch 的包管理器

Arch Linux 使用称为 packman 的包管理器。和 .deb 以及 .rpm 不同,它使用更为传统的 LZMA2 压缩包形式 .tar.xz 。这可以使 Arch Linux 包能够比其它形式的压缩包(如 gzip)有更小的尺寸。自从 2002 年首次发布以来, pacman 一直在稳定发布和改善。使用它最大的好处之一是它支持 Arch Build System,这是一个从源代码级别构建包的构建系统。该构建系统借助一个叫 PKGBUILD 的文件,这个文件包含了如版本号、发布号、依赖等等的元数据,以及一个为编译遵守 Arch Linux 需求的包所需要的带有必要的编译选项的脚本。而编译的结果就是前文所提的被 pacman 所使用的 .tar.xz 的文件。

上述的这套系统技术上导致了 Arch User Respository(AUR)的产生,这是一个社区驱动的软件仓库,仓库里包括有 PKGBUILD 文件以及支持补丁或脚本。这给 Arch Linux 带了无穷无尽的软件资源。最为明显的好处是如果一个用户(或开发者)希望他开发的软件能被广大公众所使用,他不必通过官方途径去在主流软件仓库获得许可。而不利之处则是它必须将依赖社区的流程,类似于 Docker Hub、 Canonical 的 Snap Packages(LCTT 译注: Canonical 是 Ubuntu 的发行公司),或者其它类似的机制。

有很多特定于 AUR 的包管理器能被用来从 AUR 里的 PGKBUILD 文件下载、编译、安装。其中 yaourt 和 pacaur 颇为流行。不过,这两个项目已经被 Arch Wiki 列为“不继续开发以及有已知的问题未解决”。因为这个原因,这里直接讨论 aurman,除了会搜索 AUR 以及包含几个有帮助的(其实很危险)的选项之外,它的工作机制和 pacman 极其类似。

conda

简介

Conda 是一个开源的软件包管理系统和环境管理系统,用于安装多个版本的软件包及其依赖关系,并在它们之间轻松切换。 Conda 是为 Python 程序创建的,适用于 Linux,OS X 和 Windows,也可以打包和分发其他软件。

安装

conda分为anaconda和miniconda。anaconda是包含一些常用包的版本(这里的常用不代表你常用),miniconda则是精简版,需要啥装啥,所以推荐使用miniconda。

miniconda官网:https://conda.io/miniconda.html

选择适合自己的版本下载:

wget -c https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

这里选择的是latest-Linux版本,所以下载的程序会随着python的版本更新而更新。

安装:

chmod 777 Miniconda3-latest-Linux-x86_64.sh

bash Miniconda3-latest-Linux-x86_64.sh

加不加入环境变量都可以。所谓的会污染环境等等问题可能都是将大量的软件直接安装在conda的base环境中引起的,只要养成好的使用习惯,灵活使用conda create 命令将不同的软件安装到自己单独的虚拟环境中就可以了。把conda这条蟒蛇关进一个一个的笼子里,才能更好的为我们的科研服务~

添加频道

这个道理跟家里的电视机是一样一样的,安装conda就相当于买了一台电视机,但是有电视了不意味着你就能看节目了,你要手动添加频道才能看你想看的电视节目。

添加清华的镜像channels:

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/conda-forge/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/bioconda/

为了分担清华源镜像的压力,北京外国语大学也开启了镜像站点,同样是由清华TUNA团队维护的,如果有小伙伴遇到清华源速度很慢的情况的话,可以考虑换成北外的镜像。

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/cloud/bioconda/

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/cloud/conda-forge/

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.bfsu.edu.cn/anaconda/pkgs/main/

显示安装的频道

conda config --set show_channel_urls yes

查看已经添加的channels

conda config --get channels

已添加的channel在哪里查看

vim ~/.condarc

软件包管理

conda install gatk

搜索安装包

conda search gatk

安装完成后,可以用“which 软件名”来查看该软件安装的位置:

which gatk

安装特定版本

conda install 软件名=版本号

conda install gatk=3.7

这时conda会先卸载已安装版本,然后重新安装指定版本。

查看已安装软件

conda list

更新指定软件

conda update gatk

卸载指定软件

conda remove gatk

环境管理

退出conda环境

退出也很简单,之前我们是. ./activate 或者 (. ~/miniconda3/bin/activate)现在退出只要:

$ . ./deactivate

# 或者用

$ conda deactivate

就退出当前的环境了

创建conda环境

之前创建的时候显示的是(base)这是conda的基本环境,有些软件依赖的是python2的版本,当你还是使用你的base的时候你的base里的python会被自动降级,有可能会引发别的软件的报错,所以,可以给一些特别的软件一些特别的关照,比如创建一个单独的环境。

在conda环境下,输入conda env list(或者输入conda info --envs也是一样滴)查看当前存在的环境:

conda env list

创建一个新的环境

conda create -n python2 python=2

- -n: 设置新的环境的名字

- python=2 指定新环境的python的版本,非必须参数

- 这里也可以用一个-y参数,可以直接跳过安装的确认过程。

conda会创建一个新的python2的环境,并且会很温馨的提示你只要输入conda activate python2就可以启动这个环境了。

删除环境

conda remove -n myenv --all

重命名环境

实际上conda并没有提供这样的功能,但是可以曲线救国,原理是先克隆一个原来的环境,命名成想要的名字,再把原来的环境删掉即可

接下来演示把一个原来叫做py2的环境重新命名成python2:

conda create -n python2 --clone py2

conda remove -n py2 --all

自动更新

Ubuntu 默认的配置会每天自动安装安全更新而忽略其它包的更新。

更新机制

Ubuntu 默认定义了 4 个 systemd unit 执行更新任务,它们分别是:

/lib/systemd/system/apt-daily-upgrade.service

/lib/systemd/system/apt-daily-upgrade.timer

/lib/systemd/system/apt-daily.service

/lib/systemd/system/apt-daily.timer

中的 apt-daily.timer 和 apt-daily-upgrade.timer 是两个触发器,分别在每天指定的时间触发 apt-daily.service 和 apt-daily-upgrade.service。这两个 service 的类型都是 oneshot,意思是当任务完成后 service 进程退出。这两个 service 其实调用的是同一个脚本: /usr/lib/apt/apt.systemd.daily。apt-daily.service 为脚本传入参数 “update”,其功能为检查系统的更新并下载对应的更新包。apt-daily-upgrade.service 为脚本传入参数 “install”,其功能为安装更新并删除缓存在本地的更新包。

apt-daily.timer 默认每天触发两次,分别为 6 点和 18 点,主要是为了缓解服务器端的下载压力。我们可以根据自身业务的特点设置合适的触发时间。

apt-daily-upgrade.service 默认每天在 6 点触发一次,我们也可以设置为其它时间,比如午夜。

apt.systemd.daily

/usr/lib/apt/apt.systemd.daily 脚本负责完成与更新相关的一系列工作,这些工作主要分为两大块:

- 检查更新并下载更新包

- 安装更新并清理更新包

apt.systemd.daily 脚本中调用 apt-config 命令从 /etc/apt/apt.conf.d/10periodic 文件和 /etc/apt/apt.conf.d/20auto-upgrades 读中取配变量,并根据这些变量的值来控制系统的更新策略。下面我们介绍几个比较重要的配置项。

隔多少天执行一次 apt-get update,默认是 1 天,0 表示不执行该操作:

APT::Periodic::Update-Package-Lists "1";

隔多少天执行一次 apt-get upgrade –download-only 下载更新包,0 表示不执行该操作:

APT::Periodic::Download-Upgradeable-Packages "0";

下载的更新版被缓存在目录 /var/cache/apt/archives/ 中,执行升级操作时直接从缓存目录中读取包文件而不是从网络上下载。

隔多少天执行一次 apt-get autoclean 清除无用的更新包,0 表示不执行该操作:

APT::Periodic::AutocleanInterval "0";

隔多少天执行一次 Unattended-Upgrade 执行系统安全更新(或者所有包的更新),0 表示不执行该操作:

APT::Periodic::Unattended-Upgrade "1";

通过这些配置,我们可以控制自动更新的频率和行为。注意,到目前为止的配置还只能安装系统的安全更新,如果要想安装所有包的更新还需要其它的配置。

在继续介绍后面的内容前,让我们先来了解一下 apt.systemd.daily 脚本中用到的 apt-config 命令和 apt.systemd.daily 脚本依赖的配置文件。

apt-config 命令

apt-config 是一个被 APT 套件使用的内部命令,使用它可以在脚本中提取 /etc/apt/apt.conf 目录下配置文件中的信息。

比如,如果要在脚本中获取 APT::Periodic::Update-Package-Lists 的设置,可以使用下面的代码:

#!/bin/bash

ABC=0

eval $(apt-config shell ABC APT::Periodic::Update-Package-Lists)

echo ${ABC}

此时脚本变量 ABC 中保存的就是 APT::Periodic::Update-Package-Lists 的值。

10periodic 和 20auto-upgrades

/etc/apt/apt.conf.d/10periodic 是 update-notifier-common 的配置文件:

$ dpkg-query -S /etc/apt/apt.conf.d/10periodic

update-notifier-common: /etc/apt/apt.conf.d/10periodic

在 ubuntu 16.04 和 18.04 中,这两个文件的默认内容是一样的。apt.systemd.daily 脚本在注释中说我们可以通过 /etc/apt/apt.conf.d/10periodic 文件自定义相关的变量值,它通过 get-config 命令来获得这些变量的值。但是测试的结果是 /etc/apt/apt.conf.d/20auto-upgrades 文件中的变量会覆盖 /etc/apt/apt.conf.d/10periodic 文件中的变量。看来是 get-config 命令根据文件名称的顺序,排在后面的文件中的变量会覆盖前面文件中的变量。

在 desktop 版本中,通过 GUI 程序修改相关的变量,这两个文件都会被修改并保持一致,所以在 server 版中我们最好也同时修改这两个文件并保持其内容一致。

unattended-upgrades

Ubuntu 实际上是通过 unattended-upgrades 命令来自动安装更新的。Ubuntu 16.04/18.04 默认安装了这个包,如果碰到没有安装的情况你还可以通过下面的命令自行安装:

sudo apt install unattended-upgrades

unattended-upgrades 的配置文件为 /etc/apt/apt.conf.d/50unattended-upgrades。

注意,unattended-upgrades 不仅能够安装系统的安全更新,还可以安装所有包的更新。但是默认的配置只安装安全更新,我们可以通过配置项让 unattended-upgrades 安装所有的包更新或者只安装安全更新。

unattended-upgrades 命令被设计为通过 cron 定时执行系统更新,但在 Ubuntu 16.04/18.04 中是通过 systemd 的 timer unit 定时触发 service unit 执行的。

unattended-upgrades 命令的日志文件存放在 /var/log/unattended-upgrades 目录下。

unattended-upgrade 命令常见的用法之一是检查系统是否有更新:

sudo unattended-upgrade --dry-run

另一种用法是安装更新:

sudo unattended-upgrade

在 apt.systemd.daily 脚本中执行 unattended-upgrade 命令时,由于更新包已经提前下载到缓存目录了(/var/cache/apt/archives),所以直接它直接使用缓存中的更新包。

配置文件 50unattended-upgrades

50unattended-upgrades 文件中的默认配置只是安装安全更新:

Unattended-Upgrade::Allowed-Origins {

"${distro_id}:${distro_codename}";

"${distro_id}:${distro_codename}-security";

"${distro_id}ESM:${distro_codename}";

// "${distro_id}:${distro_codename}-updates";

// "${distro_id}:${distro_codename}-proposed";

// "${distro_id}:${distro_codename}-backports";

};

如果要自动安装所有包的更新,只要取消下面行的注释就行了:

"${distro_id}:${distro_codename}-updates";

我们还可以通过黑名单的方式指定不更新哪些包:

Unattended-Upgrade::Package-Blacklist {

"vim";

"libc6";

"libc6-dev";

"libc6-i686";

};

下面的配置项指定在更新后移除无用的包:

Unattended-Upgrade::Remove-Unused-Kernel-Packages "true";

Unattended-Upgrade::Remove-Unused-Dependencies "true";

有些更新需要重启系统,而默认的配置是不重启系统的。下面的配置允许重启系统(更新完成后,如果需要重启,立即重启系统):

Unattended-Upgrade::Automatic-Reboot "true";

但是多数情况下我们更期望指定一个时间让系统重启(如果需要重启,在下面配置中指定的时间重启系统):

Unattended-Upgrade::Automatic-Reboot-Time "02:38";

在系统更新的过程中发生了错误怎么办?当然是通知管理员啦!下面的配置在发生错误时给管理员发送邮件:

Unattended-Upgrade::Mail "user@example.com";

Unattended-Upgrade::MailOnlyOnError "true";

注意:如果要向外网发送邮件,需要安装 mailx 等工具。

关闭自动更新

如果你的主机运行在封闭的环境中,并且无法连接到有效的更新源,此时可以选择关闭自动更新功能。首选的方法是停止相关的服务:

sudo systemctl stop apt-daily.service

sudo systemctl stop apt-daily.timer

sudo systemctl stop apt-daily-upgrade.service

sudo systemctl stop apt-daily-upgrade.timer

sudo systemctl disable apt-daily.service

sudo systemctl disable apt-daily.timer

sudo systemctl disable apt-daily-upgrade.service

sudo systemctl disable apt-daily-upgrade.timer

或者修改自动更新程序的配置文件也可以,同时更新 /etc/apt/apt.conf.d/10periodic 和 /etc/apt/apt.conf.d/20auto-upgrades:

APT::Periodic::Update-Package-Lists "1";

APT::Periodic::Unattended-Upgrade "1";

改为

APT::Periodic::Update-Package-Lists "0";

APT::Periodic::Unattended-Upgrade "0";

文件系统

fstab

/etc/fstab是用来存放文件系统的静态信息的文件。当系统启动的时候,系统会自动地从这个文件读取信息,并且会自动将此文件中指定的文件系统挂载到指定的目录。

查看/etc/fstab

# cat /etc/fstab

<file system> <dir> <type> <options> <dump> <pass>

tmpfs /tmp tmpfs nodev,nosuid 0 0

/dev/sda1 / ext4 defaults,noatime 0 1

/dev/sda2 none swap defaults,nodelalloc 0 0

/dev/sda3 /home ext4 defaults,noatime 0 2

分别解释一下各字段的用处:

<file system>要挂载的分区或存储设备<dir>挂载的目录位置<type>挂载分区的文件系统类型,比如:ext3、ext4、xfs、swap<options>挂载使用的参数有哪些。举例如下:- auto - 在启动时或键入了 mount -a 命令时自动挂载。

- noauto - 只在你的命令下被挂载。

- exec - 允许执行此分区的二进制文件。

- noexec - 不允许执行此文件系统上的二进制文件。

- ro - 以只读模式挂载文件系统。

- rw - 以读写模式挂载文件系统。

- user - 允许任意用户挂载此文件系统,若无显示定义,隐含启用 noexec, nosuid, nodev 参数。

- users - 允许所有 users 组中的用户挂载文件系统.

- nouser - 只能被 root 挂载。

- owner - 允许设备所有者挂载。

- sync - I/O 同步进行。

- async - I/O 异步进行。

- dev - 解析文件系统上的块特殊设备。

- nodev - 不解析文件系统上的块特殊设备。

- suid - 允许 suid 操作和设定 sgid 位。这一参数通常用于一些特殊任务,使一般用户运行程序时临时提升权限。

- nosuid - 禁止 suid 操作和设定 sgid 位。

- noatime - 不更新文件系统上 inode 访问记录,可以提升性能。

- nodiratime - 不更新文件系统上的目录 inode 访问记录,可以提升性能(参见 atime 参数)。

- relatime - 实时更新 inode access 记录。只有在记录中的访问时间早于当前访问才会被更新。(与

- noatime 相似,但不会打断如 mutt 或其它程序探测文件在上次访问后是否被修改的进程。),可以提升性能。

- flush - vfat 的选项,更频繁的刷新数据,复制对话框或进度条在全部数据都写入后才消失。

- defaults - 使用文件系统的默认挂载参数,例如 ext4 的默认参数为:rw, suid, dev, exec, auto, nouser, async.

<dump>dump 工具通过它决定何时作备份。dump 会检查其内容,并用数字来决定是否对这个文件系统进行备份。 允许的数字是 0 和 1 。0 表示忽略, 1 则进行备份。大部分的用户是没有安装 dump 的 ,对他们而言<dump>应设为 0。<pass>fsck 读取<pass>的数值来决定需要检查的文件系统的检查顺序。允许的数字是0, 1, 和2。 根目录应当获得最高的优先权 1, 其它所有需要被检查的设备设置为 2。 0 表示设备不会被 fsck 所检查。

示例:

/dev/sda1 /mnt/LinuxOSBuckup ext4 defaults 0 2

UUID of Storage Devices

Finding UUID with blkid

sudo blkid

Finding UUID with ls

ls -l /dev/disk/by-uuid

Finding UUID with lsblk

sudo lsblk -f

LVM

在对磁盘分区的大小进行规划时,往往不能确定这个分区要使用的空间的大小。而使用 fdisk、gdisk 等工具对磁盘分区后,每个分区的大小就固定了。如果分区设置的过大,就白白浪费了磁盘空间;如果分区设置的过小,就会导致空间不够用的情况出现。对于分区过小的问题,可以从新划分磁盘的分区,或者通过软连接的方式将此分区的目录链接到另外一个分区。这样虽然能够临时解决问题,但是给管理带来了麻烦。类似的问题可以通过 LVM 来解决。

LVM 是什么

LVM 是 Logical Volume Manager 的缩写,中文一般翻译为 “逻辑卷管理”,它是 Linux 下对磁盘分区进行管理的一种机制。LVM 是建立在磁盘分区和文件系统之间的一个逻辑层,系统管理员可以利用 LVM 在不重新对磁盘分区的情况下动态的调整分区的大小。如果系统新增了一块硬盘,通过 LVM 就可以将新增的硬盘空间直接扩展到原来的磁盘分区上。

LVM 的优点如下:

- 文件系统可以跨多个磁盘,因此大小不再受物理磁盘的限制。

- 可以在系统运行状态下动态地扩展文件系统大小。

- 可以以镜像的方式冗余重要数据到多个物理磁盘上。

- 可以很方便地导出整个卷组,并导入到另外一台机器上。

LVM 也有一些缺点:

- 在从卷组中移除一个磁盘的时候必须使用 reducevg 命令(这个命令要求root权限,并且不允许在快照卷组中使用)。

- 当卷组中的一个磁盘损坏时,整个卷组都会受影响。

- 因为增加了一个逻辑层,存储的性能会受影响。

LVM 的优点对服务器的管理非常有用,但对于桌面系统的帮助则没有那么显著,所以需要我们根据使用的场景来决定是否应用 LVM。

LVM 中的基本概念

通过 LVM 技术,可以屏蔽掉磁盘分区的底层差异,在逻辑上给文件系统提供了一个卷的概念,然后在这些卷上建立相应的文件系统。下面是 LVM 中主要涉及的一些概念。

- **物理存储设备(Physical Media):**指系统的存储设备文件,比如 /dev/sda、/dev/sdb 等。

- **PV(物理卷 Physical Volume):**指硬盘分区或者从逻辑上看起来和硬盘分区类似的设备(比如 RAID 设备)。

- **VG(卷组 Volume Group):**类似于非 LVM 系统中的物理硬盘,一个 LVM 卷组由一个或者多个 PV(物理卷)组成。

- **LV(逻辑卷 Logical Volume):**类似于非 LVM 系统上的磁盘分区,LV 建立在 VG 上,可以在 LV 上建立文件系统。

- **PE(Physical Extent):**PV(物理卷)中可以分配的最小存储单元称为 PE,PE 的大小是可以指定的。

- **LE(Logical Extent):**LV(逻辑卷)中可以分配的最小存储单元称为 LE,在同一个卷组中,LE 的大小和 PE 的大小是一样的,并且一一对应。

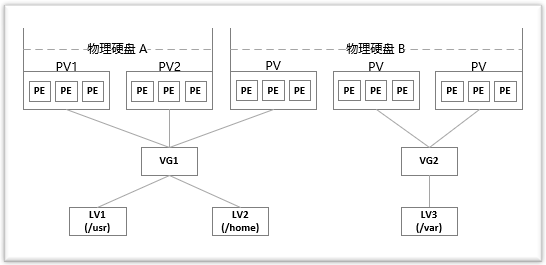

可以这么理解,LVM 是把硬盘的分区分成了更小的单位(PE),再用这些单元拼成更大的看上去像分区的东西(PV),进而用 PV 拼成看上去像硬盘的东西(VG),最后在这个新的硬盘上创建分区(LV)。文件系统则建立在 LV 之上,这样就在物理硬盘和文件系统中间添加了一层抽象(LVM)。下图大致描述了这些概念之间的关系:

对上图中的结构做个简单的介绍:

两块物理硬盘 A 和 B 组成了 LVM 的底层结构,这两块硬盘的大小、型号可以不同。PV 可以看做是硬盘上的分区,因此可以说物理硬盘 A 划分了两个分区,物理硬盘 B 划分了三个分区。然后将前三个 PV 组成一个卷组 VG1,后两个 PV 组成一个卷组 VG2。接着在卷组 VG1 上划分了两个逻辑卷 LV1 和 LV2,在卷组 VG2 上划分了一个逻辑卷 LV3。最后,在逻辑卷 LV1、LV2 和 LV3 上创建文件系统,分别挂载在 /usr、/home 和 /var 目录。

LVM 工具

在安装 Linux 时,如果选择使用 LVM 创建分区,就会安装 LVM 相关的工具。当前这个软件包的名称为 lvm2,其中包含了大量 LVM 工具。比如单是查看 LVM 相关实体状态的命令就有如下一些:

sudo pvscan

sudo pvs

sudo pvdisplay

sudo vgscan

sudo vgs

sudo vgdisplay

sudo lvscan

sudo lvs

sudo lvdisplay

如果安装系统时没有默认安装 LVM 工具包,可以通过下面的命令安装它们:

sudo apt update

sudo apt install lvm2

接下来我们通过例子来演示如何使用 LVM 来一步步的创建出逻辑卷(LV),然后在 LV 上创建文件系统并挂载到 Linux 系统中。

使用 gdisk 对物理磁盘进行分区

目前常见的磁盘分区格式有两种,MBR 分区和 GPT 分区。

MBR 分区,MBR 的意思是 “主引导记录”。MBR 最大支持 2TB 容量,在容量方面存在着极大的瓶颈。

GPT 分区,GPT 意为 GUID 分区表,它支持的磁盘容量比 MBR 大得多。这是一个正逐渐取代 MBR 的新标准,它是由 UEFI 辅住而形成的,将来 UEFI 用于取代老旧的 BIOS,而 GPT 则取代老旧的 MBR。

使用 fdisk 工具创建 MBR 磁盘分区,而 gdisk 是 Linux 系统中 GPT 格式的磁盘分区管理工具。

假设我们的 Linux 系统中增加了一块新的磁盘,系统对应的设备名为 /dev/sdb,下面我们通过 gdisk 命令对这个磁盘进行分区。

在用 gdisk 命令对磁盘分区前,我们先用 parted 命令查看 /dev/sdb 当前的分区情况:

sudo parted /dev/sdb print

下面通过 gdisk 命令创建分区:

sudo gdisk /dev/sdb

通过 p 命令可以查看磁盘当前的状态:输出中的前几行是磁盘的基本信息,比如总大小,一共有多少个扇区(sector),每个扇区的大小,当前剩余的空间等等。

然后是已经存在的分区信息:

- 第一列 Number 显示了分区的编号,比如 1 号指 /dev/sdb1。

- 第二列 Start 表示磁盘分区的起始位置。

- 第三列 End 表示磁盘分区的结束位置。

- 第四列 Size 显示分区的容量。

- 第五列 Code 和第六列 Name 显示分区类型的 ID和名称,比如 Linux filesystem 为 8300,Linux swap 为 8200,Linux LVM 为 8e00。

通过 n 命令来创建新分区:

分区编号和开始/结束的扇区都直接通过回车选择默认值,这样所有的磁盘空间都划分到了一个分区中,然后输入 8e00 说明我们要创建的分区类型为 Linux LVM。最后输入 w 命令并确认执行分区操作。分区成功后可通过 p 命令查看我们创建的分区的信息。

创建物理卷 PV

# pvcreate DEVICE

现在我们可以基于磁盘分区 /dev/sdb1 来创建 LVM 物理卷(LV),可以通过 pvcreate 命令来完成:

sudo pvcreate /dev/sdb1

此时 /dev/sdb1 已经完成了从磁盘分区到 PV 的华丽转身!注意上面的命令,磁盘分区被直接转换成了 PV,连名称都没有变化!我们可以通过 pvs 命令查看 /dev/sdb1,目前它还没有被加入到 VG 中。

创建卷组 VG

# vgcreate <volume_group> <physical_volume1> <physical_volume2> ...

基于一个或多个 PV,可以创建 VG。我们使用刚才创建的 PV /dev/sdb1 来创建一个名称为 nickvg 的 VG:

sudo vgcreate -s 32G nickvg /dev/sdb1

注意 vgcreate 命令中的 -s 选项,它指定了 PE(Physical Extent) 的大小。可以通 vgs 命令观察 VG 的信息:

sudo vgs nickvg

如果目标 VG 已经存在,则使用 vgextend 把 PV 加入到 VG 中即可。

# vgextend <卷组名> <物理卷>

创建逻辑卷 LV

# lvcreate -L <卷大小> <卷组名> -n <卷名>

有了 VG 就可以创建逻辑卷 LV 了,lvcreate 命令用来创建 LV,让我们在前面创建的 nickvg 上创建名称为 nicklv00 的 LV:

sudo lvcreate -L 15G -n nicklv00 nickvg

选项 -L 指定新建 LV 的容量,这里是 15G;选项 -n 则指定新建 LV 的名称,这里为 nicklv00。可以通过 lvs 命令观察 LV 的信息,注意需要同时指出 LV 所在的 VG:

sudo lvs nickvg/nicklv00

如果你想让要创建的逻辑卷拥有卷组(VG)的所有未使用空间,请使用以下命令:

# lvcreate -l +100%FREE <volume_group> -n <logical_volume>

格式化逻辑卷(创建文件系统)

# mkfs.<类型> /dev/mapper/<卷组名>-<卷名>

# mount /dev/mapper/<卷组名>-<卷名> <挂载点>

当我们创建 LV nickvg/nicklv00 时,其实是创建了名称为 /dev/nickvg/nicklv00 的设备文件。

现在你的逻辑卷应该已经在/dev/mapper/和/dev/YourVolumeGroupName中了。

现在我们来格式化这个逻辑卷(在该 LV 上创建文件系统),目标为比较常见的 ext4 格式:

sudo mkfs.ext4 /dev/nickvg/nicklv00

然后创建个目录,比如 /home/doc,并把新建的文件系统挂载到这个目录上:

sudo mkdir /home/doc

sudo mount /dev/nickvg/nicklv00 /home/doc

最后可以通过 df 命令查看这个文件系统的使用情况。

开机自动挂载

编辑 /etc/fstab 文件:

sudo vim /etc/fstab

把下面的行添加的文件末尾并保存文件:

/dev/mapper/nickvg-nicklv00 /home/doc ext4 defaults 0 2

调整逻辑卷

同时缩小逻辑卷和其文件系统

注意: 只有ext2,ext3,ext4,ReiserFS和 XFS 文件系统支持以下操作。

将MyVolGroup组中的逻辑卷mediavol扩大10GiB,并同时扩大其文件系统:

# lvresize -L +10G --resizefs MyVolGroup/mediavol

将MyVolGroup组中的逻辑卷mediavol大小调整为15GiB,并同时调整其文件系统:

# lvresize -L 15G --resizefs MyVolGroup/mediavol

将卷组中的所有剩余空间分配给mediavol:

# lvresize -l +100%FREE --resizefs MyVolGroup/mediavol

重命名卷

重命名卷组

要重命名一个卷组,请使用vgrename(8)命令。

可使用下面的任意一条命令将卷组vg02重命名为my_volume_group

# vgrename /dev/vg02 /dev/my_volume_group

# vgrename vg02 my_volume_group

重命名逻辑卷

要重命名一个逻辑卷,请使用lvrename(8)命令。

可使用下面的任意一条命令将vg02组中的逻辑卷lvold重命名为lvnew.

# lvrename /dev/vg02/lvold /dev/vg02/lvnew

# lvrename vg02 lvold lvnew

移除逻辑卷

警告: 在移除逻辑卷之前,请先备份好数据以免丢失!

首先,找到你所要移除的逻辑卷的名称。你可以使用以下命令来查看系统的所有逻辑卷:

# lvs

接下来,找到你所要移除的逻辑卷的挂载点

lsblk

并卸载它:

# umount /<mountpoint>

最后,使用以下命令来移除逻辑卷:

# lvremove <volume_group>/<logical_volume>

例如:

# lvremove VolGroup00/lvolhome

请输入y来确定你要执行移除逻辑卷操作。

此外,请不要忘了更新/etc/fstab。

你可以再次使用lvs命令来确认你的逻辑卷已被移除。

LVM 快照

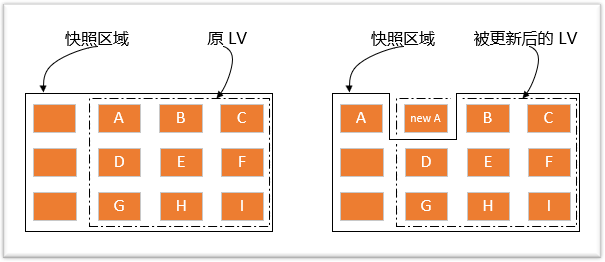

LVM 机制还提供了对 LV 做快照的功能,也就是说可以给文件系统做一个备份,这也是设计 LVM 快照的主要目的。LVM 的快照功能采用写时复制技术(Copy-On-Write,COW),这比传统的备份技术的效率要高很多。创建快照时不用停止服务,就可以对数据进行备份。说明:LVM 还支持 thin 类型的快照,但是本文中的快照都是指 COW 类型的快照。

LVM 采用的写时复制,是指当 LVM 快照创建的时候,仅创建到实际数据的 inode 的硬链接(hark-link)而已。只要实际的数据没有改变,快照就只包含指向数据的 inode 的指针,而非数据本身。快照会跟踪原始卷中块的改变,一旦你更改了快照对应的文件或目录,这个时候原始卷上将要改变的数据会在改变之前拷贝到快照预留的空间。

LVM 快照的原理

创建快照实际上也是创建了一个逻辑卷,只不过该卷的属性与普通逻辑卷的属性有些不一样。我们可以通过下图来理解快照数据卷(图中的实线框表示快照区域,虚线框表示文件系统):

左图为最初创建的快照数据卷状况,LVM 会预留一个区域 (比如左图的左侧三个 PE 区块) 作为数据存放处。 此时快照数据卷内并没有任何数据,而快照数据卷与源数据卷共享所有的 PE 数据, 因此你会看到快照数据卷的内容与源数据卷中的内容是一模一样的。 等到系统运行一阵子后,假设 A 区域的数据被更新了(上面右图所示),则更新前系统会将该区域的数据移动到快照数据卷中, 所以在右图的快照数据卷中被占用了一块 PE 成为 A,而其他 B 到 I 的区块则还是与源数据卷共享!

由於快照区与原本的 LV 共享很多 PE 区块,因此快照区与被快照的 LV 必须要在同一个 VG 上头,下面两点非常重要:

- VG中需要预留存放快照本身的空间,不能全部被占满。

- 快照所在的 VG 必须与被备份的 LV 的 VG 相同,否则创建快照会失败。

创建 LVM 快照

其实快照就是一个特殊类型的数据卷,所以创建快照的命令和创建数据卷的命令相同,也是 lvcreate:

# lvcreate --size 100M --snapshot --name snap01 /dev/vg0/lv

此时如果把 LV snap01 挂载到系统中,里面的内容和 LV /dev/vg0/lv 中的内容是一样的。

创建的快照的大小可以比源数据卷小,但是当源数据卷中的数据更新过多时会导致快照容量不足而引起的错误并丢失数据。如上你可以修改少于100M的数据,直到该快照逻辑卷空间不足为止。

创建快照后,如果源数据卷中的文件被更新了,快照系统中则保存着其创建快照时的版本。

还原部分数据

如果我们明确的知道需要还原某个文件,可以挂载快照数据卷,直接拷贝其中旧版本的文件即可。

合并快照(merge snapshot)

要将逻辑卷卷’lv' 恢复到创建快照’snap01’时的状态,即还原整个数据卷上的数据,请使用:

# lvconvert --merge /dev/vg0/snap01

如果逻辑卷处于活动状态,则在下次重新启动时将进行合并(merging)(合并(merging)甚至可在LiveCD中进行)。

注意: 合并后快照将被删除。

可以拍摄多个快照,每个快照都可以任意与对应的逻辑卷合并。

快照可以被挂载,并可用dd或者tar备份。使用dd备份的快照的大小为拍摄快照后对应逻辑卷中变更过文件的大小。 要使用备份,只需创建并挂载一个快照,并将备份写入或解压到其中。再将快照合并到对应逻辑卷即可。

快照主要用于提供一个文件系统的拷贝,以用来备份; 比起直接备份分区,使用快照备份可以提供一个更符合原文件系统的镜像。

ZFS

历史

ZFS 是由 Matthew Ahrens 和 Jeff Bonwick 在 2001 年开发的。ZFS 是作为 Sun MicroSystem 公司的 OpenSolaris 的下一代文件系统而设计的。在 2008 年,ZFS 被移植到了 FreeBSD 。同一年,一个移植 ZFS on Linux 的项目也启动了。然而,由于 ZFS 是CDDL 许可的,它和 GPL 不兼容,因此不能将它迁移到 Linux 内核中。为了解决这个问题,绝大多数 Linux 发行版提供了一些方法来安装 ZFS 。

在甲骨文公司收购太阳微系统公司之后不久,OpenSolaris 就闭源了,这使得 ZFS 的之后的开发也变成闭源的了。许多 ZFS 开发者对这件事情非常不满。三分之二的 ZFS 核心开发者,包括 Ahrens 和 Bonwick,因为这个决定而离开了甲骨文公司。他们加入了其它公司,并于 2013 年 9 月创立了 OpenZFS 这一项目。该项目引领着 ZFS 的开源开发。

让我们回到上面提到的许可证问题上。既然 OpenZFS 项目已经和 Oracle 公司分离开了,有人可能好奇他们为什么不使用和 GPL 兼容的许可证,这样就可以把它加入到 Linux 内核中了。根据 OpenZFS 官网 的介绍,更改许可证需要联系所有为当前 OpenZFS 实现贡献过代码的人(包括初始的公共 ZFS 代码以及 OpenSolaris 代码),并得到他们的许可才行。这几乎是不可能的(因为一些贡献者可能已经去世了或者很难找到),因此他们决定保留原来的许可证。

特性

正如前面所说过的,ZFS 是一个先进的文件系统。因此,它有一些有趣的特性。

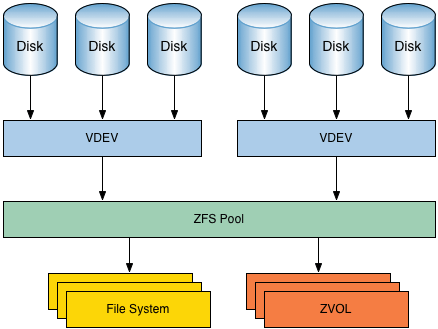

存储池

与大多数文件系统不同,ZFS 结合了文件系统和卷管理器的特性。这意味着,它与其他文件系统不同,ZFS 可以创建跨越一系列硬盘或池的文件系统。不仅如此,你还可以通过添加硬盘来增大池的存储容量。ZFS 可以进行分区和格式化。

写时拷贝

Copy-on-write 是另一个有趣并且很酷的特性。在大多数文件系统上,当数据被重写时,它将永久丢失。而在 ZFS 中,新数据会写到不同的块。写完成之后,更新文件系统元数据信息,使之指向新的数据块(LCTT 译注:更新之后,原数据块成为磁盘上的垃圾,需要有对应的垃圾回收机制)。这确保了如果在写新数据的时候系统崩溃(或者发生其它事,比如突然断电),那么原数据将会保存下来。这也意味着,在系统发生崩溃之后,不需要运行 fsck 来检查和修复文件系统。

快照

写时拷贝使得 ZFS 有了另一个特性:snapshots。ZFS 使用快照来跟踪文件系统中的更改。快照包含文件系统的原始版本(文件系统的一个只读版本),实时文件系统则包含了自从快照创建之后的任何更改。没有使用额外的空间。因为新数据将会写到实时文件系统新分配的块上。如果一个文件被删除了,那么它在快照中的索引也会被删除。所以,快照主要是用来跟踪文件的更改,而不是文件的增加和创建。

快照可以挂载成只读的,以用来恢复一个文件的过去版本。实时文件系统也可以回滚到之前的快照。回滚之后,自从快照创建之后的所有更改将会丢失。

数据完整性验证和自动修复

当向 ZFS 写入新数据时,会创建该数据的校验和。在读取数据的时候,使用校验和进行验证。如果前后校验和不匹配,那么就说明检测到了错误,然后,ZFS 会尝试自动修正错误。

RAID-Z

ZFS 不需要任何额外软件或硬件就可以处理 RAID(磁盘阵列)。毫不奇怪,因为 ZFS 有自己的 RAID 实现:RAID-Z 。RAID-Z 是 RAID-5 的一个变种,不过它克服了 RAID-5 的写漏洞:意外重启之后,数据和校验信息会变得不同步(LCTT 译注:RAID-5 的条带在正写入数据时,如果这时候电源中断,那么奇偶校验数据将跟该部分数据不同步,因此前边的写无效;RAID-Z 用了 “可变宽的 RAID 条带” 技术,因此所有的写都是全条带写入)。为了使用基本级别的 RAID-Z(RAID-Z1),你需要至少三块磁盘,其中两块用来存储数据,另外一块用来存储奇偶校验信息。而 RAID-Z2 需要至少两块磁盘存储数据以及两块磁盘存储校验信息。RAID-Z3 需要至少两块磁盘存储数据以及三块磁盘存储校验信息。另外,只能向 RAID-Z 池中加入偶数倍的磁盘,而不能是奇数倍的。

巨大的存储潜力

创建 ZFS 的时候,它是作为最后一个文件系统而设计的 。那时候,大多数文件系统都是 64 位的,ZFS 的创建者决定直接跳到 128 位,等到将来再来证明这是对的。这意味着 ZFS 的容量大小是 32 位或 64 位文件系统的 1600 亿亿倍。事实上,Jeff Bonwick(其中一个创建者)说:“完全填满一个 128 位的存储池所需要的能量,从字面上讲,比煮沸海洋需要的还多。”

如何安装 ZFS?

如果你想立刻使用 ZFS(开箱即用),那么你需要安装 FreeBSD 或一个使用 illumos 内核的操作系统。illumos 是 OpenSolaris 内核的一个克隆版本。

事实上,支持 ZFS 是一些有经验的 Linux 用户选择 BSD 的主要原因。

如果你想在 Linux 上尝试 ZFS,那么只能在存储文件系统上使用。据我所知,没有任何 Linux 发行版可以在根目录上安装 ZFS,实现开箱即用。如果你对在 Linux 上尝试 ZFS 感兴趣,那么 ZFS on Linux 项目 上有大量的教程可以指导你怎么做。

在 Ubuntu 上使用 ZFS

如果您正在考虑将 ZFS 用于您的超高速 NVMe SSD,这可能不是一个最佳选择。 它比别的文件系统要慢,不过,这完全没有问题, 它旨在存储大量的数据并保持安全。

sudo apt-get install zfsutils-linux

创建池

在 ZFS 中,池大致相当于 RAID 。 它们很灵活且易于操作。

RAID0

RAID0 只是把你的硬盘集中到一个池子里面,就像一个巨大的驱动器一样。 它可以提高你的驱动器速度,(LCTT 译注:数据条带化后,并行访问,可以提高文件读取速度)但是如果你的驱动器有损坏,你可能会失丢失数据。

在计算机数据存储中,数据条带化是一种对逻辑顺序数据(例如文件)进行分段的技术,以便将连续的段存储在不同的物理存储设备上。

要使用 ZFS 实现 RAID0,只需创建一个普通的池。

sudo zpool create your-pool /dev/sdc /dev/sdd

RAID1(镜像)

您可以在 ZFS 中使用 mirror 关键字来实现 RAID1 功能。 RAID1 会创建一个一对一的驱动器副本。 这意味着您的数据一直在备份。 它也提高了性能。 当然,你将一半的存储空间用于了复制。

sudo zpool create your-pool mirror /dev/sdc /dev/sdd

RAID5/RAIDZ1

ZFS 将 RAID5 功能实现为 RAIDZ1。 RAID5 要求驱动器至少是 3 个。并允许您通过将备份奇偶校验数据写入驱动器空间的 1/n(n 是驱动器数),留下的是可用的存储空间。 如果一个驱动器发生故障,阵列仍将保持联机状态,但应尽快更换发生故障的驱动器(LCTT 译注:与原文翻译略有不同,原文是驱动器的数目是三的倍数,根据 wiki, RAID5 至少需要 3 块驱动器,也可以从下面的命令中猜测)。

sudo zpool create your-pool raidz1 /dev/sdc /dev/sdd /dev/sde

RAID6/RAIDZ2

RAID6 与 RAID5 几乎完全相同,但它至少需要四个驱动器。 它将奇偶校验数据加倍,最多允许两个驱动器损坏,而不会导致阵列关闭(LCTT 译注:这里也与原文略有出入,原文是驱动器的数目是四的倍数,根据 wiki ,RAID6 至少需要四个驱动器)。

sudo zpool create your-pool raidz2 /dev/sdc /dev/sdd /dev/sde /dev/sdf

RAID10(条带化镜像)

RAID10 旨在通过数据条带化提高存取速度和数据冗余来成为一个两全其美的解决方案。 你至少需要四个驱动器,但只能使用一半的空间。 您可以通过在同一个池中创建两个镜像来创建 RAID10 中的池(LCTT 译注:这里也与原文略有出入,原文是驱动器的数目是四的倍数,根据 wiki, RAID10 至少需要四个驱动器)。

sudo zpool create your-pool mirror /dev/sdc /dev/sdd mirror /dev/sde /dev/sdf

池的操作

还有一些管理工具,一旦你创建了你的池,你就必须使用它们来操作。 首先,检查你的池的状态。

sudo zpool status

更新

当你更新 ZFS 时,你也需要更新你的池。 当您检查它们的状态时,您的池会通知您任何更新。 要更新池,请运行以下命令。

sudo zpool upgrade your-pool

你也可以更新全部池。

sudo zpool upgrade -a

添加驱动器

您也可以随时将驱动器添加到池中。 告诉 zpool 池的名称和驱动器的位置,它会处理好一切。

sudo zpool add your-pool /dev/sdx

实例

使用两块硬盘上的等容量分区建立 raid 1。

$ ls -l /dev/disk/by-id

usb-JMicron_Generic_DISK00_0123456789ABCDEF-0:0-part1 -> ../../sdb1

usb-JMicron_Generic_DISK01_0123456789ABCDEF-0:1-part2 -> ../../sdc2

$ sudo zpool create -f -o ashift=12 -o cachefile=/etc/zfs/zpool.cache -O compression=lz4 -O xattr=sa -O relatime=on -O acltype=posixacl -O dedup=off -m none dpool mirror usb-JMicron_Generic_DISK00_0123456789ABCDEF-0:0-part1 usb-JMicron_Generic_DISK01_0123456789ABCDEF-0:1-part2

$ sudo zfs create -o mountpoint=none -o canmount=off dpool/DATA

$ sudo zfs create -o mountpoint=/home/kurome/DataPool dpool/DATA/important

$ sudo zpool export dpool

$ sudo zpool import dpool

udev

如果你使用Linux比较长时间了,那你就知道,在对待设备文件这块,Linux改变了几次策略。在Linux早期,设备文件仅仅是是一些带有适当的属性集的普通文件,它由mknod命令创建,文件存放在/dev目录下。后来,采用了devfs, 一个基于内核的动态设备文件系统,他首次出现在2.3.46内核中。Mandrake,Gentoo等Linux分发版本采用了这种方式。devfs创建 的设备文件是动态的。但是devfs有一些严重的限制,从2.6.13版本后移走了。目前取代他的便是文本要提到的udev--一个用户空间程序。

目前很多的Linux分发版本采纳了udev的方式,因为它在Linux设备访问,特别是那些对设备有极端需求的站点(比如需要控制上千个硬盘)和热插拔设备(比如USB摄像头和MP3播放器)上解决了几个问题。下面我我们来看看如何管理udev设备。

实际上,对于那些为磁盘,终端设备等准备的标准配置文件而言,你不需要修改什么。但是,你需要了解udev配置来使用新的或者外来设备,如果不修改配置, 这些设备可能无法访问,或者说Linux可能会采用不恰当的名字,属组或权限来创建这些设备文件。你可能也想知道如何修改RS-232串口,音频设备等文件的属组或者权限。这点在实际的Linux实施中是会遇到的。

为什么使用udev

在此之前的设备文件管理方法(静态文件和devfs)有几个缺点:

- 不确定的设备映射。特别是那些动态设备,比如USB设备,设备文件到实际设备的映射并不可靠和确定。举一个例子:如果你有两个USB打印机。一个可能称 为/dev/usb/lp0,另外一个便是/dev/usb/lp1。但是到底哪个是哪个并不清楚,lp0,lp1和实际的设备没有一一对应的关系,因为 他可能因为发现设备的顺序,打印机本身关闭等原因而导致这种映射并不确定。理想的方式应该是:两个打印机应该采用基于他们的序列号或者其他标识信息的唯一 设备文件来映射。但是静态文件和devfs都无法做到这点。

- 没有足够的主/辅设备号。我们知道,每一个设备文件是有两个8位的数字:一个是主设备号 ,另外一个是辅设备号来分配的。这两个8位的数字加上设备类型(块设备或者字符设备)来唯一标识一个设备。不幸的是,关联这些身边的的数字并不足够。

- /dev目录下文件太多。一个系统采用静态设备文件关联的方式,那么这个目录下的文件必然是足够多。而同时你又不知道在你的系统上到底有那些设备文件是激活的。

- 命名不够灵活。尽管devfs解决了以前的一些问题,但是它自身又带来了一些问题。其中一个就是命名不够灵活;你别想非常简单的就能修改设备文件的名字。缺省的devfs命令机制本身也很奇怪,他需要修改大量的配置文件和程序。

- 内核内存使用,devfs特有的另外一个问题是,作为内核驱动模块,devfs需要消耗大量的内存,特别当系统上有大量的设备时(比如上面我们提到的系统一个上有好几千磁盘时)

udev的目标是想解决上面提到的这些问题,他通采用用户空间(user-space)工具来管理/dev/目录树,他和文件系统分开。知道如何改变缺省配置能让你之大如何定制自己的系统,比如创建设备字符连接,改变设备文件属组,权限等。

udev配置文件

主要的udev配置文件是/etc/udev/udev.conf。这个文件通常很短,他可能只是包含几行#开头的注释,然后有几行选项:

udev_root=“/dev/”

udev_rules=“/etc/udev/rules.d/”

udev_log=“err“

上面的第二行非常重要,因为他表示udev规则存储的目录,这个目录存储的是以.rules结束的文件。每一个文件处理一系列规则来帮助udev分配名字给设备文件以保证能被内核识别。

你的/etc/udev/rules.d下面可能有好几个udev规则文件,这些文件一部分是udev包安装的,另外一部分则是可能是别的硬件或者软件包 生成的。比如在Fedora Core 5系统上,sane-backends包就会安装60-libsane.rules文件,另外initscripts包会安装60-net.rules文 件。这些规则文件的文件名通常是两个数字开头,它表示系统应用该规则的顺序。

规则文件里的规则有一系列的键/值对组成,键/值对之间用逗号(,)分割。每一个键或者是用户匹配键,或者是一个赋值键。匹配键确定规则是否被应用,而赋 值键表示分配某值给该键。这些值将影响udev创建的设备文件。匹配键和赋值键操作符解释见下表:

| 操作符 | 匹配或赋值 | 解释 |

|---|---|---|

| == | 匹配 | 相等比较 |

| != | 匹配 | 不等比较 |

| = | 赋值 | 分配一个特定的值给该键,他可以覆盖之前的赋值。 |

| += | 赋值 | 追加特定的值给已经存在的键 |

| := | 赋值 | 分配一个特定的值给该键,后面的规则不可能覆盖它。 |

这有点类似我们常见的编程语言,比如C语言。只是这里的键一次可以处理多个值。有一些键在udev规则文件里经常出现,这些键的值可以使用通配符(*,?,甚至范围,比如[0-9]),这些常用键列举如下:

| 键 | 含义 |

|---|---|

| ACTION | 一个时间活动的名字,比如add,当设备增加的时候 |

| KERNEL | 在内核里看到的设备名字,比如sd*表示任意SCSI磁盘设备 |

| DEVPATH | 内核设备路径,比如/devices/* |

| SUBSYSTEM | 子系统名字,比如sound,net |

| BUS | 总线的名字,比如IDE,USB |

| DRIVER | 设备驱动的名字,比如ide-cdromID 独立于内核名字的设备名字 |

| SYSFS{ value} | sysfs属性值,他可以表示任意 |

| ENV{ key} | 环境变量,可以表示任意 |

| PROGRAM | 可执行的外部程序,如果程序返回0值,该键则认为为真(true) |

| RESULT | 上一个PROGRAM调用返回的标准输出。 |

| NAME | 根据这个规则创建的设备文件的文件名。注意:仅仅第一行的NAME描述是有效的,后面的均忽略。 如果你想使用使用两个以上的名字来访问一个设备的话,可以考虑SYMLINK键。 |

| SYMLINK | 根据规则创建的字符连接名 |

| OWNER | 设备文件的属组 |

| GROUP | 设备文件所在的组。 |

| MODE | 设备文件的权限,采用8进制 |

| RUN | 为设备而执行的程序列表 |

| LABEL | 在配置文件里为内部控制而采用的名字标签(下下面的GOTO服务) |

| GOTO | 跳到匹配的规则(通过LABEL来标识),有点类似程序语言中的GOTO |

| IMPORT{ type} | 导入一个文件或者一个程序执行后而生成的规则集到当前文件 |

| WAIT_FOR_SYSFS | 等待一个特定的设备文件的创建。主要是用作时序和依赖问题。 |

| PTIONS | 特定的选项: last_rule 对这类设备终端规则执行; ignore_device 忽略当前规则; ignore_remove 忽略接下来的并移走请求。all_partitions 为所有的磁盘分区创建设备文件。 |

我们给出一个列子来解释如何使用这些键。下面的例子来自Fedora Core 5系统的标准配置文件。

KERNEL=="*", OWNER="root" GROUP="root", MODE="0600"

KERNEL=="tty", NAME="%k", GROUP="tty", MODE="0666", OPTIONS="last_rule"

KERNEL=="scd[0-9]*", SYMLINK+="cdrom cdrom-%k"

KERNEL=="hd[a-z]", BUS=="ide", SYSFS{removable}=="1", SYSFS{device/media}=="cdrom", SYMLINK+="cdrom cdrom-%k"

ACTION=="add", SUBSYSTEM=="scsi_device", RUN+="/sbin/modprobe sg"

上面的例子给出了5个规则,每一个都是KERNEL或者ACTION键开头:

- 第一个规则是缺省的,他匹配任意被内核识别到的设备,然后设定这些设备的属组是root,组是root,访问权限模式是0600(-rw——-)。这也是一个安全的缺省设置保证所有的设备在默认情况下只有root可以读写

- 第二个规则也是比较典型的规则了。它匹配终端设备(tty),然后设置新的权限为0600,所在的组是tty。它也设置了一个特别的设备文件名:%K。在这里例子里,%k代表设备的内核名字。那也就意味着内核识别出这些设备是什么名字,就创建什么样的设备文件名。

- 第三行开始的KERNEL==”scd[0-9]*”,表示 SCSI CD-ROM 驱动. 它创建一对设备符号连接:cdrom和cdrom-%k。

- 第四行,开始的 KERNEL==”hd[a-z]“, 表示ATA CDROM驱动器。这个规则创建和上面的规则相同的符号连接。ATA CDROM驱动器需要sysfs值以来区别别的ATA设备,因为SCSI CDROM可以被内核唯一识别。.

- 第五行以 ACTION==”add”开始,它告诉udev增加 /sbin/modprobe sg 到命令列表,当任意SCSI设备增加到系统后,这些命令将执行。其效果就是计算机应该会增加sg内核模块来侦测新的SCSI设备。

当然,上面仅仅是一小部分例子,如果你的系统采用了udev方式,那你应该可以看到更多的规则。如果你想修改设备的权限或者创建信的符号连接,那么你需要熟读这些规则,特别是要仔细注意你修改的那些与之相关的设备。

修改你的udev配置

在修改udev配置之前,我们一定要仔细,通常的考虑是:你最好不要修改系统预置的那些规则,特别不要指定影响非常广泛的配置,比如上面例子中的第一行。不正确的配置可能会导致严重的系统问题或者系统根本就无法这个正确的访问设备。

而我们正确的做法应该是在/etc/udev/rules.d/下创建一个新的规则文件。确定你给出的文件的后缀是rules文件名给出的数字序列应该比标准配置文件高。比如,你可以创建一个名为99-my-udev.rules的规则文件。在你的规则文件中,你可以指定任何你想修改的配置,比如,假设你 修改修改floppy设备的所在组,还准备创建一个新的符号连接/dev/floppy,那你可以这么写:

KERNEL==”fd[0-9]*“, GROUP=“users“, SYMLINK+=“floppy“

有些发行版本,比如Fedora,采用了外部脚本来修改某些特定设备的属组,组关系和权限。因此上面的改动可能并不见得生效。如果你遇到了这个问题,你就需要跟踪和修改这个脚本来达到你的目的。或者你可以修改PROGRAM或RUN键的值来做到这点。

某些规则的修改可能需要更深的挖掘。比如,你可能想在一个设备上使用sysfs信息来唯一标识一个设备。这些信息最好通过udevinfo命令来获取。

udevinfo –a –p $(udevinfo –q path –n /dev/hda)

上面的命令两次使用udevinfo:一次是返回sysfs设备路径(他通常和我们看到的Linux设备文件名所在路径--/dev/hda--不同);第 二次才是查询这个设备路径,结果将是非常常的syfs信息汇总。你可以找到最够的信息来唯一标志你的设备,你可以采用适当的替换udev配置文件中的 SYSFS选项。下面的结果就是上面的命令输出

[root@localhost rules.d]# udevinfo -a -p $(udevinfo -q path -n /dev/hda1)

Udevinfo starts with the device specified by the devpath and then walks up the chain of

parent devices. It prints for every device found,all possible attributes in the udev rules

key format. A rule to match, can be composed by the attributes of the device and the

attributes from one single parent device.

looking at device '/block/hda/hda1':

KERNEL=="hda1" SUBSYSTEM=="block" DRIVER==""

ATTR{stat}==" 1133 2268 2 4" ATTR{size}=="208782"

ATTR{start}=="63" ATTR{dev}=="3:1" looking at parent device '/block/hda':

KERNELS=="hda" SUBSYSTEMS=="block" DRIVERS==""

ATTRS{stat}=="28905 18814 1234781 302540 34087 133247 849708 981336 0 218340 1283968"

ATTRS{size}=="117210240" ATTRS{removable}=="0"

ATTRS{range}=="64" ATTRS{dev}=="3:0"

looking at parent device '/devices/pci0000:00/0000:00:1f.1/ide0/0.0':

KERNELS=="0.0" SUBSYSTEMS=="ide" DRIVERS=="ide-disk"

ATTRS{modalias}=="ide:m-disk" ATTRS{drivename}=="hda"

ATTRS{media}=="disk"

looking at parent device '/devices/pci0000:00/0000:00:1f.1/ide0':

KERNELS=="ide0" SUBSYSTEMS=="" DRIVERS==""

looking at parent device '/devices/pci0000:00/0000:00:1f.1':

KERNELS=="0000:00:1f.1" SUBSYSTEMS=="pci" DRIVERS=="PIIX_IDE"

ATTRS{broken_parity_status}=="0" ATTRS{enable}=="1"

ATTRS{modalias}=="pci:v00008086d000024CAsv0000144Dsd0000C009bc01sc01i8a"

ATTRS{local_cpus}=="1" ATTRS{irq}=="11" ATTRS{class}=="0x01018a"

ATTRS{subsystem_device}=="0xc009" ATTRS{subsystem_vendor}=="0x144d"

ATTRS{device}=="0x24ca" ATTRS{vendor}=="0x8086"

looking at parent device '/devices/pci0000:00':

KERNELS=="pci0000:00" SUBSYSTEMS=="" DRIVERS==""

举一个例子:假设你想修改USB扫描仪的配置。通过一系列的尝试,你已经为这个扫描仪标识了Linux设备文件(每次打开扫描仪时,名字都会变)。你可以使 用上面的命令替换这个正确的Linux设备文件名,然后定位输出的采用SYSFS{idVendor}行和SYSFS{idProduct}行。最后你可 以使用这些信息来为这个扫描仪创建新的选项。

SYSFS{idVendor}=="0686", SYSFS{idProduct}=="400e", SYMLINK+="scanner", MODE="0664", group="scanner"

上面的例子表示将扫描仪的组设置为scanner,访问权限设置为0664,同时创建一个/dev/scanner的符号连接。

Tips

Mounting usb automatically & having usb’s label as mountpoint

How to automatically mount USB drives with custom mount point

Systemd

LINUX PID 1 和 SYSTEMD

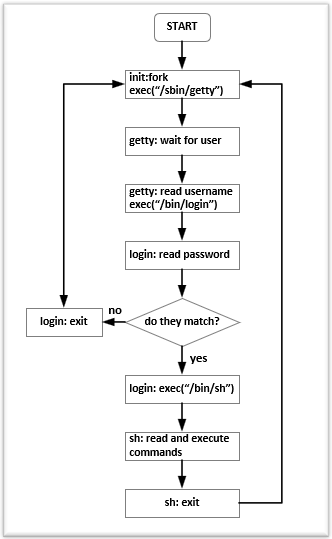

要说清 Systemd,得先从Linux操作系统的启动说起。Linux 操作系统的启动首先从 BIOS 开始,然后由 Boot Loader 载入内核,并初始化内核。内核初始化的最后一步就是启动 init 进程。这个进程是系统的第一个进程,PID 为 1,又叫超级进程,也叫根进程。它负责产生其他所有用户进程。所有的进程都会被挂在这个进程下,如果这个进程退出了,那么所有的进程都被 kill 。如果一个子进程的父进程退了,那么这个子进程会被挂到 PID 1 下面。(注:PID 0 是内核的一部分,主要用于内进换页,参看:Process identifier)

SysV Init

PID 1 这个进程非常特殊,其主要就任务是把整个操作系统带入可操作的状态。比如:启动 UI – Shell 以便进行人机交互,或者进入 X 图形窗口。传统上,PID 1 和传统的 Unix System V 相兼容的,所以也叫 sysvinit,这是使用得最悠久的 init 实现。Unix System V 于1983年 release。

在 sysvint 下,有好几个运行模式,又叫 runlevel。比如:常见的 3 级别指定启动到多用户的字符命令行界面,5 级别指定启起到图形界面,0 表示关机,6 表示重启。其配置在 /etc/inittab 文件中。

与此配套的还有 /etc/init.d/ 和 /etc/rc[X].d,前者存放各种进程的启停脚本(需要按照规范支持 start,stop子命令),后者的 X 表示不同的 runlevel 下相应的后台进程服务,如:/etc/rc3.d 是 runlevel=3 的。 里面的文件主要是 link 到 /etc/init.d/ 里的启停脚本。其中也有一定的命名规范:S 或 K 打头的,后面跟一个数字,然后再跟一个自定义的名字,如:S01rsyslog,S02ssh。S 表示启动,K表示停止,数字表示执行的顺序。

UpStart

Unix 和 Linux 在 sysvint 运作多年后,大约到了2006年的时候,Linux内核进入2.6时代,Linux有了很多更新。并且,Linux开始进入桌面系统,而桌面系统和服务器系统不一样的是,桌面系统面临频繁重启,而且,用户会非常频繁的使用硬件的热插拔技术。于是,这些新的场景,让 sysvint 受到了很多挑战。

比如,打印机需要CUPS等服务进程,但是如果用户没有打机印,启动这个服务完全是一种浪费,而如果不启动,如果要用打印机了,就无法使用,因为sysvint 没有自动检测的机制,它只能一次性启动所有的服务。另外,还有网络盘挂载的问题。在 /etc/fstab 中,负责硬盘挂载,有时候还有网络硬盘(NFS 或 iSCSI)在其中,但是在桌面机上,有很可能开机的时候是没有网络的, 于是网络硬盘都不可以访问,也无法挂载,这会极大的影响启动速度。sysvinit 采用 netdev 的方式来解决这个问题,也就是说,需要用户自己在 /etc/fstab 中给相应的硬盘配置上 netdev 属性,于是 sysvint 启动时不会挂载它,只有在网络可用后,由专门的 netfs 服务进程来挂载。这种管理方式比较难以管理,也很容易让人掉坑。

所以,Ubuntu 开发人员在评估了当时几个可选的 init 系统后,决定重新设计这个系统,于是,这就是我们后面看到的 upstart 。 upstart 基于事件驱动的机制,把之前的完全串行的同步启动服务的方式改成了由事件驱动的异步的方式。比如:如果有U盘插入,udev 得到通知,upstart 感知到这个事件后触发相应的服务程序,比如挂载文件系统等等。因为使用一个事件驱动的玩法,所以,启动操作系统时,很多不必要的服务可以不用启动,而是等待通知,lazy 启动。而且事件驱动的好处是,可以并行启动服务,他们之间的依赖关系,由相应的事件通知完成。

upstart 有着很不错的设计,其中最重要的两个概念是 Job 和 Event。

Job 有一般的Job,也有service的Job,并且,upstart 管理了整个 Job 的生命周期,比如:Waiting, Starting, pre-Start, Spawned, post-Start, Running, pre-Stop, Stopping, Killed, post-Stop等等,并维护着这个生命周期的状态机。

Event 分成三类,signal, method 和 hooks。signal 就是异步消息,method 是同步阻塞的。hooks 也是同步的,但介于前面两者之间,发出hook事件的进程必须等到事件完成,但不检查是否成功。

但是,upstart 的事件非常复杂,也非常纷乱,各种各样的事件(事件没有归好类)导致有点凌乱。不过因为整个事件驱动的设计比之前的 sysvinit 来说好太多,所以,也深得欢迎。

Systemd

直到2010的有一天,一个在 RedHat工作的工程师 Lennart Poettering 和 Kay Sievers ,开始引入了一个新的 init 系统—— systemd。这是一个非常非常有野心的项目,这个项目几乎改变了所有的东西,systemd 不但想取代已有的 init 系统,而且还想干更多的东西。

Lennart 同意 upstart 干的不错,代码质量很好,基于事件的设计也很好。但是他觉得 upstart 也有问题,其中最大的问题还是不够快,虽然 upstart 用事件可以达到一定的启动并行度,但是,本质上来说,这些事件还是会让启动过程串行在一起。 如:NetworkManager 在等 D-Bus 的启动事件,而 D-Bus 在等 syslog 的启动事件。

Lennart 认为,实现上来说,upstart 其实是在管理一个逻辑上的服务依赖树,但是这个服务依赖树在表现形式上比较简单,你只需要配置——“启动 B好了就启动A”或是“停止了A后就停止B”这样的规则。但是,Lennart 说,这种简单其实是有害的(this simplification is actually detrimental)。他认为,

-

从一个系统管理的角度出来,他一开始会设定好整个系统启动的服务依赖树,但是这个系统管理员要人肉的把这个本来就非常干净的服务依整树给翻译成计算机看的懂的 Event/Action 形式,而且 Event/Action 这种配置方式是运行时的,所以,你需要运行起来才知道是什么样的。

-

Event逻辑从头到脚到处都是,这个事件扩大了运维的复杂度,还不如之前的

sysvint。 也就是说,当用户配置了 “启动D-Bus后请启动NetworkManager”, 这个upstart可以干,但是反过来,如果,用户启动NetworkManager,我们应该先去启动他的前置依赖D-Bus,然而你还要配置相应的反向 Event。本来,我只需要配置一条依赖的,结果现在我要配置很多很多情况下的Event。 -

最后,

upstart里的 Event 的并不标准,很混乱,没有良好的定义。比如:既有,进程启动,运行,停止的事件,也有USB设备插入、可用、拔出的事件,还有文件系统设备being mounted、 mounted 和 umounted 的事件,还有AC电源线连接和断开的事件。你会发现,这进程启停的、USB的、文件系统的、电源线的事件,看上去长得很像, 但是没有被标准化抽像出来掉,因为绝大多数的事件都是三元组:start, condition, stop 。这种概念设计模型并没有在upstart中出现。因为upstart被设计为单一的事件,而忽略了逻辑依赖。

当然,如果 systemd 只是解决 upstart 的问题,他就改造 upstart 就好了,但是 Lennart 的野心不只是想干个这样的事,他想干的更多。

首先,systemd 清醒的认识到了 init 进程的首要目标是要让用户快速的进入可以操作OS的环境,所以,这个速度一定要快,越快越好,所以,systemd 的设计理念就是两条:

- To start less.

- And to start more in parallel.

也就是说,按需启动,能不启动就不启动,如果要启动,能并行启动就并行启动,包括你们之间有依赖,我也并行启动。按需启动还好理解,那么,有依赖关系的并行启动,它是怎么做到的?这里,systemd 借鉴了 MacOS 的 Launchd 的玩法(在Youtube上有一个分享——Launchd: One Program to Rule them All,在苹果的开源网站上也有相关的设计文档——About Daemons and Services)

要解决这些依赖性,systemd 需要解决好三种底层依赖—— Socket, D-Bus ,文件系统。

-

Socket依赖。如果服务C依赖于服务S的socket,那么就要先启动S,然后再启动C,因为如果C启动时找不到S的Socket,那么C就会失败。

systemd可以帮你在S还没有启动好的时候,建立一个socket,用来接收所有的C的请求和数据,并缓存之,一旦S全部启动完成,把systemd替换好的这个缓存的数据和Socket描述符替换过去。 -

D-Bus依赖。

D-Bus全称 Desktop Bus,是一个用来在进程间通信的服务。除了用于用户态进程和内核态进程通信,也用于用户态的进程之前。现在,很多的现在的服务进程都用D-Bus而不是Socket来通信。比如:NetworkManager就是通过D-Bus和其它服务进程通讯的,也就是说,如果一个进程需要知道网络的状态,那么就必需要通过D-Bus通信。D-Bus支持 “Bus Activation”的特性。也就是说,A要通过D-Bus服务和B通讯,但是B没有启动,那么D-Bus可以把B起来,在B启动的过程中,D-Bus帮你缓存数据。systemd可以帮你利用好这个特性来并行启动 A 和 B。 -

文件系统依赖。系统启动过程中,文件系统相关的活动是最耗时的,比如挂载文件系统,对文件系统进行磁盘检查(fsck),磁盘配额检查等都是非常耗时的操作。在等待这些工作完成的同时,系统处于空闲状态。那些想使用文件系统的服务似乎必须等待文件系统初始化完成才可以启动。

systemd参考了autofs的设计思路,使得依赖文件系统的服务和文件系统本身初始化两者可以并发工作。autofs可以监测到某个文件系统挂载点真正被访问到的时候才触发挂载操作,这是通过内核automounter模块的支持而实现的。比如一个open()系统调用作用在某个文件系统上的时候,而这个文件系统尚未执行挂载,此时open()调用被内核挂起等待,等到挂载完成后,控制权返回给open()系统调用,并正常打开文件。这个过程和autofs是相似的。

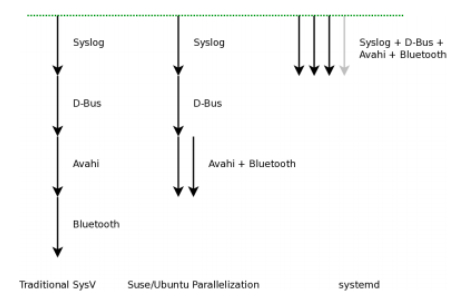

下图来自 Lennart 的演讲里的一页PPT,展示了不同 init 系统的启动。

除此之外,systemd 还在启动时管理好了一些下面的事。

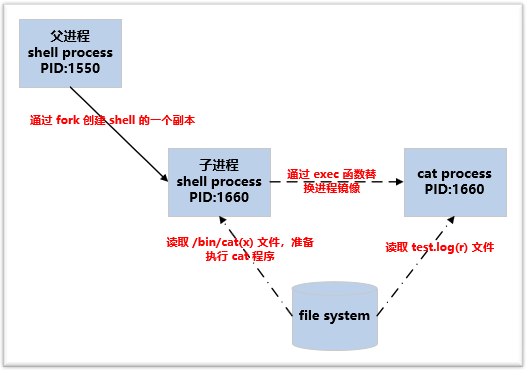

用C语言取代传统的脚本式的启动。前面说过,sysvint 用 /etc/rcX.d 下的各种脚本启动。然而这些脚本中需要使用 awk, sed, grep, find, xargs 等等这些操作系统的命令,这些命令需要生成进程,生成进程的开销很大,关键是生成完这些进程后,这个进程就干了点屁大的事就退了。换句话说就是,我操作系统干了那么多事为你拉个进程起来,结果你就把个字串转成小写就退了,把我操作系统当什么了?

在正常的一个 sysvinit 的脚本里,可能会有成百上千个这样的命令。所以,慢死。因此,systemd 全面用 C 语言全部取代了。一般来说,sysvinit 下,操作系统启动完成后,用 echo $$ 可以看到,pid 被分配到了上千的样子,而 systemd 的系统只是上百。

另外,systemd 是真正一个可以管住服务进程的——可以跟踪上服务进程所fork/exec出来的所有进程。

-

我们知道, 传统 Unix/Linux 的 Daemon 服务进程的最佳实践基本上是这个样子的(具体过程可参看这篇文章“[SysV Daemon](http://0pointer.de/public/systemd-man/daemon.html#SysV Daemons)”)

- 进程启动时,关闭所有的打开的文件描述符(除了标准描述符0,1,2),然后重置所有的信号处理。

- 调用

fork()创建子进程,在子进程中setsid(),然后父进程退出(为了后台执行) - 在子进程中,再调用一次

fork(),创建孙子进程,确定没有交互终端。然后子进程退出。 - 在孙子进程中,把标准输入标准输出标准错误都连到

/dev/null上,还要创建 pid 文件,日志文件,处理相关信号 …… - 最后才是真正开始提供服务。

-

在上面的这个过程中,服务进程除了两次

fork外还会fork出很多很多的子进程(比如说一些Web服务进程,会根据用户的请求链接来fork子进程),这个进程树是相当难以管理的,因为,一旦父进程退出来了,子进程就会被挂到 PID 1下,所以,基本上来说,你无法通过服务进程自已给定的一个pid文件来找到所有的相关进程(这个对开发者的要求太高了),所以,在传统的方式下用脚本启停服务是相当相当的 Buggy 的,因为无法做对所有的服务生出来的子子孙孙做到监控。 -

为了解决这个问题,

upstart通过变态的strace来跟踪进程中的fork()和exec()或exit()等相关的系统调用。这种方法相当笨拙。systemd使用了一个非常有意思的玩法来 tracking 服务进程生出来的所有进程,那就是用cgroup(我在 Docker 的基础技术“cgroup篇”中讲过这个东西)。cgroup主要是用来管理进程组资源配额的事,所以,无论服务如何启动新的子进程,所有的这些相关进程都会同属于一个cgroup,所以,systemd只需要简单的去遍历一下相应的cgroup的那个虚文件系统目录下的文件,就可以正确的找到所有的相关进程,并将他们一一停止。

另外,systemd 简化了整个 daemon 开发的过程:

- 不需要两次

fork(),只需要实现服务本身的主逻辑就可以了。 - 不需要

setsid(),systemd会帮你干 - 不需要维护

pid文件,systemd会帮处理。 - 不需要管理日志文件或是使用

syslog,或是处理HUP的日志reload信号。把日志打到stderr上,systemd帮你管理。 - 处理

SIGTERM信号,这个信号就是正确退出当前服务,不要做其他的事。 - ……

除此之外,systemd 还能——

- 自动检测启动的服务间有没有环形依赖。

- 内建 autofs 自动挂载管理功能。

- 日志服务。

systemd改造了传统的 syslog 的问题,采用二进制格式保存日志,日志索引更快。 - 快照和恢复。对当前的系统运行的服务集合做快照,并可以恢复。

- ……

还有好多好多,他接管很多很多东西,于是就让很多人不爽了,因为他在干了很多本不属于 PID 1 的事。

Systemd 争论和八卦

于是 systemd 这个东西成了可能是有史以来口水战最多的一个开源软件了。systemd 饱受各种争议,最大的争议就是他破坏了 Unix 的设计哲学(相关的哲学可以读一下《Unix编程艺术》),干了一个大而全而且相当复杂的东西。当然,Lennart 并不同意这样的说法,他后来又写一篇blog “The Biggest Myths”来解释 systemd 并不是这样的,大家可以前往一读。

这个争议大到什么样子呢?2014 年,Debian Linux 因为想准备使用 systemd 来作为标准的 init 守护进程来替换 sysvinit 。而围绕这个事的争论达到了空前的热度,争论中充满着仇恨,systemd 的支持者和反对者都在互相辱骂,导致当时 Debian 阵营开始分裂。还有人给 Lennart 发了死亡威胁的邮件,用比特币雇凶买杀手,扬言要取他的性命,在Youbute上传了侮辱他的歌曲,在IRC和各种社交渠道上给他发下流和侮辱性的消息。这已经不是争议了,而是一种不折不扣的仇恨!

于是,Lennart 在 Google Plus 上发了贴子,批评整个 Linux 开源社区和 Linus 本人。他大意说,

这个社区太病态了,全是 ass holes,你们不停用各种手段在各种地方用不同的语言和方式来侮辱和漫骂我。我还是一个年轻人,我从来没有经历过这样的场面,但是今天我已经对这种场面很熟悉了。我有时候说话可能不准确,但是我不会像他样那样说出那样的话,我也没有被这些事影响,因为我脸皮够厚,所以,为什么我可以在如何大的反对声面前让

systemd成功,但是,你们 Linux 社区太可怕了。你们里面的有精神病的人太多了。另外,对于Linus Torvalds,你是这个社区的 Role Model,但可惜你是一个 Bad Role Model,你在社区里的刻薄和侮辱性的言行,基本从一定程度上鼓励了其它人跟你一样,当然,并不只是你一个人的问题,而是在你周围聚集了一群和你一样的这样干的人。送你一句话—— A fish rots from the head down !一条鱼是从头往下腐烂的……

这篇契文很长,喜欢八卦的同学可以前往一读。感受一下 Lennart 当时的心态(我觉得能算上是非常平稳了)。

Linus也在被一媒体问起 systemd 这个事来(参看“Torvalds says he has no strong opinions on systemd”),Linus在采访里说,

我对

systemd和 Lennart 的贴子没有什么强烈的想法。虽然,传统的 Unix 设计哲学—— “Do one thing and Do it well”,很不错,而且我们大多数人也实践了这么多年,但是这并不代表所有的真实世界。在历史上,也不只有systemd这么干过。但是,我个人还是 old-fashioned 的人,至少我喜欢文本式的日志,而不是二进制的日志。但是systemd没有必要一定要有这样的品味。哦,我说细节了……

今天,systemd 占据了几乎所有的主流的 Linux 发行版的默认配置,包括:Arch Linux、CentOS、CoreOS、Debian、Fedora、Megeia、OpenSUSE、RHEL、SUSE企业版和 Ubuntu。而且,对于 CentOS, CoreOS, Fedora, RHEL, SUSE这些发行版来说,不能没有 systemd。(Ubuntu 还有一个不错的wiki – Systemd for Upstart Users 阐述了如何在两者间切换)

其它

还记得在《缓存更新的套路》一文中,我说过,如果你要做好架构,首先你得把计算机体系结构以及很多老古董的基础技术吃透了。因为里面会有很多可以借鉴和相通的东西。那么,你是否从这篇文章里看到了一些有分布式架构相似的东西?

比如:从 sysvinit 到 upstart 再到 systemd,像不像是服务治理?Linux系统下的这些服务进程,是不是很像分布式架构中的微服务?还有那个D-Bus,是不是很像SOA里的ESB?而 init 系统是不是很像一个控制系统?甚至像一个服务编排(Service Orchestration)系统?

分布式系统中的服务之间也有很多依赖,所以,在启动一个架构的时候,如果我们可以做到像 systemd 那样并行启动的话,那么是不是就像是一个微服务的玩法了?

嗯,你会发现,技术上的很多东西是相通的,也是互相有对方的影子,所以,其实技术并不多。关键是我们学在了表面还是看到了本质。

命令

Systemd 是 Linux 系统工具,用来启动守护进程,已成为大多数发行版的标准配置。

系统管理

Systemd 并不是一个命令,而是一组命令,涉及到系统管理的方方面面。

systemctl

systemctl是 Systemd 的主命令,用于管理系统。

# 重启系统

$ sudo systemctl reboot

# 关闭系统,切断电源

$ sudo systemctl poweroff

# CPU停止工作

$ sudo systemctl halt

# 暂停系统

$ sudo systemctl suspend

# 让系统进入冬眠状态

$ sudo systemctl hibernate

# 让系统进入交互式休眠状态

$ sudo systemctl hybrid-sleep

# 启动进入救援状态(单用户状态)

$ sudo systemctl rescue

systemd-analyze

systemd-analyze命令用于查看启动耗时。

# 查看启动耗时

$ systemd-analyze

# 查看每个服务的启动耗时

$ systemd-analyze blame

# 显示瀑布状的启动过程流$

$ systemd-analyze critical-chain

# 显示指定服务的启动流

$ systemd-analyze critical-chain atd.service

hostnamectl

hostnamectl命令用于查看当前主机的信息。

# 显示当前主机的信息

$ hostnamectl

# 设置主机名。

$ sudo hostnamectl set-hostname rhel7

localectl

localectl命令用于查看本地化设置。

# 查看本地化设置

$ localectl

# 设置本地化参数。

$ sudo localectl set-locale LANG=en_GB.utf8

$ sudo localectl set-keymap en_GB

timedatectl

timedatectl命令用于查看当前时区设置。

# 查看当前时区设置

$ timedatectl

# 显示所有可用的时区

$ timedatectl list-timezones

# 设置当前时区

$ sudo timedatectl set-timezone America/New_York

$ sudo timedatectl set-time YYYY-MM-DD

$ sudo timedatectl set-time HH:MM:SS

loginctl

loginctl命令用于查看当前登录的用户。

# 列出当前session

$ loginctl list-sessions

# 列出当前登录用户

$ loginctl list-users

# 列出显示指定用户的信息

$ loginctl show-user ruanyf

Unit

含义

Systemd 可以管理所有系统资源。不同的资源统称为 Unit(单元)。简单说,单元就是 Systemd 的最小功能单位,是单个进程的描述。一个个小的单元互相调用和依赖,组成一个庞大的任务管理系统,这就是 Systemd 的基本思想。

由于 Systemd 要做的事情太多,导致单元有很多不同的种类,大概一共有12种。

- Service unit:系统服务

- Target unit:多个 Unit 构成的一个组

- Device Unit:硬件设备

- Mount Unit:文件系统的挂载点

- Automount Unit:自动挂载点

- Path Unit:文件或路径

- Scope Unit:不是由 Systemd 启动的外部进程

- Slice Unit:进程组,资源分配

- Snapshot Unit:Systemd 快照,可以切回某个快照

- Socket Unit:进程间通信的 socket

- Swap Unit:swap 文件

- Timer Unit:定时器

systemctl list-units命令可以查看当前系统的所有 Unit 。

# 列出正在运行的 Unit

$ systemctl list-units

# 列出所有Unit,包括没有找到配置文件的或者启动失败的

$ systemctl list-units --all

# 列出所有没有运行的 Unit

$ systemctl list-units --all --state=inactive

# 列出所有加载失败的 Unit

$ systemctl list-units --failed

# 列出所有正在运行的、类型为 service 的 Unit

$ systemctl list-units --type=service

Unit 的状态

systemctl status命令用于查看系统状态和单个 Unit 的状态。

# 显示系统状态

$ systemctl status

# 显示单个 Unit 的状态

$ sysystemctl status bluetooth.service

# 显示远程主机的某个 Unit 的状态

$ systemctl -H root@rhel7.example.com status httpd.service

例如查看 httpd 状态

$ sudo systemctl status httpd

httpd.service - The Apache HTTP Server

Loaded: loaded (/usr/lib/systemd/system/httpd.service; enabled)

Active: active (running) since 金 2014-12-05 12:18:22 JST; 7min ago

Main PID: 4349 (httpd)

Status: "Total requests: 1; Current requests/sec: 0; Current traffic: 0 B/sec"

CGroup: /system.slice/httpd.service

├─4349 /usr/sbin/httpd -DFOREGROUND

├─4350 /usr/sbin/httpd -DFOREGROUND

├─4351 /usr/sbin/httpd -DFOREGROUND

├─4352 /usr/sbin/httpd -DFOREGROUND

├─4353 /usr/sbin/httpd -DFOREGROUND

└─4354 /usr/sbin/httpd -DFOREGROUND

12月 05 12:18:22 localhost.localdomain systemd[1]: Starting The Apache HTTP Server...

12月 05 12:18:22 localhost.localdomain systemd[1]: Started The Apache HTTP Server.

12月 05 12:22:40 localhost.localdomain systemd[1]: Started The Apache HTTP Server.

上面的输出结果含义如下。

Loaded行:配置文件的位置,是否设为开机启动Active行:表示正在运行Main PID行:主进程IDStatus行:由应用本身(这里是 httpd )提供的软件当前状态CGroup块:应用的所有子进程- 日志块:应用的日志

除了status命令,systemctl还提供了三个查询状态的简单方法,主要供脚本内部的判断语句使用。

# 显示某个 Unit 是否正在运行

$ systemctl is-active application.service

# 显示某个 Unit 是否处于启动失败状态

$ systemctl is-failed application.service

# 显示某个 Unit 服务是否建立了启动链接

$ systemctl is-enabled application.service

Unit 管理

对于用户来说,最常用的是下面这些命令,用于启动和停止 Unit(主要是 service)。

# 立即启动一个服务

$ sudo systemctl start apache.service

# 立即停止一个服务

$ sudo systemctl stop apache.service

# 重启一个服务

$ sudo systemctl restart apache.service

# 杀死一个服务的所有子进程

$ sudo systemctl kill apache.service

# 重新加载一个服务的配置文件

$ sudo systemctl reload apache.service

# 重载所有修改过的配置文件

$ sudo systemctl daemon-reload

# 显示某个 Unit 的所有底层参数

$ systemctl show httpd.service

# 显示某个 Unit 的指定属性的值

$ systemctl show -p CPUShares httpd.service

# 设置某个 Unit 的指定属性

$ sudo systemctl set-property httpd.service CPUShares=500

有时候,该命令可能没有响应,执行systemctl stop服务停不下来。这时候就不得不"杀进程"了,向正在运行的进程发出kill信号,执行systemctl kill。

依赖关系

Unit 之间存在依赖关系:A 依赖于 B,就意味着 Systemd 在启动 A 的时候,同时会去启动 B。

systemctl list-dependencies命令列出一个 Unit 的所有依赖。

systemctl list-dependencies nginx.service

上面命令的输出结果之中,有些依赖是 Target 类型(详见下文),默认不会展开显示。如果要展开 Target,就需要使用--all参数。

systemctl list-dependencies --all nginx.service

Unit 的配置文件

概述

每一个 Unit 都有一个配置文件,告诉 Systemd 怎么启动这个 Unit 。

除了系统默认的单元文件/lib/systemd/system,Systemd 默认从目录/etc/systemd/system/读取配置文件。但是,里面存放的大部分文件都是符号链接,指向目录/usr/lib/systemd/system/。那些支持 Systemd 的软件,安装的时候,也会自动在/usr/lib/systemd/system目录添加一个配置文件。

systemctl enable命令用于在/etc/systemd/system/和/usr/lib/systemd/system之间,建立符号链接关系。

$ sudo systemctl enable clamd@scan.service

# 等同于

$ sudo ln -s '/usr/lib/systemd/system/clamd@scan.service' '/etc/systemd/system/multi-user.target.wants/clamd@scan.service'

如果配置文件里面设置了开机启动,systemctl enable命令相当于激活开机启动。

与之对应的,systemctl disable命令用于在两个目录之间,撤销符号链接关系,相当于撤销开机启动。

sudo systemctl disable clamd@scan.service

配置文件的后缀名,就是该 Unit 的种类,比如sshd.socket。如果省略,Systemd 默认后缀名为.service,所以sshd会被理解成sshd.service。

设置开机启动以后,软件并不会立即启动,必须等到下一次开机。如果想现在就运行该软件,那么要执行systemctl start命令。

配置文件的状态

systemctl list-unit-files命令用于列出所有配置文件。

# 列出所有配置文件

$ systemctl list-unit-files

# 列出指定类型的配置文件

$ systemctl list-unit-files --type=service

这个命令会输出一个列表。

systemctl list-unit-filesUNIT FILE STATEchronyd.service enabledclamd@.service staticclamd@scan.service disabled

这个列表显示每个配置文件的状态,一共有四种。

- enabled:已建立启动链接

- disabled:没建立启动链接

- static:该配置文件没有

[Install]部分(无法执行),只能作为其他配置文件的依赖 - masked:该配置文件被禁止建立启动链接