[fəˈdɔrə] 费多拉

Fedora Linux 版本

Fedora 官方版本

- Fedora 工作站是可以安装在笔记本电脑和台式电脑上的 Linux。 此版本附带 GNOME 作为默认桌面环境和各种标准应用程序,以便 Fedora Linux 已准备好用于日常使用。

- Fedora 服务器专门用于服务器计算机用途,提供邮件服务器、DNS 等的安装。

- Fedora 物联网,用于物联网和设备边缘生态系统。

- Fedora CoreOS 是一种自动更新的操作系统,旨在安全、大规模地运行容器化工作负载。

- Fedora Silverblue 是一个不可变的桌面操作系统,旨在支持以容器为中心的工作流。

Fedora Spins

Fedora 的默认桌面环境是 GNOME,但是如果您喜欢其他的桌面环境,比如 KDE Plasma Desktop 或 Xfce,您可以下载一个您喜欢的桌面环境的 spin,然后用它来安装 Fedora,为您选择的桌面环境进行预配置。

Fedora Labs

Fedora 实验室是一个由 Fedora 社区成员策划和维护的目的明确的软件和内容的精选捆绑包。这些软件可以作为独立的Fedora完整版安装,也可以作为现有的Fedora安装的附加组件安装。

Fedora Alternative Downloads

这些Fedora下载要么是特殊用途的——用于测试,用于特定的架构;要么是其他格式的Fedora标准版本,如网络安装程序格式或用于torrent下载的格式。

本页旨在作为查找Fedora替代版本的单一中央资源。

Fedora Usage

Mirrors Of Fedora

SJTU Mirror

托管于华东教育网骨干节点上海交通大学。

$ sudo sed -e 's/^metalink=/#metalink=/g' -e 's|^#baseurl=http://download.example/pub/|baseurl=https://mirror.sjtu.edu.cn/|g' -i.bak /etc/yum.repos.d/{fedora,fedora-updates,fedora-modular,fedora-updates-modular}.repo

$ sudo dnf makecache #生成缓存

RPMFusion

第一步下载基础包(开源和闭源), 这里我们使用bfsu来下载,以避免网络问题,终端输入:

$ sudo dnf install --nogpgcheck https://mirror.sjtu.edu.cn/rpmfusion/free/fedora/rpmfusion-free-release-$(rpm -E %fedora).noarch.rpm https://mirror.sjtu.edu.cn/rpmfusion/nonfree/fedora/rpmfusion-nonfree-release-$(rpm -E %fedora).noarch.rpm -y

第二步,使用SJTU Mirror

sudo sed -e 's|^metalink=|#metalink=|g' -e 's|^#baseurl=http://download1.rpmfusion.org/|baseurl=https://mirror.sjtu.edu.cn/rpmfusion/|g' -i.bak /etc/yum.repos.d/rpmfusion-*

FlatHub Mirror

改为使用 sjtu 镜像:

$ sudo flatpak remote-add --if-not-exists flathub https://flathub.org/repo/flathub.flatpakrepo

$ sudo flatpak remote-modify --enable flathub

$ sudo flatpak remote-modify flathub --url=https://mirror.sjtu.edu.cn/flathub

$ sudo flatpak remotes --show-details

$ cat /var/lib/flatpak/repo/config

Copr

类似 Ubuntu 的 PPA

-

You need to have

dnf-plugins-coreinstalled for dnf, and you need to haveyum-plugin-coprinstalled for yum$ sudo dnf install dnf-plugins-core $ sudo yum install yum-plugin-copr -

If you’re using a version of Linux with dnf, or if you have older distribution:

$ sudo dnf copr enable user/project $ sudo yum copr enable user/project

例如Fedora自带的Copr repo for PyCharm

$ cat /etc/yum.repos.d/_copr_phracek-PyCharm.repo

[phracek-PyCharm]

name=Copr repo for PyCharm owned by phracek

baseurl=https://copr-be.cloud.fedoraproject.org/results/phracek/PyCharm/fedora-$releasever-$basearch/

skip_if_unavailable=True

gpgcheck=1

gpgkey=https://copr-be.cloud.fedoraproject.org/results/phracek/PyCharm/pubkey.gpg

enabled=0

Speed Up DNF

尝试更改参数:

$ sudo vi /etc/dnf/dnf.conf

fastestmirror=true #如果启用国内镜像,就不需要设置这个了。

max_parallel_downloads=5

metadata_expire=2d

- fastermirror 选择最快的镜像

- max_parallel_downloads 一次下载多个包

Gnome

$ sudo dnf install gnome-tweaks gnome-extensions-app

- gnome-tweaks 里面可以管理 startup apps。

- gnome-extensions-app 管理 extensions。

- gnome-shell-extension-appindicator

- gnome-shell-extension-gsconnect

Multiple Git Accounts

$ ssh-keygen -t rsa -C "your-email"

$ nano ~/.ssh/config

Host github-proj1

HostName github.com

User git

IdentityFile ~/.ssh/id_rsa_github_proj1

Host github-proj2

HostName github.com

User git

IdentityFile ~/.ssh/id_rsa_github_proj2

Host aws-codecommit-proj3

Hostname git-codecommit.us-east-2.amazonaws.com

User TECADMIN0123456789

IdentityFile ~/.ssh/id_rsa_aws_codecommit_proj3

AddKeysToAgent yes

$ git clone ssh://github-proj1/user1/repo.git

$ git clone ssh://github-proj2/user2/repo.git

$ git clone ssh://aws-codecommit-proj3/v1/repos/myrepo

设置 config 后,可能需要重启才能起作用。

Fcitx5

$ sudo dnf install fcitx5 fcitx5-chinese-addons fcitx5-gtk fcitx5-qt fcitx5-configtool fcitx5-autostart fcitx5-rime

$ rpm -ql fcitx5-autostart

/etc/profile.d/fcitx5.sh

/etc/xdg/autostart/org.fcitx.Fcitx5.desktop

$ cat /etc/profile.d/fcitx5.sh

if [ ! "$XDG_SESSION_TYPE" = "tty" ] # if this is a gui session (not tty)

then

# let's use fcitx instead of fcitx5 to make flatpak happy

# this may break behavior for users who have installed both

# fcitx and fcitx5, let then change the file on their own

export INPUT_METHOD=fcitx

export GTK_IM_MODULE=fcitx

export QT_IM_MODULE=fcitx

export XMODIFIERS=@im=fcitx

fi

$ cat /etc/xdg/autostart/org.fcitx.Fcitx5.desktop

[Desktop Entry]

Name[ca]=Fcitx 5

Name[da]=Fcitx 5

Name[de]=Fcitx 5

Name[ja]=Fcitx 5

Name[ko]=Fcitx 5

Name[zh_CN]=Fcitx 5

Name[zh_TW]=Fcitx 5

Name=Fcitx 5

GenericName[ca]=Mètode d'entrada

GenericName[da]=Inputmetode

GenericName[de]=Eingabemethode

GenericName[ja]=入力メソッド

GenericName[ko]=입력기

GenericName[ru]=Метод ввода

GenericName[zh_CN]=输入法

GenericName[zh_TW]=輸入法

GenericName=Input Method

Comment[ca]=Mètode d'entrada estàndard

Comment[da]=Start inputmetode

Comment[de]=Eingabemethode starten

Comment[ja]=入力メソッドを開始

Comment[ko]=입력기 시작

Comment[zh_CN]=启动输入法

Comment=Start Input Method

Exec=/usr/bin/fcitx5

Icon=fcitx

Terminal=false

Type=Application

Categories=System;Utility;

StartupNotify=false

X-GNOME-AutoRestart=false

X-GNOME-Autostart-Notify=false

X-KDE-autostart-after=panel

X-KDE-StartupNotify=false

X-KDE-Wayland-VirtualKeyboard=true

在 fcitx5 Configure 中,Input Method 只保留 rime,按组合键 Ctrl+` 选择 ”朙月拼音-简化字“,对应定制文件为 luna_pinyin_simp.custom.yaml。

Nvidia

-

Update from the existing repositories

$ sudo dnf update -

Add the RPMFusion repository for NVIDIA drivers

$ sudo dnf install fedora-workstation-repositories -

Update from the newly added repositories

$ sudo dnf update --refresh -

Install the driver and its dependencies

$ sudo dnf install gcc kernel-headers kernel-devel akmod-nvidia xorg-x11-drv-nvidia xorg-x11-drv-nvidia-libs xorg-x11-drv-nvidia-libs.i686 -

Wait for the kernel modules to load up

-

Read from the updated kernel modules

$ sudo akmods --force $ sudo dracut --force -

Reboot your system.

在这里,确定在登录界面选择的是 Gnome on Xorg。

-

Edit the X11 configuration

$ sudo cp -p /usr/share/X11/xorg.conf.d/nvidia.conf /etc/X11/xorg.conf.d/nvidia.conf $ sudo nano /etc/X11/xorg.conf.d/nvidia.conf Section "OutputClass" Identifier "nvidia" MatchDriver "nvidia-drm" Driver "nvidia" Option "AllowEmptyInitialConfiguration" Option "SLI" "Auto" Option "BaseMosaic" "on" Option "PrimaryGPU" "yes" EndSection Section "ServerLayout" Identifier "layout" Option "AllowNVIDIAGPUScreens" EndSection -

Reboot your system

-

Verify the configuration

$ glxinfo | egrep "OpenGL vendor|OpenGL renderer"

Movies and music

In order to install OpenH264, you first need to enable it:

$ cat /etc/yum.repos.d/fedora-cisco-openh264.repo

[fedora-cisco-openh264]

name=Fedora $releasever openh264 (From Cisco) - $basearch

metalink=https://mirrors.fedoraproject.org/metalink?repo=fedora-cisco-openh264-$releasever&arch=$basearch

type=rpm

enabled=0

metadata_expire=14d

repo_gpgcheck=0

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-fedora-$releasever-$basearch

skip_if_unavailable=True

[fedora-cisco-openh264-debuginfo]

name=Fedora $releasever openh264 (From Cisco) - $basearch - Debug

metalink=https://mirrors.fedoraproject.org/metalink?repo=fedora-cisco-openh264-debug-$releasever&arch=$basearch

type=rpm

enabled=0

metadata_expire=14d

repo_gpgcheck=0

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-fedora-$releasever-$basearch

skip_if_unavailable=True

$ sudo dnf config-manager --set-enabled fedora-cisco-openh264

Use the dnf utility to install packages that provide multimedia libraries:

$ sudo proxychains dnf install gstreamer1-plugins-{bad-\*,good-\*,base} gstreamer1-plugin-openh264 gstreamer1-libav --exclude=gstreamer1-plugins-bad-free-devel -y

$ sudo proxychains dnf install lame\* --exclude=lame-devel -y

$ sudo proxychains dnf group upgrade --with-optional Multimedia -y

$ sudo dnf config-manager --set-disabled fedora-cisco-openh264

and then install the plugins (for firefox, if needed):

$ sudo dnf install mozilla-openh264

Afterwards you need open Firefox, go to menu → Add-ons → Plugins and enable OpenH264 plugin.

Rhythmbox

无法订阅喜马拉雅的feed,报错为:

Unable to load the feed. Check your network connection

其实试一下荔枝FM,会发现是可以订阅的。比较一下就会发现,荔枝FM的Feed都是mp3链接,而喜马拉雅的Feed都是m4a链接,下载必须解码器后( The .m4a files are alac which would be decoded by gstreamer1.0-libav. ),Rhythmbox 确实能播放m4a文件了,但依然无法订阅,因此应该是Prodcast解析feed链接的问题,有兴趣有能力有时间看:Rhythmbox Development Reference Manual(PS:Ubuntu 22.04.1 上并无此问题)

Podman

kali linux

开代理的话会报错:

Could not connect to 127.0.0.1:7890 (127.0.0.1). - connect (111: Connection refused)

查看 man podman-run,添加 --http-proxy=false 解决:

$ podman run --http-proxy=false -it docker.io/kalilinux/kali-rolling:latest /bin/bash

更换 ustc 源

$ echo 'deb http://mirrors.ustc.edu.cn/kali kali-rolling main non-free con

trib' > sources.list

$ apt update && apt -y install kali-linux-headless

ZFS on Fedora

zfs-fuse is a daemon which provides support for the ZFS filesystem, via fuse. Ordinarily this daemon will be invoked from system boot scripts.

$ sudo dnf install zfs-fuse

$ sudo zfs-fuse

$ sudo zpool import dpool

cannot import 'dpool': pool is formatted using a newer ZFS version

$ sudo rpm -e --nodeps zfs-fuse

$ sudo proxychains dnf install -y https://zfsonlinux.org/fedora/zfs-release$(rpm -E %dist).noarch.rpm

$ cat /etc/yum.repos.d/zfs.repo

[zfs]

name=ZFS on Linux for Fedora $releasever

baseurl=http://download.zfsonlinux.org/fedora/$releasever/$basearch/

enabled=0

metadata_expire=7d

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-zfsonlinux

[zfs-source]

name=ZFS on Linux for Fedora $releasever - Source

baseurl=http://download.zfsonlinux.org/fedora/$releasever/SRPMS/

enabled=0

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-zfsonlinux

[zfs-testing]

name=ZFS on Linux for Fedora $releasever - Testing

baseurl=http://download.zfsonlinux.org/fedora-testing/$releasever/$basearch/

enabled=0

metadata_expire=7d

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-zfsonlinux

[zfs-testing-source]

name=ZFS on Linux for Fedora $releasever - Testing Source

baseurl=http://download.zfsonlinux.org/fedora-testing/$releasever/SRPMS/

enabled=0

gpgcheck=1

gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-zfsonlinux

$ sudo proxychains dnf install -y kernel-devel

$ sudo proxychains dnf install -y zfs

$ sudo modprobe zfs

$ echo zfs | sudo tee /etc/modules-load.d/zfs.conf # 可选

$ sudo dnf config-manager --set-disabled zfs

virt-manager

$ sudo dnf install @virtualization

$ sudo vi /etc/libvirt/libvirtd.conf

unix_sock_group = "libvirt"

unix_sock_rw_perms = "0770"

$ sudo systemctl restart libvirtd

$ sudo usermod -a -G libvirt $(whoami)

Now you must log out and log in to apply the changes.

VSCode

$ sudo tee -a /etc/yum.repos.d/vscode.repo << 'EOF'

[code]

name=Visual Studio Code

baseurl=https://packages.microsoft.com/yumrepos/vscode

enabled=1

gpgcheck=1

gpgkey=https://packages.microsoft.com/keys/microsoft.asc

EOF

$ sudo dnf install code

Binary releases of VS Code without MS branding/telemetry/licensing.

$ sudo tee -a /etc/yum.repos.d/vscodium.repo << 'EOF'

[gitlab.com_paulcarroty_vscodium_repo]

name=gitlab.com_paulcarroty_vscodium_repo

baseurl=https://paulcarroty.gitlab.io/vscodium-deb-rpm-repo/rpms/

enabled=1

gpgcheck=1

repo_gpgcheck=1

gpgkey=https://gitlab.com/paulcarroty/vscodium-deb-rpm-repo/raw/master/pub.gpg

metadata_expire=1h

EOF

$ dnf install codium

Fedora System

Package Manager

Managing DNF Repository

DNF repositories commonly provide their own .repo file. To add such a repository to your system and enable it, run the following command as root:

dnf config-manager --add-repo repository_url

To enable a particular repository or repositories, type the following at a shell prompt as root:

dnf config-manager --set-enabled repository…

To disable a DNF repository, run the following command as root:

dnf config-manager --set-disabled repository…

For example, Google Chrome Repository:

$ cat /etc/yum.repos.d/google-chrome.repo

[google-chrome]

name=google-chrome

baseurl=https://dl.google.com/linux/chrome/rpm/stable/x86_64

enabled=1

gpgcheck=1

gpgkey=https://dl.google.com/linux/linux_signing_key.pub

$ sudo dnf config-manager --set-enabled google-chrome

$ sudo dnf install google-chrome-stable

DNF System Upgrade

$ sudo dnf upgrade --refresh

$ sudo reboot

$ sudo dnf install dnf-plugin-system-upgrade

$ sudo dnf system-upgrade download --releasever=35

$ sudo dnf system-upgrade reboot

- Change the

--releasever=number if you want to upgrade to a different release. - If some of your packages have unsatisfied dependencies, the upgrade will refuse to continue until you run it again with an extra

--allowerasingoption. This often happens with packages installed from third-party repositories for which an updated repositories hasn’t been yet published. Study the output very carefully and examine which packages are going to be removed. None of them should be essential for system functionality, but some of them might be important for your productivity.- In case of unsatisfied dependencies, you can sometimes see more details if you add

--bestoption to the command line. - If you want to remove/install some packages manually before running

dnf system-upgrade downloadagain, it is advisable to perform those operations with--setopt=keepcache=1dnf command line option. Otherwise the whole package cache will be removed after your operation, and you will need to download all the packages once again.

- In case of unsatisfied dependencies, you can sometimes see more details if you add

- There are other important optional operations here, please read the official documentation.

DNF local plugin

An internet search yields two common solutions that eliminate or reduce repeat downloads of the same RPM set – create a private Fedora Linux mirror or set up a caching proxy.

Fedora provides guidance on setting up a [private mirror](https://fedoraproject.org/wiki/ Infrastructure/Mirroring#How_can_someone_make_a_private_mirror). A mirror requires a lot of bandwidth and disk space and significant work to maintain. A full private mirror would be too expensive and it would be overkill for my purposes.

The most common solution I found online was to implement a caching proxy using Squid. I had two concerns with this type of solution. First, I would need to edit repository definitions stored in /etc/yum.repo.d on each virtual and physical machine or container to use the same mirror. Second, I would need to use http and not https connections which would introduce a security risk.

After reading Glenn’s 2018 post on the DNF local plugin, I searched for additional information but could not find much of anything besides the sparse documentation for the plugin on the DNF documentation web site. This article is intended to raise awareness of this plugin.

Use DNS over TLS

dnf updateinfo

First, check the updates available:

$ dnf check-update

OK, so run your first dnf updateinfo command:

$ dnf updateinfo

Look at the list of updates and which types they belong to:

$ dnf updateinfo list

The next command will list the actual changelog.

$ dnf updateinfo info

install only security and bugfixes updates

$ dnf check-update --security --bugfix

$ sudo dnf update --security --bugfix

Install only specific updates

$ sudo dnf update --advisories=FEDORA-2021-74ebf2f06f,FEDORA-2021-83fdddca0f

XFS 檔案系統簡介

CentOS 7 開始,預設的檔案系統已經由原本的 EXT4 變成了 XFS 檔案系統了!為啥 CentOS 要捨棄對 Linux 支援度最完整的 EXT 家族而改用 XFS 呢? 這是有一些原因存在的。

EXT 家族當前較傷腦筋的地方:支援度最廣,但格式化超慢!

Ext 檔案系統家族對於檔案格式化的處理方面,採用的是預先規劃出所有的 inode/block/meta data 等資料,未來系統可以直接取用, 不需要再進行動態配置的作法。這個作法在早期磁碟容量還不大的時候還算 OK 沒啥問題,但時至今日,磁碟容量越來越大,連傳統的 MBR 都已經被 GPT 所取代,連我們這些老人家以前聽到的超大 TB 容量也已經不夠看了!現在都已經說到 PB 或 EB 以上容量了呢!那妳可以想像得到,當你的 TB 以上等級的傳統 ext 家族檔案系統在格式化的時候,光是系統要預先分配 inode 與 block 就消耗你好多好多的人類時間了…

Tips:之前格式化過一個 70 TB 以上的磁碟陣列成為 ext4 檔案系統,按下格式化,去喝了咖啡、吃了便當才回來看做完了沒有… 所以,後來立刻改成 xfs 檔案系統了。

另外,由於虛擬化的應用越來越廣泛,而作為虛擬化磁碟來源的巨型檔案 (單一檔案好幾個 GB 以上!) 也就越來越常見了。 這種巨型檔案在處理上需要考慮到效能問題,否則虛擬磁碟的效率就會不太好看。因此,從 CentOS 7.x 開始, 檔案系統已經由預設的 Ext4 變成了 xfs 這一個較適合高容量磁碟與巨型檔案效能較佳的檔案系統了。

Tips:其實鳥哥有幾組虛擬電腦教室伺服器系統,裡面跑的確實是 EXT4 檔案系統,老實說,並不覺得比 xfs 慢!所以,對鳥哥來說, 效能並不是主要改變檔案系統的考量!對於檔案系統的復原速度、建置速度,可能才是鳥哥改換成 xfs 的思考點。

XFS 檔案系統的配置

基本上 xfs 就是一個日誌式檔案系統,而 CentOS 7.x 拿它當預設的檔案系統,自然就是因為最早之前,這個 xfs 就是被開發來用於高容量磁碟以及高效能檔案系統之用, 因此,相當適合現在的系統環境。此外,幾乎所有 Ext4 檔案系統有的功能, xfs 都可以具備!也因此在本小節前幾部份談到檔案系統時, 其實大部份的操作依舊是在 xfs 檔案系統環境下介紹給各位的哩!

xfs 檔案系統在資料的分佈上,主要規劃為三個部份,一個資料區 (data section)、一個檔案系統活動登錄區 (log section)以及一個即時運作區 (realtime section)。 這三個區域的資料內容如下:

- 資料區 (data section)

基本上,資料區就跟我們之前談到的 ext 家族一樣,包括 inode/data block/superblock 等資料,都放置在這個區塊。 這個資料區與 ext 家族的 block group 類似,也是分為多個儲存區群組 (allocation groups) 來分別放置檔案系統所需要的資料。 每個儲存區群組都包含了 (1)整個檔案系統的 superblock、 (2)剩餘空間的管理機制、 (3)inode的分配與追蹤。此外,inode與 block 都是系統需要用到時, 這才動態配置產生,所以格式化動作超級快!

另外,與 ext 家族不同的是, xfs 的 block 與 inode 有多種不同的容量可供設定,block 容量可由 512bytes ~ 64K 調配,不過,Linux 的環境下, 由於記憶體控制的關係 (分頁檔 pagesize 的容量之故),因此最高可以使用的 block 大小為 4K 而已!(鳥哥嘗試格式化 block 成為 16K 是沒問題的,不過,Linux 核心不給掛載! 所以格式化完成後也無法使用啦!) 至於 inode 容量可由 256bytes 到 2M 這麼大!不過,大概還是保留 256bytes 的預設值就很夠用了!

Tips:總之, xfs 的這個資料區的儲存區群組 (allocation groups, AG),你就將它想成是 ext 家族的 block 群組 (block groups) 就對了!本小節之前講的都可以在這個區塊內使用。 只是 inode 與 block 是動態產生,並非一開始於格式化就完成配置的。

- 檔案系統活動登錄區 (log section)

在登錄區這個區域主要被用來紀錄檔案系統的變化,其實有點像是日誌區啦!檔案的變化會在這裡紀錄下來,直到該變化完整的寫入到資料區後, 該筆紀錄才會被終結。如果檔案系統因為某些緣故 (例如最常見的停電) 而損毀時,系統會拿這個登錄區塊來進行檢驗,看看系統掛掉之前, 檔案系統正在運作些啥動作,藉以快速的修復檔案系統。

因為系統所有動作的時候都會在這個區塊做個紀錄,因此這個區塊的磁碟活動是相當頻繁的!xfs 設計有點有趣,在這個區域中, 妳可以指定外部的磁碟來作為 xfs 檔案系統的日誌區塊喔!例如,妳可以將 SSD 磁碟作為 xfs 的登錄區,這樣當系統需要進行任何活動時, 就可以更快速的進行工作!相當有趣!

- 即時運作區 (realtime section)

當有檔案要被建立時,xfs 會在這個區段裡面找一個到數個的 extent 區塊,將檔案放置在這個區塊內,等到分配完畢後,再寫入到 data section 的 inode 與 block 去! 這個 extent 區塊的大小得要在格式化的時候就先指定,最小值是 4K 最大可到 1G。一般非磁碟陣列的磁碟預設為 64K 容量,而具有類似磁碟陣列的 stripe 情況下,則建議 extent 設定為與 stripe 一樣大較佳。這個 extent 最好不要亂動,因為可能會影響到實體磁碟的效能喔。

XFS 檔案系統的描述資料觀察

剛剛講了這麼多,完全無法理會耶~有沒有像 EXT 家族的 dumpe2fs 去觀察 superblock 內容的相關指令可以查閱呢?有啦!可以使用 xfs_info 去觀察的! 詳細的指令作法可以參考如下:

[root@study ~]# xfs_info 掛載點|裝置檔名

範例一:找出系統 /boot 這個掛載點底下的檔案系統的 superblock 紀錄

[root@study ~]# df -T /boot

Filesystem Type 1K-blocks Used Available Use% Mounted on

/dev/vda2 xfs 1038336 133704 904632 13% /boot

# 沒錯!可以看得出來是 xfs 檔案系統的!來觀察一下內容吧!

[root@study ~]# xfs_info /dev/vda2

1 meta-data=/dev/vda2 isize=256 agcount=4, agsize=65536 blks

2 = sectsz=512 attr=2, projid32bit=1

3 = crc=0 finobt=0

4 data = bsize=4096 blocks=262144, imaxpct=25

5 = sunit=0 swidth=0 blks

6 naming =version 2 bsize=4096 ascii-ci=0 ftype=0

7 log =internal bsize=4096 blocks=2560, version=2

8 = sectsz=512 sunit=0 blks, lazy-count=1

9 realtime =none extsz=4096 blocks=0, rtextents=0

上面的輸出訊息可以這樣解釋:

- 第 1 行裡面的 isize 指的是 inode 的容量,每個有 256bytes 這麼大。至於 agcount 則是前面談到的儲存區群組 (allocation group) 的個數,共有 4 個, agsize 則是指每個儲存區群組具有 65536 個 block 。配合第 4 行的 block 設定為 4K,因此整個檔案系統的容量應該就是 4655364K 這麼大!

- 第 2 行裡面 sectsz 指的是邏輯磁區 (sector) 的容量設定為 512bytes 這麼大的意思。

- 第 4 行裡面的 bsize 指的是 block 的容量,每個 block 為 4K 的意思,共有 262144 個 block 在這個檔案系統內。

- 第 5 行裡面的 sunit 與 swidth 與磁碟陣列的 stripe 相關性較高。這部份我們底下格式化的時候會舉一個例子來說明。

- 第 7 行裡面的 internal 指的是這個登錄區的位置在檔案系統內,而不是外部設備的意思。且佔用了 4K * 2560 個 block,總共約 10M 的容量。

- 第 9 行裡面的 realtime 區域,裡面的 extent 容量為 4K。不過目前沒有使用。

由於我們並沒有使用磁碟陣列,因此上頭這個裝置裡頭的 sunit 與 extent 就沒有額外的指定特別的值。根據 xfs(5) 的說明,這兩個值會影響到你的檔案系統性能, 所以格式化的時候要特別留意喔!上面的說明大致上看看即可,比較重要的部份已經用特殊字體圈起來,你可以瞧一瞧先!

Rosetta

由于我主要使用 ubuntu,为学习而使用 fedora,只是短时期使用过其他发行版,因此截取部分如下。

Basic operations

| Action | Red Hat/Fedora | Debian/Ubuntu |

|---|---|---|

| Search for package(s) by searching the expression in name, description, short description. What exact fields are being searched by default varies in each tool. Mostly options bring tools on par. | dnf search |

apt search |

| Install a package(s) by name | dnf install |

apt install |

| Upgrade Packages - Install packages which have an older version already installed | dnf upgrade |

apt update and then apt upgrade |

| Upgrade Packages - Another form of the update command, which can perform more complex updates – like distribution upgrades. When the usual update command will omit package updates, which include changes in dependencies, this command can perform those updates. | dnf distro-sync |

apt update and then apt dist-upgrade |

| Remove a package(s) and all dependencies by name | dnf remove |

apt autoremove |

| Remove a package(s) and its configuration files | ? | apt purge |

| Remove a package(s) and all dependencies and configuration files | ? | apt autoremove --purge |

| Remove dependencies that are no longer needed (orphans), because e.g. the package which needed the dependencies was removed. | dnf autoremove |

apt autoremove |

| Remove packages no longer included in any repositories. | dnf repoquery --extras |

aptitude purge '~o' |

| Mark a package previously installed as a dependency as explicitly required. | dnf mark install |

apt-mark manual |

| Install package(s) as dependency / without marking as explicitly required. | dnf install and then dnf mark remove |

apt-mark auto |

| Only downloads the given package(s) without unpacking or installing them | dnf download |

apt install --download-only (into the package cache) or apt download (bypass the package cache) |

| Clean up all local caches. Options might limit what is actually cleaned. | dnf clean all |

apt autoclean removes only unneeded, obsolete information or apt clean |

| Start a shell to enter multiple commands in one session | dnf shell |

|

| Show a log of actions taken by the software management. | dnf history |

read /var/log/dpkg.log |

| Get a dump of the whole system information - Prints, Saves or similar the current state of the package management system. Preferred output is text or XML. (Note: Why either-or here? No tool offers the option to choose the output format.) | see /var/lib/rpm/Packages |

apt-cache stats |

| e-mail delivery of package changes | apt install apt-listchanges |

Querying specific packages

| Action | Red Hat/Fedora | Debian/Ubuntu |

|---|---|---|

| Show all or most information about a package. The tools' verbosity for the default command vary. But with options, the tools are on par with each other. | dnf list or dnf info |

apt show or apt-cache policy |

| Display local package information: Name, version, description, etc. | rpm -qi / dnf info installed |

dpkg -s or aptitude show |

| Display remote package information: Name, version, description, etc. | dnf info |

apt-cache show or aptitude show |

| Display files provided by local package | rpm -ql |

dpkg -L |

| Display files provided by a remote package | dnf repoquery -l or repoquery -l (from package yum-utils) |

apt-file list |

| Query the package which provides FILE | rpm -qf (installed only) or dnf provides (everything) or repoquery -f (from package yum-utils) |

dpkg -S or dlocate |

| List the files that the package holds. Again, this functionality can be mimicked by other more complex commands. | dnf repoquery -l |

dpkg-query -L |

| Displays packages which provide the given exp. aka reverse provides. Mainly a shortcut to search a specific field. Other tools might offer this functionality through the search command. | dnf provides |

apt-file search |

| Search all packages to find the one which holds the specified file. | dnf provides |

apt-file search or auto-apt is using this functionality. |

| Show the changelog of a package | dnf changelog |

apt-get changelog |

Querying package lists

| Action | Red Hat/Fedora | Debian/Ubuntu |

|---|---|---|

| Search for package(s) by searching the expression in name, description, short description. What exact fields are being searched by default varies in each tool. Mostly options bring tools on par. | dnf search |

apt search |

| Lists packages which have an update available. Note: Some provide special commands to limit the output to certain installation sources, others use options. | dnf list updates or dnf check-update |

apt list --upgradable |

| Display a list of all packages in all installation sources that are handled by the packages management. Some tools provide options or additional commands to limit the output to a specific installation source. | dnf list available |

apt-cache dumpavail or apt-cache dump (Cache only) or apt-cache pkgnames |

| Generates a list of installed packages | dnf list installed |

`dpkg –list |

| List packages that are installed but are not available in any installation source (anymore). | dnf list extras |

`apt –installed list |

| List packages that were recently added to one of the installation sources, i.e. which are new to it. | dnf list recent |

aptitude search '~N' or aptitude forget-new |

| List installed local packages along with version | rpm -qa |

dpkg -l or apt list --installed |

| Search locally installed package for names or descriptions | rpm -qa '*<str>*' |

`aptitude search ‘~i(~n $name |

| List packages not required by any other package | dnf leaves or package-cleanup --leaves --all |

deborphan -anp1 |

| List packages installed explicitly (not as dependencies) | dnf history userinstalled |

apt-mark showmanual |

| List packages installed automatically (as dependencies) | grep -E ‘^i[^+]’ (workaround) | apt-mark showauto |

Querying package dependencies

| Action | Red Hat/Fedora | Debian/Ubuntu |

|---|---|---|

| Display packages which require X to be installed, aka show reverse dependencies. | dnf repoquery --alldeps --whatrequires or repoquery --whatrequires |

apt-cache rdepends or aptitude search ~D$pattern |

| Display packages which conflict with given expression (often package). Search can be used as well to mimic this function. | dnf repoquery --conflicts |

aptitude search '~C$pattern' |

| List all packages which are required for the given package, aka show dependencies. | dnf repoquery --requires or repoquery -R |

apt-cache depends or apt-cache show |

| List what the current package provides | dnf repoquery --provides |

dpkg -s or aptitude show |

| List all packages that require a particular package | dnf repoquery --installed --alldeps --whatrequires |

aptitude search ~D{depends,recommends,suggests}:$pattern or aptitude why |

| Display all packages that the specified packages obsoletes. | dnf list obsoletes |

apt-cache show |

| Generates an output suitable for processing with dotty for the given package(s). | apt-cache dotty |

Installation sources management

| Action | Red Hat/Fedora | Debian/Ubuntu |

|---|---|---|

| Installation sources management | edit /etc/yum.repos.d/${REPO}.repo |

edit /etc/apt/sources.list |

| Add an installation source to the system. Some tools provide additional commands for certain sources, others allow all types of source URI for the add command. Again others, like apt and dnf force editing a sources list. apt-cdrom is a special command, which offers special options design for CDs/DVDs as source. | /etc/yum.repos.d/*.repo |

apt-cdrom add |

| Refresh the information about the specified installation source(s) or all installation sources. | dnf clean expire-cache and then dnf check-update |

apt-get update |

| Prints a list of all installation sources including important information like URI, alias etc. | cat /etc/yum.repos.d/* |

apt-cache policy |

| List all packages from a certain repo | ||

| Disable an installation source for an operation | dnf --disablerepo= |

|

| Download packages from a different version of the distribution than the one installed. | dnf --releasever= |

apt-get install -t release package or apt-get install package/release (dependencies not covered) |

Overrides

| Action | Red Hat/Fedora | Debian/Ubuntu |

|---|---|---|

| Add a package lock rule to keep its current state from being changed | edit dnf.conf adding/amending the exclude option |

apt-mark hold pkg |

| Delete a package lock rule | apt-mark unhold pkg |

|

| Show a listing of all lock rules | /etc/apt/preferences |

|

| Set the priority of the given package to avoid upgrade, force downgrade or to overwrite any default behavior. Can also be used to prefer a package version from a certain installation source. | /etc/apt/preferences, apt-cache policy |

|

| Remove a previously set priority | /etc/apt/preferences |

|

| Show a list of set priorities | apt-cache policy or /etc/apt/preferences |

|

| Ignore problems that priorities may trigger. |

Verification and repair

| Action | Red Hat/Fedora | Debian/Ubuntu |

|---|---|---|

| Verify single package | rpm -V |

debsums |

| Verify all packages | rpm -Va |

debsums |

| Reinstall given package; this will reinstall the given package without dependency hassle | dnf reinstall |

apt install --reinstall |

| Verify dependencies of the complete system; used if installation process was forcefully killed | dnf repoquery --requires |

apt-get check |

| Use some magic to fix broken dependencies in a system | dnf repoquery --unsatisfied |

apt-get --fix-broken and then aptitude install |

| Add a checkpoint to the package system for later rollback | (unnecessary, it is done on every transaction) | |

| Remove a checkpoint from the system | n/a | |

| Provide a list of all system checkpoints | dnf history list |

|

| Rolls entire packages back to a certain date or checkpoint | dnf history rollback |

|

| Undo a single specified transaction | dnf history undo |

Using package files and building packages

| Action | Red Hat/Fedora | Debian/Ubuntu |

|---|---|---|

| Query a package supplied on the command line rather than an entry in the package management database | rpm -qp |

dpkg -I |

| List the contents of a package file | rpmls rpm -qpl |

dpkg -c |

| Install local package file, e.g. app.rpm and uses the installation sources to resolve dependencies | dnf install |

apt install |

| Updates package(s) with local packages and uses the installation sources to resolve dependencies | dnf upgrade |

debi |

| Add a local package to the local package cache mostly for debugging purposes. | apt-cache add *package-filename* |

|

| Extract a package | `rpm2cpio | cpio -vid` |

| Install/Remove packages to satisfy build-dependencies. Uses information in the source package | dnf builddep |

apt-get build-dep |

| Display the source package to the given package name(s) | dnf repoquery -s |

apt-cache showsrc |

| Download the corresponding source package(s) to the given package name(s) | dnf download --source |

apt-get source or debcheckout |

| Build a package | rpmbuild -ba (normal) or mock (in chroot) |

debuild |

| Check for possible packaging issues | rpmlint | lintian |

Fedora Tips

kill

kill 是向进程发送信号的命令。

| 代号 | 名称 | 内容 |

|---|---|---|

| 1 | SIGHUP | 启动被终止的程序,可让该进程重新读取自己的配置文件,类似重新启动。 |

| 2 | SIGINT | 相当于用键盘输入 [ctrl]-c 来中断一个程序的进行。 |

| 9 | SIGKILL | 代表强制中断一个程序的进行,如果该程序进行到一半,那么尚未完成的部分可能会有“半产品”产生,类似 vim会有 .filename.swp 保留下来。 |

| 15 | SIGTERM | 以正常的方式来终止该程序。由于是正常的终止,所以后续的动作会将他完成。不过,如果该程序已经发生问题,就是无法使用正常的方法终止时,输入这个 signal 也是没有用的。 |

| 19 | SIGSTOP | 相当于用键盘输入 [ctrl]-z 来暂停一个程序的进行。 |

Shell freezes

In the event of a shell freeze (which might be caused by certain appearance tweaks, malfunctioning extensions or perhaps a lack of available memory), restarting the shell by pressing Alt+F2 and then entering r may not be possible.

In this case, try switching to another TTY (Ctrl+Alt+F2) and entering the following command: pkill -HUP gnome-shell. It may take a few seconds before the shell successfully restarts. On X11, restarting the shell in this fashion should not log the user out, but it is a good idea to try and ensure that all work is saved anyway; on Wayland (currently the default), restarting the shell kills the whole session, so everything will be lost.

If this fails, the Xorg server will need to be restarted either by pkill X for console logins or by restarting gdm.service for GDM logins. Bear in mind that restarting the Xorg server will log the user out, so try to ensure that all work is saved before attempting this.

fix a frozen Gnome desktop session

在较旧的 Gnome(即 Gnome 3.28 之前)中,您可以使用此命令重新启动 GNome shell。

$ glxinfo | grep display

name of display: :1

display: :1 screen: 0

$ touch gnome-restart

$ echo '#!/bin/bash' > gnome-restart

$ echo 'DISPLAY=:1 gnome-shell --replace &' >> gnome-restart

$ sudo chmod +x gnome-restart

$ ./gnome-restart

重启 Gnome Shell

可以使用 busctl --user call org.gnome.Shell /org/gnome/Shell org.gnome.Shell Eval s 'Meta.restart("Restarting…")' 命令行执行 ALT + F2 r 相同的操作。

亦可:

$ sudo systemctl restart systemd-logind

Gaming on Fedora

Fedora 33 百度网盘Linux版

那个 rpm 包压根不是对标最新的Fedora的,而是给那些基于RHEL的同样使用rpm包管理的古董国产操作系统使用的。

下载 baidunetdisk_3.5.0_amd64.deb,并解压出实际的程序。

首先我们跑一下,看看bt 吧:

Thread 1 "baidunetdisk" received signal SIGSEGV, Segmentation fault.

0x00007ffff5096179 in EVP_MD_CTX_clear_flags () from /lib64/libcrypto.so.1.1

(gdb) bt

目测翻车在libcrypto.so.1.1, 而且是跟sqlite加密有关.

我们把baidunetdisk动态链接到相关的加密库都找出来:

$ ldd baidunetdisk | grep -i -E 'ssl|crypt'

libgcrypt.so.20 => /lib64/libgcrypt.so.20 (0x00007fa18d693000)

libk5crypto.so.3 => /lib64/libk5crypto.so.3 (0x00007fa18d3cd000)

libcrypto.so.1.1 => /lib64/libcrypto.so.1.1 (0x00007fa18d0c0000)

经验告诉我,这个baidunetdisk挂的原因是, Fedora 33上面的包都比较新,尤其是 openssl 库. 因此,解决办法是,去下载老版本的 Ubuntu 18.04 的包,然后把so文件取出来,强制baidunetdisk使用这些旧版本的库即可.

ldd 一下很容易找出依赖关系: libkrb5.so.3 -> libk5crypto.so.3 -> libcrypto.so.1.1

下载以下包:

https://ubuntu.pkgs.org/18.04/ubuntu-main-amd64/libkrb5support0_1.16-2build1_amd64.deb.html

https://ubuntu.pkgs.org/18.04/ubuntu-main-amd64/libk5crypto3_1.16-2build1_amd64.deb.html

https://ubuntu.pkgs.org/18.04/ubuntu-main-amd64/libkrb5-3_1.16-2build1_amd64.deb.html

https://ubuntu.pkgs.org/18.04/ubuntu-main-amd64/libgssapi-krb5-2_1.16-2build1_amd64.deb.html

http://archive.ubuntu.com/ubuntu/pool/main/o/openssl/libssl1.1_1.1.0g-2ubuntu4_amd64.deb

编辑 /usr/share/applications/baidunetdisk.desktop, 将Exec=/opt/baidunetdisk/baidunetdisk --no-sandbox %U 修改成:

Exec=/bin/env LD_LIBRARY_PATH=/home/ttys3/Apps/baidunetdisk /home/ttys3/Apps/baidunetdisk/baidunetdisk --no-sandbox %U

ldd 查看程序依赖库

作用:用来查看程式运行所需的共享库,常用来解决程式因缺少某个库文件而不能运行的一些问题。

示例:查看test程序运行所依赖的库:

/opt/app/todeav1/test$ ldd test

libstdc++.so.6 => /usr/lib64/libstdc++.so.6 (0x00000039a7e00000)

libm.so.6 => /lib64/libm.so.6 (0x0000003996400000)

libgcc_s.so.1 => /lib64/libgcc_s.so.1 (0x00000039a5600000)

libc.so.6 => /lib64/libc.so.6 (0x0000003995800000)

/lib64/ld-linux-x86-64.so.2 (0x0000003995400000)

/opt/app/todeav1/test$ ldd libc.so.6

...

- 第一列:程序需要依赖什么库

- 第二列: 系统提供的与程序需要的库所对应的库

- 第三列:库加载的开始地址

通过上面的信息,我们可以得到以下几个信息:

- 通过对比第一列和第二列,我们可以分析程序需要依赖的库和系统实际提供的,是否相匹配

- 通过观察第三列,我们可以知道在当前的库中的符号在对应的进程的地址空间中的开始位置

如果依赖的某个库找不到,通过这个命令可以迅速定位问题所在。

原理: ldd不是个可执行程式,而只是个shell脚本; ldd显示可执行模块的dependency的工作原理,其实质是通过ld-linux.so(elf动态库的装载器)来实现的。ld-linux.so模块会先于executable模块程式工作,并获得控制权,因此当上述的那些环境变量被设置时,ld-linux.so选择了显示可执行模块的dependency。

adb and fastboot

$ sudo dnf install android-tools

OneDrive 加速

OneDrive 的下载速度,明白的都明白,不懂得也就算了 。

PC 端(手机端应该也可以)有一个可能有效的提速方法是:

- 前往:https://tools.ipip.net/traceroute.php

- 左侧 ipv6 或 ipv4 选择离自己最近的运营商,右侧 ICMP 填入

sharepoint.com - 搜索之后将延时最短的非局域网 ip 填入在

hosts文件中 - 保存,使之生效,可以在控制台

ping sharepoint.com查看是否成功解析到新的 ip

Recover a root password

-

Boot the Live installation media and choose

Try Fedora. -

From the desktop, open a terminal and switch to root using

su(the system will not ask for a password). -

To view your hard drive device nodes, enter

df -Hinto the terminal. For this example we will use/dev/sda1for the/bootpartition and/dev/sda2for the root/partition.If you are using LVM partitions, type:

sudo lvscanand note the/devpath of your root partition. For this example we will use/dev/fedora/root. -

Create a directory for the mount point (use the

-poption to create subdirectories):mkdir -p /mnt/sysimage/boot -

Mount the

/(root) partition (be sure to use the actual device node or LVM path of your root/partition):To mount root on a standard partition scheme enter:

mount /dev/sda2 /mnt/sysimageTo mount root on an LVM partition scheme enter:

mount /dev/fedora/root /mnt/sysimage -

Continue the process by mounting

/boot,proc,/dev, and/runwith:mount /dev/sda1 /mnt/sysimage/boot mount -t proc none /mnt/sysimage/proc mount -o bind /dev /mnt/sysimage/dev mount -o bind /run /mnt/sysimage/run -

chrootto the mounted root partition with:chroot /mnt/sysimage /bin/bash -

Change the root password:

passwd -

Exit out of chroot with:

exitand exit out of the terminal.

-

Reboot your system and boot from the hard drive.

Congratulations, your root password has been successfully changed.

Samba Server

Install and Configure Samba

To get started with samba, you need to install the samba core packages and samba-client package as shown:

# dnf install samba samba-common samba-client

After all the samba is installed, you need to configure the samba share directory with proper permissions and ownership, so that it is going to be shared with all client machines in the same local network.

# mkdir -p /srv/tecmint/data

# chmod -R 755 /srv/tecmint/data

# chown -R nobody:nobody /srv/tecmint/data

# chcon -t samba_share_t /srv/tecmint/data

Next, we are going to configure the Samba share directory in the smb.conf file, which is the main configuration file for Samba.

# mv /etc/samba/smb.conf /etc/samba/smb.conf.bak

# vim /etc/samba/smb.conf

Add the following configuration lines, which define the policies on who can access the samba share on the network.

[global]

workgroup = WORKGROUP

server string = Samba Server %v

netbios name = rocky-8

security = user

map to guest = bad user

dns proxy = no

ntlm auth = true

[Public]

path = /srv/tecmint/data

browsable =yes

writable = yes

guest ok = yes

read only = no

Save and exit the configuration file.

Next, verify the samba configuration for errors.

# testparm

If everything looks okay, make sure to start, enable and verify the status of the Samba daemons.

# systemctl start smb

# systemctl enable smb

# systemctl start nmb

# systemctl enable nmb

# systemctl status smb

# systemctl status nmb

Accessing Samba Share from Windows

To access Samba share from the Windows machine, press the Windows logo key + R to launch the Run dialog and enter the IP address of the samba server

Secure Samba Share Directory

To secure our Samba share, we need to create a new samba user.

# useradd smbuser

# smbpasswd -a smbuser

Next, create a new group and add the new samba user to this group.

# sudo groupadd smb_group

# sudo usermod -g smb_group smbuser

Thereafter, create another secure samba share directory for accessing files securely by samba users.

# mkdir -p /srv/tecmint/private

# chmod -R 770 /srv/tecmint/private

# chcon -t samba_share_t /srv/tecmint/private

# chown -R root:smb_group /srv/tecmint/private

Once again, access the Samba configuration file.

# vi /etc/samba/smb.conf

Add these lines to define to secure samba share.

[Private]

path = /srv/tecmint/private

valid users = @smb_group

guest ok = no

writable = no

browsable = yes

Save the changes and exit.

Finally, restart all the samba daemons as shown.

$ sudo systemctl restart smb

$ sudo systemctl restart nmb

Now try to access the Samba share, this time you will see an additional ‘Private‘ directory. To access this directory, you will be required to authenticate with the Samba user’s credentials

[MIT/GNU Scheme](MIT/GNU Scheme)

9.2 是最后支持 windows 的版本,之前的版本我在fedora上编译失败了。

$ wget https://ftp.gnu.org/gnu/mit-scheme/stable.pkg/9.2/mit-scheme-9.2-x86-64.tar.gz

$ sudo dnf install gcc make m4 ncurses-devel libX11-devel

$ tar xzf mit-scheme-VERSION-i386.tar.gz

$ cd mit-scheme-VERSION/src

$ sudo ./configure --prefix=/opt/mit-scheme

$ sudo make

$ sudo make install

WAV、FLAC、APE

区别

同一个音乐文件而言,WAV、FLAC、APE三种音乐格式的音质是完全一样的。

意思是说,从CD碟上抓轨出来后,得到的WAV和APE、FLAC音质完全相同,实际上是不同形式的同一个文件。但与CD碟是否完全一样,除了抓轨操作问题,基本上都是电脑设备技术所限。(你不能要求电脑器材技术同灌制唱片的专业器材一致,电脑只是个均衡性技术器材组合体。)

所以,从收藏角度来说,三种格式可以,一样。但播放效果上,上万元的专业设备和神经质般的金耳朵是能听出些许差别来的,这主要是因为不同格式间因编码不同导致解码速度不同所致;如果转换为同一种格式,正常听是没有区别的。

那么,APE、FLAC、WAV三种格式区别在哪里呢?(这些区别并不是说音乐文件本身品质有优劣)

-

编码不同,导致解码速度WAV > FLAC > APE,直接影响到播放听感流畅性上:WAV > FLAC > APE

WAV波形文件是音响设备和很多软件可以直接读取的波形文件,基本上不存在编解码问题。flac和ape都对WAV进行了编码,故能换取较小的体积,但同时造成解码播放时,因播放器材解析力很敏感(或者说技术所限),会因出现一定的jitter抖动(解析复杂编码所致)而导致播放效果不够饱满和流畅。这点你可以通过统一转换为WAV格式来试听解决。

-

编码不同,导致所占空间大小 APE < FLAC < WAV。

由于flac和ape都对WAV进行了更高技术的编码,所以换取了较小的体积,这也是这两种格式之所以出现的根本原因。由于二者都是无损压缩,如果你是为了收藏,同时你的空间比较吃紧,无疑收藏较小体积的APE是最佳选择。至于以后会不会出现更小体积的无损压缩格式,但目前来说,APE 是最优选择。

-

编码不同,解码速度不一,导致占用CPU和耗电量不同。

编码越复杂,解码越麻烦,自然占用内存率越高,耗电量自然越大。那些伤不起的播放机们感触最深,同样的电量,三种格式播放时长依次为由长到短:WAV > FLAC > APE,所以,如果你的P5播放机比较脆弱,自然选择WAV可以享受更长时间的音乐。

-

开源性不同,导致纠错效果不同。

这一点各取所需吧!很多flac粉们对APE的防纠错和容错性大为诟病,指责其一报错就无法继续播放,等于整轨作废,同时嫌技术不开放(难道你自己要编程?搞不懂这个意见也这么大)。而flac用静音处理方式他们就认为很好。

个人认为,如果播放的话,因为一个错误就整轨不能播放,等于白下载,的确很烦人,而flac静音处理得以继续播放下面的曲目,的确人性;但从收藏的角度而言,静音处理错误是不是有点瞒天过海、自欺欺人?发烧者和收藏癖们对人耳觉察不到的细微差别都耿耿于怀,怎么会放过这么大的差错?反正,如果有错误音轨,我是肯定不要收藏的,而APE,正好给我了检验好坏质量的途径。

-

开源性不同,导致支持软件多寡不均。

编码软件的支持上,大家都说支持flac的软件比ape多。这点没问题。但并不等于支持Ape格式的播放软件就少。实际上,现在已经有很多软件支持ape了。而且,支持flac的软件虽然多,也有很多不支持flac的,但wav就不一样了,还没有不支持WAV格式的播放器呢!这样说来,是不是也要把flac淘汰掉?!其实,听的时候就那么几首歌,转一下格式能够让你的播放器支持不就好啦。

从收藏角度讲,APE、FLAC、WAV三种格式一样,文件音质相同;从播放来讲,格式不同,专业设备下,效果可能会有人耳察觉不同的区别(楼主没感觉出来)。

扩展知识

无损音乐音质也分“三六九等”

同一个文件的各个无损格式是一样的音质,如果不是同一个文件,即使是同一首歌,音质也分三六九等。举个例子,彭丽媛的曲目《在希望的田野上》 ,收录于《非同凡响》、《沂蒙山小调》、《演唱中国民歌》、《珠穆朗玛》等多个音乐专辑,这些专辑分别由不同的唱片公司于不同的时间出版,音质就会参差不齐。同时,由于时代不同,技术上受历史局限。也会导致音质有别。

为什么无损音乐和CD比较,听觉上会有细微差别?

无损音乐与CD碟片数据信息完全一样,那为什么音效不一样呢?嗯,这里我用的“音效”这个词非常好。CD碟和原声一样吗?肯定不一样。主要是技术上根本做不到完全还原原声。而且,为了音乐效果,一般还会加进各种特效。CD播放机和电脑,更是两个功用完全不同的设备。音效当然不可能一致。

其实,就算CD播放机,也不可能找到两台播放效果完全一样的。有句话,大意是世界上不可能找到两把相同的二胡,也是这个意思。

假无损是怎么回事?

到这里,我就给大家提炼出一个观点:【“无损音乐”不等于“无损音质”】

除了碟片录制设备技术问题(早期碟片音质都不好;不同唱片公司录制技术层次不同;国内碟相对国外顶级技术也不好),也有假无损,即不是由正版CD碟片抓轨得到,而是通过盗版碟片抓轨、磁带(卡带)翻录甚至是有损音乐(MP3等)转换而得到。这些APE、FLAC、WAV等格式的所谓的“无损音乐”,其音质就很差很差。

除了第一个原因我们无奈选择外,其他的发烧友都应该剔除。对于磁带翻录,如果是稀有资源,建议大家保留,因为如果找不到无损,有总比无好。

我的音乐听起来音质不好,是无损吗?

前面说了,【“无损音乐”不等于“无损音质”】,无损音乐严格来说,是指wav波形文件从音乐CD碟片的无损数字记录和APE、FLAC、WavPack、WMALossless等则是对WAV波形文件进行无损压缩。wav是无损音乐文件,APE、FLAC等则是无损压缩音乐文件。绝对意义上讲,他们都不能完全替代CD碟。WAV波形文件在媒体播放器里直接播放,而APE等其他压缩格式则需要经过解压(解码)还原成WAV再进行播放。

如果你的无损音乐听感比较差,这你就要注意了

⒈ 是真无损,多见于早期碟片。由于上世纪CD碟片刚起步,技术水平有限,故灌制效果相对今天的碟片来说欠佳。此外,即使今天,不同唱片公司出品的碟片,音质也有差别。在没有替代品的情况下,建议保留。

⒉ 是真无损,音质不好可能由抓轨操作失误造成“爆音”等数据信息残缺,建议更换。

⒊ 显示真无损,音质极差。这多由磁带/卡带转录而来。早期歌手只有磁带作品留世,虽然音质不好,但是唯一的纪念品。将其转录为数据,是为了更好地保存。在没有替代品的情况下,建议保留。

⒋ 假无损。即由有损格式MP3、WMA、OGG等格式转换而来,有些凭耳听,甚至难与真无损辨别,只有软件能检测出。有损转无损,丢失的信息不会转回来。虽然体积增大了,音质还是有损的音质。

如何鉴别无损音乐?

如何鉴别?主要是一靠听、二靠看、三靠软件检测。

注意软件检测也会出错,只是作为参考。毕竟,音乐最主要的用途是欣赏,而不是科学精密研究。建议大家首先听。比如磁带转录的,一般一听就听出来。但软件检测未必检测出。这是因为软件作用只是检测哪些是由有损低劣的音乐转换成的伪劣假冒无损。

-

【一听】

听第一感觉,如果音质不好,甚至有爆音,即使是真无损,也是音质较差的低劣无损。

-

【二看】看占用空间大小和播放码率

看占用空间大小,一定要在相同格式的前提下,否则用APE和FLAC比较,是无意义的。一般,两个时长、内容一致的同名文件,占用空间越大者原则上包含信息越丰富、音质越好;看播放码率。

-

【三检测】用无损检验软件检测,和看频谱。

篇外篇

长期来,很多人对MP3印象不好,更多人认为WMA的最佳音质要好过MP3,这种说法是不正确的,在中高码率下,编码得当的MP3要比WMA优秀很多,可以非常接近CD音质,在不太好的硬件设备支持下,没有多少人可以区分两者的差异,这不是神话故事,尽管你以前盲听就可以很轻松区分MP3和CD,但现在你难保证你可以分辨正确。因为MP3也是优秀的编码,以前被埋没了。

大家都谈说音质好,一种是指还原度好,就是说和录制的时候差别越小越好;一种是指悦耳,就是好听。就mp3来说,mp3是一种压缩格式,码率越高,通常来说就代表压缩小,损失的细节比较少,也就是说,码率越高听起来越接近原声。但是音质还和你的输出设备有关,比如说一部好的mp3,一对好耳机,这都对你的听音音质有帮助!因此,如果想改善音质,不妨从以上几个角度出发,不要过分强调其中哪一方面。

视频编码码率控制

背景知识:

视频编码过程中,有一个重要步骤:量化,量化属于有损压缩过程。量化基本决定了视频的码率,视频的码率又从一定程度上决定了视频的质量。量化值QP越大则量化的粒度越高,压缩率越大,码率更小,视频质量越低,呈现出来就是马赛克比较大,画面不细腻,画面比较模糊。反之,压缩率低,码率大,质量高,画面细腻,细节丰富。

所以选择一个适合场景的视频码控方案很重要,调整视频输出码率其实就是在视频编码速度、网络带宽以及视频质量之间做一个平衡。有时网络带宽很受限,就要优先考虑码率大小优先的码控方案,有些对视频质量要求很高,要高清视频,那就要选择质量优先的模型。

整体来说选择视频编码码率控制方案,可以通过下面五个因素权衡得出:

-

视觉质量稳定性,利于视觉主观质量,比如清晰度,流畅度,细节等,这点和人眼的视觉原理有关,选择人眼主动质量感受最高的模型;

-

即时输出码率,相当于每帧编码输出比特数,要考虑网络带宽因素,随着移动互联网发展,也需要考虑wifi和无线网这块的影响;

-

输出视频文件大小可控,利于传输,存储,要看系统的空间大小;

-

编码速度,不同的码控模型也影响了编码速度,对于低延时、实时场景要考虑,因为不同的码控方案,计算的复杂度不同,带来的编码延时也有影响;

-

对于移动设备还需要不同编码方式耗电量要求,因为不同模型会影响编码和解码复杂度,进而在移动设备编码和播放需要的耗电量不同;

CBR

恒定码率(Constant Bit Rate),一定时间范围内比特率基本保持的恒定,属于码率优先模型。

**适用场景:**一般也不建议使用这种方式,虽然输出的码率总是处于一个稳定值,但是质量不稳定,不能充分有效利用网络带宽,因为这种模型不考虑视频内容的复杂性,把所有视频帧的内容统一对待。但是有些编码软件只支持固定质量或者固定码率方式,有时不得不用。用的时候在允许的带宽范围内尽可能把带宽设置大点,以防止复杂运动场景下视频质量很低,如果设置的不合理,在运动场景下直接就糊的看不成了。

特点:

- 码率稳定,但是质量不稳定,带宽有效利用率不高,特别当该值设置不合理,在复杂运动场景下,画面非常模糊,非常影响观看体验;

- 但是输出视频码率基本稳定,便于计算视频体积大小;

VBR

可变码率(Variable Bit Rate),简单场景分配比较大的QP,压缩率小,质量高。复杂场景分配较小QP。得到基本稳定的视觉质量,因为人眼人眼本来就对复杂场景不敏感,缺点在于输出码率大小不可控。

有两种调控模式:质量优先模式和2PASS二次编码模式。

质量优先模式:

不考虑输出视频文件的大小,完全按照视频的内容复杂程度来分配码率,这样视频的播放效果质量最好。

二次编码方式2PASS:

第一次编码检测视频内容的简单和复杂部分,同时确定简单和复杂的比例。第二遍编码会让视频的平均码率不变,复杂的地方分配多bit,简单地方分配少bit。这种编码虽然很好,但是速度会跟不上。

**适用场景:**VBR适用于那些对带宽和编码速度不太限制,但是对质量有很高要求的场景。特别是在运动的复杂场景下也可以保持比较高的清晰度且输出质量比较稳定,适合对延时不敏感的点播,录播或者存储系统。

特点:

- 码率不稳定,质量基本稳定且非常高;

- 编码速度一般比较慢,点播、下载和存储系统可以优先使用,不适合低延时、直播系统;

- 这种模型完全不考虑输出的视频带宽,为了质量,需要多少码率就占用多少,也不太考虑编码速度;

ABR

恒定平均目标码率(Average Bit Rate),简单场景分配较低bit,复杂场景分配足够bit,使得有限的bit数能够在不同场景下合理分配,这类似VBR。同时一定时间内,平均码率又接近设置的目标码率,这样可以控制输出文件的大小,这又类似CBR。可以认为是CBR和VBR的折中方案,这是大多人的选择。特别在对质量和视频带宽都有要求的情况下,可以优先选择该模式,一般速度是VBR的两倍到三倍,相同体积的视频文件质量却比CBR好很多。

**适用场景:**ABR在直播和低延时系统用的比较多,因为只编码了一次,所以速度快,同时兼顾了视频质量和带宽,对于转码速度有要求的情况下也可以选择该模式。B站的大部分视频就选择了该模式。

特点:

- 视频质量整体可控,同时兼顾了视频码率和速度,是一个折中方案,实际用的比较多;

- 使用过程一般要让调用方设置,最低码率、最高码率和平均码率,这些值要尽可能设置合理点;

总结

不懂的話沒關係,反正普遍情況是這樣的:

-

音質:CBR > VBR > ABR

192 kbps以下的CBR,與後兩者無明顯差異,但檔案容量差很多,建議有心要壓CBR就直接衝高流量!

-

檔案大小:CBR > VBR & ABR

後兩者隨參數設定而有差別,大致上差不了多少

DFF、DSF、DST

- DSD是SACD采用的信号调制方式,相当于CDDA(普通CD)采用的PCM调制方式。

- DSF、DFF是SACD碟片中数据的未压缩编码格式,DSF用于Sony,DFF用于Philips,相当于CDDA碟片中的WAV文件。

- DST是一种对SACD中DSF、DFF数据进行无损压缩的编码格式,相当于FLAC、APE是对CDDA中WAV数据的无损压缩。

RPM 搜索与下载网站

- pkgs.org:最好的

- rpm.pbone.net:比较全面但是下载速度有点慢

- rpmfind.net:速度还可以就是没有上面的全

- crpm.cn

误删了 /usr/share/icons 目录

-

从他们的官方网站下载您的操作系统的完整 ISO 并将其加载到驱动器中,然后将 /usr/share/applications 从 ISO 复制到您的系统。

-

reinstall

$ sudo dnf reinstall "$(rpm -qa)"

Flatpak 的亚洲字体问题

如果你遇到了游戏中无法显示亚洲字体的问题,这是因为 org.freedesktop.Platform 并没有包含合适的字体文件进去。首先尝试挂载你的本地字体:

$ flatpak run --filesystem=~/.local/share/fonts --filesystem=~/.config/fontconfig com.valvesoftware.Steam

如果上述命令不起作用,考虑动手 hack 一下:直接将字体文件复制进 org.freedesktop.Platform 的目录下以启用字体,例如

# replace ? with your version and hash

/var/lib/flatpak/runtime/org.freedesktop.Platform/x86_64/?/?/files/etc/fonts/conf.avail

/var/lib/flatpak/runtime/org.freedesktop.Platform/x86_64/?/?/files/etc/fonts/conf.d

/var/lib/flatpak/runtime/org.freedesktop.Platform/x86_64/?/?/files/share/fonts

SELinux policy for a systemd service

Check that the script is properly labeled as bin_t

$ sudo chcon -v -t bin_t /home/kurome/.opt/clash/clash_premium

FILTER RULES

~/.opt/rsync/backup-home:

+ /.config/

+ /.config/autostart/***

+ /.config/fontconfig/***

+ /.config/google-chrome/***

+ /.config/ibus/***

+ /.config/obsidian/***

+ /.config/Typora/***

+ /Documents/***

+ /.goldendict/***

+ /.local/

+ /.local/bin/***

+ /.local/share

+ /.local/share/applications/***

+ /.local/share/icons/***

+ /.local/share/TelegramDesktop/***

+ /Music/***

+ /.opt/***

+ /.ssh/***

+ /Templates/***

- /**

-

Using Rsync filter to include/exclude files

this won’t work:

+ /some/path/this-file-will-not-be-found + /file-is-included - *this set of rules works fine:

+ /some/ + /some/path/ + /some/path/this-file-is-found + /file-also-included - * -

exclude all directories except a few

$ cat filter.txt + /include_this_dir/ + /include_this_dir/** + /include_that_dir/ + /include_that_dir/** - /** $ rsync -av --dry-run --filter="merge filter.txt" source_dir/ dest_dir/You can reduce it further with three “*”, like

+ /include_this_dir/***, which means+ /include_this_dir/+/include_this_dir/**

~/.local/bin/backup-home:

#!/bin/bash

set -o errexit

set -o nounset

set -o pipefail

readonly SOURCE_DIR=/home/kurome/

readonly BACKUP_DIR="$(findmnt -nr -o target -S /dev/mapper/luks-5277e33d-604f-4c1e-bc8c-40c14544614e)/Backup/HomeData"

readonly DATETIME="$(date '+%Y-%m-%d_%H:%M:%S')"

readonly BACKUP_PATH="${BACKUP_DIR}/${DATETIME}"

readonly LATEST_LINK="${BACKUP_DIR}/latest"

rsync -av \

--delete "${SOURCE_DIR}/" \

--link-dest "${LATEST_LINK}" \

--filter="merge /home/kurome/.opt/rsync/backup-home" \

"${BACKUP_PATH}"

rm -rf "${LATEST_LINK}"

ln -s "${BACKUP_PATH}" "${LATEST_LINK}"

Fedora Questions

Cannot open acess to console, the root account is locked…

先是添加一个 LV 到 /etc/fstab,结果开机报错,原因是写错了:

Time out ...Dependency failed for ...

结束后就 Cannot open acess to console, the root account is locked,什么也干不了,只能强制关机。

解决方案是重启进入 Fedora Live CD,挂载 root,修改 /etc/fstab。但是无法挂载,挂载的是 Fedora Live CD 的 root,我 TM 佛了,原因应该是这两个名一模一样,Live CD 覆盖了 root。最后是用 Ubntu Live CD 解决。

这告诉我们,不要只有一个 Live CD。这还告诉我们,先找自己的原因才能有耐心去解决问题。

dmesg-x86/cpu: SGX disabled by BIOS

snd_hda_codec_hdmi hdaudioC0D2: Monitor plugged-in, Failed to power up codec ret=[-13]

set Kernel parameters,要使改变在重启后仍生效,您可以手动编辑 /boot/grub/grub.cfg。对于初学者,建议编辑 /etc/default/grub 并将您的内核选项添加至 GRUB_CMDLINE_LINUX_DEFAULT 行:

GRUB_CMDLINE_LINUX_DEFAULT="snd_hda_codec_hdmi.enable_silent_stream=0"

然后重新生成 grub.cfg 文件:

# grub2grub-mkconfig2 -o /boot/grub2/grub.cfg

为什么 Linus Torvalds 用 Fedora

- 2008:linus对发行版的要求是"易安装,比较贴近上游"即可(滚动+少折腾”)。

- 2010年的时候,他指出了Fedora 14的一个bug。

- 2011年Fedora 15换Gnome3作为默认DE了,Linus直言"unholy mess" ,然后转投XFCE。

- 2011年末,Linus提出并修补了openSUSE中Xorg的一个严重bug。

- 2013年5月:Linus尝试将自己手头的MacBook Air装上Linux,把几个大的发行版全部都试了一遍。发现只有Fedora能正常工作。

- 之后的所有消息就是各种fedora了

代理后为什么 ping 不通

问题:

设置了http_proxy和https_proxy在.bashrc文件里,firefox可以上网了。ping外网能够解析域名,但ping不通

解答:

首先提一个问题,为什么我们要用代理服务器上网?

那是因为如果不用代理服务器,我们访问的website 被blocked,最简单的方式就是在一个大型防火墙上执行: deny website IP。

而使用代理服务器,无非是用代理服务器的IP作为目的IP,把用户的HTTP、HTTPS封装在TCP上,这样途径防火墙时,由于目的IP不在blocked IP 之列,所以被放行,这样我们就可以浏览一些被blocked 的网页。

但是一般代理服务器并不为UDP/ICMP服务,最多为TCP服务,所以你ping website 时,代理服务器并没有介入,因为Ping是ICMP报文,那就意味着你的ping包的目的IP就是被blocked IP地址,很显然无法正常通过,全被丢了。

Fedora安装Chrome后显示“您的浏览器由所属组织管理”

I finally got a chance to look into this today, and I don’t think it’s as alarming as this BZ makes it sound. Yes, Chrome (over-)states that it is “Managed by your organization”. Clicking on that links to https://support.google.com/chrome/answer/9281740 which lists the things a managed system can do. However, if you read just a few sentences further, it tells you how to view exactly which settings your administrator has enabled, which in turn has links to the descriptions of what those features are. As clearly linked there, the only settings we’ve enabled is “This browser can negotiate authentication with *.fedoraproject.org”.

So, I’m inclined to say that while the initial reading page might lead a user to be slightly concerned, I don’t feel that the situation is particularly dire. They can always just read content in the links.

In the worst case, if someone really doesn’t want to have that message appear, they can just dnf remove fedora-chromium-config.

This package is used to install customizations for Chromium/Chrome that are recommended by Fedora, including a user-agent string identifying the system as Fedora.

It includes a GSSAPI configuration that enables access to many Fedora Project services. To add support for other domains, replace the symlink /etc/chromium/policies/managed/00_gssapi.json with your own content. (upstream)

difference between docker attach and docker exec

There was a commit PR which added to the doc:

Note: This command (

attach) is not for running a new process in a container. See:docker exec.

The answer to “Docker. How to get bash\ssh inside runned container (run -d)?” illustrates the difference:

(docker >= 1.3) If we use

docker attach, we can use only one instance of shell. So if we want to open new terminal with new instance of container’s shell, we just need to rundocker execif the docker container was started using

/bin/bashcommand, you can access it using attach, if not then you need to execute the command to create a bash instance inside the container usingexec.

As mentioned in this issue:

- Attach isn’t for running an extra thing in a container, it’s for attaching to the running process.

- “

docker exec” is specifically for running new things in a already started container, be it a shell or some other process.

The same issue adds:

While

attachis not well named, particularly because of the LXC commandlxc-attach(which is more akindocker exec <container> /bin/sh, but LXC specific), it does have a specific purpose of literally attaching you to the process Docker started. Depending on what the process is the behavior may be different, for instance attaching to/bin/bashwill give you a shell, but attaching to redis-server will be like you’d just started redis directly without daemonizing.

Error syncing passwords

Error: MergeDataAndStartSyncing@../../components/password_manager/core/browser/sync/password_syncable_service.cc:190, datatype error was encountered: Failed to get passwords from store.

The problem was solved by deleting ‘Login Data’ and ‘Login Data-journal’ in the profile.

$ rm -rf ~/.config/google-chrome/Default/Login\ Data*

The <profile> part can be found in the Profile Path on the chrome://version page.

Gnome Boxes with ssh

GNOME Boxes does not expose guests to SSH into. You are expected to have SPICE guest additions installed on the guest to be able:

- to copy and paste text with a shared clipboard between the host and the guest and

- to drag and drop files into the guest.

This approach is supposed to be intuitively comprehensible for unsophisticated users.

Where do packages installed with DNF get stored?

With APT (Ubuntu), downloaded packages are stored at: /var/cache/apt/archives

DNF stores downloaded packages and metadata in /var/cache/dnf, in various per-repository subdirectories.

How do I scan for viruses with ClamAV?

RHEL

RHEL Developer Subscription

Need to log in to download RHEL.

下载的时候会断,有时候甚至下载到 99% 都会断,所以最好是用专门的、支持断点续传的软件(如 aria2)下载。同时最好不要关闭浏览器,特别是保留redhat官网登录状态,如果关闭了就需要重新登录,根本没有保存登录状态选项。

怎样使用 Red Hat Subscription Manager (RHSM) 将系统注册到红帽客户门户网站?

# subscription-manager register --username <username> --password <password> --auto-attach

注意!是用户名而不是邮箱!

配置 Red Hat Enterprise Linux 8 中基本系统设置的指南

EPEL & RPMFusion

EPEL的全称叫 Extra Packages for Enterprise Linux 。EPEL是由 Fedora 社区打造,为 RHEL 及衍生发行版如 CentOS、Scientific Linux 等提供高质量软件包的项目。装上了 EPEL之后,就相当于添加了一个第三方源。

# subscription-manager repos --enable codeready-builder-for-rhel-9-$(arch)-rpms

# dnf install https://dl.fedoraproject.org/pub/epel/epel-release-latest-9.noarch.rpm

如果你知道rpmfusion.org的话,拿 rpmfusion 做比较还是很恰当的,rpmfusion 主要为桌面发行版提供大量rpm包(只有开源驱动才能进官方源,想要闭源驱动装rpmfusion),而EPEL则为服务器版本提供大量的rpm包,而且大多数rpm包在官方 repository 中是找不到的。

继上面安装 epel 后安装 RPMFusion:

# dnf install --nogpgcheck https://mirrors.rpmfusion.org/free/el/rpmfusion-free-release-$(rpm -E %rhel).noarch.rpm https://mirrors.rpmfusion.org/nonfree/el/rpmfusion-nonfree-release-$(rpm -E %rhel).noarch.rpm

使用 BFSU MIRROR

$ sudo dnf install --nogpgcheck https://mirrors.bfsu.edu.cn/rpmfusion/free/el/rpmfusion-free-release-$(rpm -E %rhel).noarch.rpm https://mirrors.bfsu.edu.cn/rpmfusion/nonfree/el/rpmfusion-nonfree-release-$(rpm -E %rhel).noarch.rpm -y

注意:RHEL、CentOS 及替代(Rocky、AlmaLinux、OracleLinux)等服务器版本,很多常见桌面应用是没有在源里面提供的(不论时官方源还是额外的第三方源),因此需要手动管理了。

Remi’s RPM repository

向Fedora和Enterprise Linux(RHEL、CentOS、Oracle、Scientific Linux,…)用户提供 最新版本的**PHP**堆栈、全功能和一些其他软件。它主要包含:

- 我也在 Fedora 中维护的包

- Fedora 开发版中可用的软件包的反向移植

- 一些与 Fedora 政策不兼容的软件包

- 在提交到 Fedora 存储库之前正在处理的一些包

- (几乎)香草版本

这与 Enterprise Linux的向后移植修复策略相去甚远。

GetPageSpeed RHEL Packages Repository

We have by far the largest RPM repository with dynamic stable NGINX modules and VMODs for Varnish 4.1 and 6.0 LTS. If you want to install nginx, Varnish and lots of useful modules for them, this is your one stop repository to get all performance related software.

ELRepo Project

The ELRepo Project focuses on hardware related packages to enhance your experience with Enterprise Linux. This includes filesystem drivers, graphics drivers, network drivers, sound drivers, webcam and video drivers.

HTML5/MP4 videos

Install EPEL and RPMFusion.

Then yum install ffmpeg and you should be all set. The way Firefox works with this is it links to the avcodec/avformat (one of those two) libraries at launch, and those are provided by the ffmpeg project. ffmpeg in turn will grab the necessary codecs’ libraries it was compiled with (x264, vp9, x265, etc) and install them on your system.

Kdump

Kdump是一种基于kexec的Linux内核崩溃捕获机制,简单来说系统启动时会预留一块内存,当系统崩溃调用命令kexec(kdump kernel)在预留的内存中启动kdump内核,该内核会将此时内存中的所有运行状态和数据信息收集到一个coredump文件中以便后续分析调试。

Qemu on rhel

The main QEMU executable is now /usr/libexec/qemu-kvm

VNC applications

Some Free/Libre software supporting VNC/RFB protocol or Remote Desktop Protocol (RDP):

- noVNC (GitHub) is a browser-based app supporting many VNC features but no RDP.

- rdesktop (GitHub)

- FreeRDP (GitHub) Fork of rdesktop to clean the code, support Seamless Windows (RDP6)…

- Remmina (GitHub) Based on FreeRDP replaced tsclient as Ubuntu’s default RD client (2011)

- Vinagre Default GNOME VNC client supporting RDP since 2012

- Ulteo Open Virtual Desktop (guide to get source code)

VirtualBox has a built-in vRDP protocol that can be used to access GNU/Linux remote desktops (Linux distro usually lacks a RDP server). The vRDP protocol is compatible with all RDP clients. However, the proprietary VirtualBox Extension Pack is required.

See also this good comparison of remote desktop software (Wikipedia).

TechRadar has also published an interesting article on this purpose:

Best Linux remote desktop clients: Top 5 RDC in 2018 By Mayank Sharma, January 2018 We cover all the ins-and-outs of remote viewing

Remote control features

- TigerVNC 3/5

- RealVNC 4/5 Top

- Remmina 4/5 Top

- Vinagre 3/5

- TightVNC 3/5

Multimedia performance

- TigerVNC 4/5 Top

- RealVNC 4/5 Top

- Remmina 3/5

- Vinagre 4/5 Top

- TightVNC 2/5

Interface and usability

- TigerVNC 3/5

- RealVNC 3/5

- Remmina 3/5

- Vinagre 3/5

- TightVNC 3/5

Documentation and support

- TigerVNC 2/5

- RealVNC 5/5 Top

- Remmina 3/5

- Vinagre 2/5

- TightVNC 2/5

Server and protocol support

- TigerVNC 2/5

- RealVNC 4/5 Top

- Remmina 3/5

- Vinagre 3/5

- TightVNC 1/5

Configurable parameters

- TigerVNC 2/5

- RealVNC 4/5 Top

- Remmina 3/5

- Vinagre 2/5

- TightVNC 2/5

Connection flexibility

- TigerVNC 4/5 Top

- RealVNC 3/5

- Remmina 4/5 Top

- Vinagre 2/5

- TightVNC 4/5 Top

Final verdict

Rocky

NJU Mirror

$ sed -e 's|^mirrorlist=|#mirrorlist=|g' \

-e 's|^#baseurl=http://dl.rockylinux.org/$contentdir|baseurl=https://mirrors.nju.edu.cn/rocky|g' \

-i.bak \

/etc/yum.repos.d/Rocky-*.repo

$ dnf makecache

EPEL

首先从CentOS Extras这个源(本镜像站也有镜像)里安装epel-release:

yum install epel-release

修改/etc/yum.repos.d/epel.repo,将mirrorlist和metalink开头的行注释掉。

接下来,取消注释这个文件里baseurl开头的行,并将其中的http://download.fedoraproject.org/pub替换成https://mirrors.bfsu.edu.cn。

可以用如下命令自动替换:(来自 https://github.com/tuna/issues/issues/687)

$ sed -e 's!^metalink=!#metalink=!g' \

-e 's!^#baseurl=!baseurl=!g' \

-e 's!//download\.fedoraproject\.org/pub!//mirrors.bfsu.edu.cn!g' \

-e 's!//download\.example/pub!//mirrors.bfsu.edu.cn!g' \

-e 's!http://mirrors!https://mirrors!g' \

-i /etc/yum.repos.d/epel*.repo

CentOS

关于多线程

概述

每个正在系统上运行的程序都是一个进程。每个进程包含一到N个线程。进程也可能是整个程序或者是部分程序的动态执行。线程是一组指令的集合,或者是程序的特殊段,它可以在程序里独立执行。也可以把它理解为代码运行的上下文。所以线程基本上是轻量级的进程,它负责在单个程序里执行多任务。通常由操作系统负责多个线程的调度和执行。线程是程序中一个单一的顺序控制流程。在单个程序中同时运行多个线程完成不同的工作,称为多线程。

线程和进程的区别在于,子进程和父进程有不同的代码和数据空间,而多个线程则共享数据空间,每个线程有自己的执行堆栈和程序计数器为其执行上下文.多线程主要是为了节约CPU时间,发挥利用,根据具体情况而定. 线程的运行中需要使用计算机的内存资源和CPU。

同步多线程(SMT)是一种在一个CPU 的时钟周期内能够执行来自多个线程的指令的硬件多线程技术。本质上,同步多线程是一种将线程级并行处理(多CPU)转化为指令级并行处理(同一CPU)的方法。 同步多线程是单个物理处理器从多个硬件线程上下文同时分派指令的能力。同步多线程用于在商用环境中及为周期/指令(CPI)计数较高的工作负载创造性能优势。 处理器采用超标量结构,最适于以并行方式读取及运行指令。同步多线程使您可在同一处理器上同时调度两个应用程序,从而利用处理器的超标量结构性质。

超线程(HT, Hyper-Threading)是英特尔研发的一种技术,于2002年发布。通过此技术,英特尔实现在一个实体CPU中,提供两个逻辑线程。

其实可以将SMT和HT理解为一个技术。

Hyper-threading (officially called Hyper- ThreadingTechnology or HT Technology, and abbreviated as HTT orHT) is Intel’s proprietary simultaneous multithreading (SMT) implementation used to improve parallelization ofcomputations (doing multiple tasks at once) performed onx86 microprocessors.

来自 https://cn.bing.com/search?q=intel+ht&go=%E6%8F%90%E4%BA%A4&qs=ds&form=QBLHCN

与多进程的区别

“进程——资源分配的最小单位,线程——程序执行的最小单位”

实际应用中基本上都是“进程+线程”的结合方式,千万不要真的陷入一种非此即彼的误区。

| 对比维度 | 多进程 | 多线程 | 总结 |

|---|---|---|---|

| 数据共享、同步 | 数据共享复杂,需要用IPC;数据是分开的,同步简单 | 因为共享进程数据,数据共享简单,但也是因为这个原因导致同步复杂 | 各有优势 |

| 内存、CPU | 占用内存多,切换复杂,CPU利用率低 | 占用内存少,切换简单,CPU利用率高 | 线程占优 |

| 创建销毁、切换 | 创建销毁、切换复杂,速度慢 | 创建销毁、切换简单,速度很快 | 线程占优 |

| 编程、调试 | 编程简单,调试简单 | 编程复杂,调试复杂 | 进程占优 |

| 可靠性 | 进程间不会互相影响 | 一个线程挂掉将导致整个进程挂掉 | 进程占优 |

| 分布式 | 适应于多核、多机分布式;如果一台机器不够,扩展到多台机器比较简单 | 适应于多核分布式 | 进程占优 |

- 需要注意:

1)需要频繁创建销毁的优先用线程

2)需要进行大量计算的优先使用线程

3)强相关的处理用线程,弱相关的处理用进程

一般的Server需要完成如下任务:消息收发、消息处理。“消息收发”和“消息处理”就是弱相关的任务,而“消息处理”里面可能又分为“消息解码”、“业务处理”,这两个任务相对来说相关性就要强多了。因此“消息收发”和“消息处理”可以分进程设计,“消息解码”、“业务处理”可以分线程设计。当然这种划分方式不是一成不变的,也可以根据实际情况进行调整。

4)可能要扩展到多机分布的用进程,多核分布的用线程

5)都满足需求的情况下,用你最熟悉、最拿手的方式

来自 https://blog.csdn.net/lishenglong666/article/details/8557215

如何使用?

需要CPU、BIOS、操作系统、应用软件都支持多线程技术才可以。

支持多线程的CPU

Power CPU 支持的SMT技术:

Simultaneous multithreading (SMT) is a processor technology that allows multiple instruction streams (threads) to run concurrently on the same physical processor, improving overall throughput. To the operating system, each hardware thread is treated as an independent logical processor. Single-threaded (ST) execution mode is also supported.

来自 https://www.ibm.com/support/knowledgecenter/SSFHY8_6.2/reference/am5gr_f0106.html?view=embed

Intel CPU 支持的HT技术:

Intel® Hyper-Threading Technology (Intel® HT Technology) uses processor resources more efficiently, enabling multiple threads to run on each core. As a performance feature, it also increases processor throughput, improving overall performance on threaded software. Intel® HT Technology is available on the latest Intel® Core™ vPro™ processors, the Intel® Core™ processor family, the Intel® Core™ M processor family, and the Intel® Xeon® processor family. By combining one of these Intel® processors and chipsets with an operating system and BIOS supporting Intel® HT Technology.

SMT/HT支持情况

- Intel CPU : 2 Thread/Core

- Power9 CPU: 8 Thread /Core

- Sparc: 8 Thread /Core

RHEL7/CentOS7 & Intel CPU

BIOS 中修改SMT/HT 的设置,使用这种方式Enable或者Disable后,将永久生效,需要重启。

Hyper-Threading Technology BIOS Setup Options

For Intel® Desktop/Server Boards setup option location is the main menu of the BIOS setup program.

• Located on the same menu screen that already had Processor Type, Processor Speed, System Bus Speed, and other related processor fields.

• Setup Option Text

○ The field is called Hyper-Threading Technology.

• Setup Option Values

○ The setup option values are Enabled and Disabled.

• Setup Option Help Text

来自 <https://www.intel.com/content/www/us/en/support/articles/000007645/boards-and-kits/desktop-boards.html>

RHEL/CentOS操作系统中查看多线程情况:(更多信息:https://access.redhat.com/solutions/rhel-smt)

# lscpu | grep -e Socket -e Core -e Thread

Thread(s) per core: 2 # 线程数

Core(s) per socket: 6 # core 数量

Socket(s): 2

或者

# grep -H . /sys/devices/system/cpu/cpu*/topology/thread_siblings_list | sort -n -t ':' -k 2 -u

# 显示 /sys/devices/system/cpu/cpu0/topology/thread_siblings_list:0 # 表示HT关闭

# 显示 /sys/devices/system/cpu/cpu0/topology/thread_siblings_list:0-1 # 表示 HT 启用

操作系统层关闭多线程有几种办法:

- 方法一:使用

nosmt启动参数,需要新的x86 CPU,需要重启

# grubby --args=nosmt --update-kernel=DEFAULT

# grub2-mkconfig -o /boot/grub/grub.conf # 创建新的grub.conf

# reboot #重启

- 方法二:临时关闭,重启后失效

# echo off > /sys/devices/system/cpu/smt/control

/sys/devices/system/cpu/smt/control:

This file allows to read out the SMT control state and provides the

ability to disable or (re)enable SMT. The possible states are:

============== ===================================================

on SMT is supported by the CPU and enabled. All

logical CPUs can be onlined and offlined without

restrictions.

off SMT is supported by the CPU and disabled. Only

the so called primary SMT threads can be onlined

and offlined without restrictions. An attempt to

online a non-primary sibling is rejected

forceoff Same as 'off' but the state cannot be controlled.

Attempts to write to the control file are rejected.

notsupported The processor does not support SMT. It's therefore

not affected by the SMT implications of L1TF.

Attempts to write to the control file are rejected.

============== ===================================================

The possible states which can be written into this file to control SMT

state are:

- on

- off

- forceoff

/sys/devices/system/cpu/smt/active:

This file reports whether SMT is enabled and active, i.e. if on any

physical core two or more sibling threads are online.

AIX & Power

Power9 CPU默认支持8线程,使用smtctl命令可以查看和修改 smt级别。更多内容查看https://www.ibm.com/support/knowledgecenter/ssw_aix_72/com.ibm.aix.cmds5/smtctl.htm

- 查看

SMT level

smtctl

- 临时修改

SMT level, # 可以是1, 2, 4 or 8,重启后将恢复原来的smt level

smtctl -t 2 -w now

- 修改

SMT level永久生效,# 可以是1, 2, 4 or 8,完成后需要使用bosboot创建启动设备

smtctl -t 4 -w boot

bosboot -a # Creates complete boot image and device.

RHEL7 & Power

OpenPower CPU 默认支持4线程,安装RHEL后可以使用开源的工具 ppc64_cpu进行查看和修改多线程(更多查看 https://github.com/ibm-power-utilities/powerpc-utils)。

ppc64_cpu

---------

This allows users to set the smt state, smt-snooze-delay and other settings

on ppc64 processors. It also allows users to control the number of processor

cores which are online (not in the sleep state).

来自 <https://github.com/ibm-power-utilities/powerpc-utils>

1,查看 SMT level

ppc64_cpu --smt

2,修改 SMT 级别, # is 1, 2, 4 or on

ppc64_cpu --smt=#

3, 关闭 smt支持

ppc64_cpu --smt=off

其他

oracle数据库

Oracle Database 在12c之前windows平台下支持多线程,Unix和Linux只支持多进程模式。在Oracle Database 12c中,Oracle引入了多线程模式,允许在Windows平台之外的Unix、Linux系统使用多线程模式,结合多进程与多线程模式,Oracle可以改进进程管理与性能。

通过设置初始化参数threaded_execution,可以启用或关闭多线程模式,该参数缺省值为False,设置为TRUE启用12c的这个新特性:

SQL> show parameter threaded_exec

NAME TYPE VALUE

---

threaded_execution boolean FALSE

SQL> alter system set threaded_execution=true scope=spfile;

System altered.

该参数重新启动数据库后生效,但是注意,多线程模式,不支持操作系统认证,不能直接启动数据库,需要提供SYS的密码认证后方能启动数据库:

SQL> shutdown immediate;

SQL> startup

ORA-01017: invalid username/password; logon denied

# 需要通过用户名和密码登录数据库。

用ps -ef 检查一下进程/线程:

[oracle@enmocoredb dbs]$ ps -ef|grep ora_

oracle 27404 1 0 17:00 ? 00:00:00 ora_pmon_core

oracle 27406 1 0 17:00 ? 00:00:00 ora_psp0_core

oracle 27408 1 3 17:00 ? 00:00:05 ora_vktm_core

oracle 27412 1 0 17:00 ? 00:00:00 ora_u004_core

oracle 27418 1 0 17:00 ? 00:00:00 ora_u005_core

oracle 27424 1 0 17:00 ? 00:00:00 ora_dbw0_core

其中U<NNN>进程是共享线程的"容器进程",每个进程可以容纳100个线程。

来自 https://www.eygle.com/archives/2013/07/oracle_database_12c_multithreaded_model.html

连接热点

-

打开WIFI

ifconfig interface up -

查看所有可用的无线网络信号

iw wlp2s0 scan | grep SSID -

连接无线网

wpa_supplicant -B -i wlp2s0 -c <(wpa_passphrase "SSID" "passwd") -

分配IP地址

dhclient interface -

查看无线网卡地址信息,有ip地址表示网络连接成功

ifconfig interface

PPPOE (ADSL)拨号上网

-

安装拨号软件

dnf install rp-pppoe* ppp* -

设定

pppoe-setup -

拨号上网

pppoe-stoppppoe-start

安装中文输入法

-

安装 fcitx

dnf install fcitx-im fcitx-configtool fcitx-googlepinyin -

配置

$ nano ~/.xprofile # or ~/.bashrc export GTK_MODULE=fcitx export QT_IM_MODULE=fcitx export XMODIFIERS="@im=fcitx" -

fcitx 没图标:重装fcitx,在fcitx配置里关掉Kimpanel

关闭触摸板

$ dnf install xorg-x11-apps

synclient TouchpadOff=1 # 关闭

synclient TouchpadOff=0 # 开启

用 MTP 挂载手机

-

安装jmtpfs

dnf install jmtpfs -

查看手机 “busnum”和“devnum”

jmptfs -l -

建立挂载点

mkdir /media/dir -

挂载手机

jmtpfs -device=busnum,devnum /media/dir/

查找依赖

$ yum whatprovide package

$ dnf provides package

默认字体

CentOS 默认字体目录 /lib/kbd/consolefonts

纯命令行是不能使用系统之外的字体的。

CentOS Minimal + Xfce

base 源与 epel 源,使用用阿里镜像: https://developer.aliyun.com/mirror/

-

安装Xfce4,先安装 Xfce 可以保证不安装多余的包

dnf group listdnf groupinstall Xfce -

安装 X Window system

dnf groupinstall "X Window system" -

验证

systemctl isolate graphical.target -

设置

# 设置成命令模式systemctl set-default multi-user.target # 设置成图形模式systemctl set-default graphical.target -

安装中文字体和中文输入法楷体字体

dnf install cjkuni-ukai-fonts -

输入法需要安装如下包:

- ibus, 这个包里有ibus-daemon这个平台服务器程序和ibus这个配置助手。

- ibus-libpinyin, 这个是ibus平台下具体的拼音输入法。

- im-chooser,这个是输入法平台选择助手程序。

- 执行im-chooser,选择输入法平台和输入法。重新登录系统。

-

xfce 主题

- 网站:xfce-look.org

- 主题目录:

/usr/share/themes或~/.themes - 图标鼠标目录:

/usr/share/icons或~/.icons - 壁纸:

/usr/share/background,/usr/share/wallpapers - Plank

SELinux

SELinux 初探

從進入了 CentOS 5.x 之後的 CentOS 版本中 (當然包括 CentOS 7),SELinux 已經是個非常完備的核心模組了!尤其 CentOS 提供了很多管理 SELinux 的指令與機制, 因此在整體架構上面是單純且容易操作管理的!所以,在沒有自行開發網路服務軟體以及使用其他第三方協力軟體的情況下, 也就是全部使用 CentOS 官方提供的軟體來使用我們伺服器的情況下,建議大家不要關閉 SELinux 了喔! 讓我們來仔細的玩玩這傢伙吧!

什麼是 SELinux

什麼是 SELinux 呢?其實他是『 Security Enhanced Linux 』的縮寫,字面上的意義就是安全強化的 Linux 之意!那麼所謂的『安全強化』是強化哪個部分? 是網路資安還是權限管理?底下就讓我們來談談吧!

當初設計的目標:避免資源的誤用

SELinux 是由美國國家安全局 (NSA) 開發的,當初開發這玩意兒的目的是因為很多企業界發現, 通常系統出現問題的原因大部分都在於『內部員工的資源誤用』所導致的,實際由外部發動的攻擊反而沒有這麼嚴重。 那麼什麼是『員工資源誤用』呢?舉例來說,如果有個不是很懂系統的系統管理員為了自己設定的方便,將網頁所在目錄 /var/www/html/ 的權限設定為 drwxrwxrwx 時,你覺得會有什麼事情發生?

現在我們知道所有的系統資源都是透過程序來進行存取的,那麼 /var/www/html/ 如果設定為 777 , 代表所有程序均可對該目錄存取,萬一你真的有啟動 WWW 伺服器軟體,那麼該軟體所觸發的程序將可以寫入該目錄, 而該程序卻是對整個 Internet 提供服務的!只要有心人接觸到這支程序,而且該程序剛好又有提供使用者進行寫入的功能, 那麼外部的人很可能就會對你的系統寫入些莫名其妙的東西!那可真是不得了!一個小小的 777 問題可是大大的!

為了控管這方面的權限與程序的問題,所以美國國家安全局就著手處理作業系統這方面的控管。 由於 Linux 是自由軟體,程式碼都是公開的,因此她們便使用 Linux 來作為研究的目標, 最後更將研究的結果整合到 Linux 核心裡面去,那就是 SELinux 啦!所以說, SELinux 是整合到核心的一個模組喔! 更多的 SELinux 相關說明可以參考:http://www.nsa.gov/research/selinux/

這也就是說:其實 SELinux 是在進行程序、檔案等細部權限設定依據的一個核心模組! 由於啟動網路服務的也是程序,因此剛好也能夠控制網路服務能否存取系統資源的一道關卡! 所以,在講到 SELinux 對系統的存取控制之前,我們得先來回顧一下之前談到的系統檔案權限與使用者之間的關係。 因為先談完這個你才會知道為何需要 SELinux 的啦!

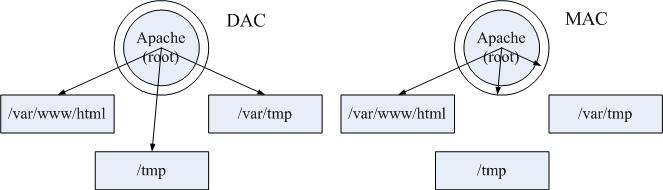

傳統的檔案權限與帳號關係:自主式存取控制, DAC

我們通过Linux 帳號管理與 ACL 權限設定的內容,知道系統的帳號主要分為系統管理員 (root) 與一般用戶,而這兩種身份能否使用系統上面的檔案資源則與 rwx 的權限設定有關。 不過你要注意的是,各種權限設定對 root 是無效的。因此,當某個程序想要對檔案進行存取時, 系統就會根據該程序的擁有者/群組,並比對檔案的權限,若通過權限檢查,就可以存取該檔案了。

這種存取檔案系統的方式被稱為『自主式存取控制 (Discretionary Access Control, DAC)』,基本上,就是依據程序的擁有者與檔案資源的 rwx 權限來決定有無存取的能力。 不過這種 DAC 的存取控制有幾個困擾,那就是:

- root 具有最高的權限:如果不小心某支程序被有心人士取得, 且該程序屬於 root 的權限,那麼這支程序就可以在系統上進行任何資源的存取!真是要命!

- 使用者可以取得程序來變更檔案資源的存取權限:如果你不小心將某個目錄的權限設定為 777 ,由於對任何人的權限會變成 rwx ,因此該目錄就會被任何人所任意存取!

這些問題是非常嚴重的!尤其是當你的系統是被某些漫不經心的系統管理員所掌控時!他們甚至覺得目錄權限調為 777 也沒有什麼了不起的危險哩…

以政策規則訂定特定程序讀取特定檔案:委任式存取控制, MAC

現在我們知道 DAC 的困擾就是當使用者取得程序後,他可以藉由這支程序與自己預設的權限來處理他自己的檔案資源。 萬一這個使用者對 Linux 系統不熟,那就很可能會有資源誤用的問題產生。為了避免 DAC 容易發生的問題,因此 SELinux 導入了委任式存取控制 (Mandatory Access Control, MAC) 的方法!

委任式存取控制 (MAC) 有趣啦!他可以針對特定的程序與特定的檔案資源來進行權限的控管! 也就是說,即使你是 root ,那麼在使用不同的程序時,你所能取得的權限並不一定是 root , 而得要看當時該程序的設定而定。如此一來,我們針對控制的『主體』變成了『程序』而不是使用者喔! 此外,這個主體程序也不能任意使用系統檔案資源,因為每個檔案資源也有針對該主體程序設定可取用的權限! 如此一來,控制項目就細的多了!但整個系統程序那麼多、檔案那麼多,一項一項控制可就沒完沒了! 所以 SELinux 也提供一些預設的政策 (Policy) ,並在該政策內提供多個規則 (rule) ,讓你可以選擇是否啟用該控制規則!

在委任式存取控制的設定下,我們的程序能夠活動的空間就變小了!舉例來說, WWW 伺服器軟體的達成程序為 httpd 這支程式, 而預設情況下, httpd 僅能在 /var/www/ 這個目錄底下存取檔案,如果 httpd 這個程序想要到其他目錄去存取資料時, 除了規則設定要開放外,目標目錄也得要設定成 httpd 可讀取的模式 (type) 才行喔!限制非常多! 所以,即使不小心 httpd 被 cracker 取得了控制權,他也無權瀏覽 /etc/shadow 等重要的設定檔喔!

簡單的來說,針對 Apache 這個 WWW 網路服務使用 DAC 或 MAC 的結果來說,兩者間的關係可以使用下圖來說明。 底下這個圖示取自 Red Hat 訓練教材,真的是很不錯~所以被鳥哥借用來說明一下!

左圖是沒有 SELinux 的 DAC 存取結果,apache 這隻 root 所主導的程序,可以在這三個目錄內作任何檔案的新建與修改~ 相當麻煩~右邊則是加上 SELinux 的 MAC 管理的結果,SELinux 僅會針對 Apache 這個『 process 』放行部份的目錄, 其他的非正規目錄就不會放行給 Apache 使用!因此不管你是誰,就是不能穿透 MAC 的框框!這樣有比較了解乎?

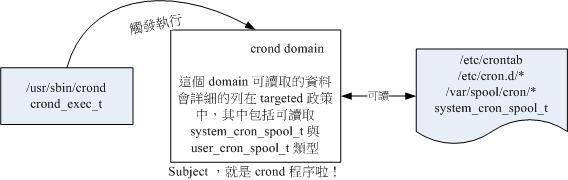

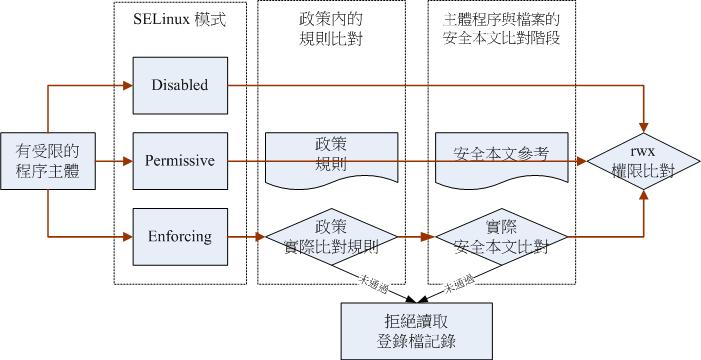

SELinux 的運作模式

再次的重複說明一下,SELinux 是透過 MAC 的方式來控管程序,他控制的主體是程序, 而目標則是該程序能否讀取的『檔案資源』!所以先來說明一下這些咚咚的相關性啦!

-

主體 (Subject): SELinux 主要想要管理的就是程序,因此你可以將『主體』跟本章談到的 process 劃上等號;

-

目標 (Object): 主體程序能否存取的『目標資源』一般就是檔案系統。因此這個目標項目可以等檔案系統劃上等號;

-

政策 (Policy):

由於程序與檔案數量龐大,因此 SELinux 會依據某些服務來制訂基本的存取安全性政策。這些政策內還會有詳細的規則 (rule) 來指定不同的服務開放某些資源的存取與否。在目前的 CentOS 7.x 裡面僅有提供三個主要的政策,分別是:

- targeted:針對網路服務限制較多,針對本機限制較少,是預設的政策;

- minimum:由 target 修訂而來,僅針對選擇的程序來保護!

- mls:完整的 SELinux 限制,限制方面較為嚴格。

建議使用預設的 targeted 政策即可。

-

安全性本文 (security context): 我們剛剛談到了主體、目標與政策面,但是主體能不能存取目標除了政策指定之外,主體與目標的安全性本文必須一致才能夠順利存取。 這個安全性本文 (security context) 有點類似檔案系統的 rwx 啦!安全性本文的內容與設定是非常重要的! 如果設定錯誤,你的某些服務(主體程序)就無法存取檔案系統(目標資源),當然就會一直出現『權限不符』的錯誤訊息了!

由於 SELinux 重點在保護程序讀取檔案系統的權限,因此我們將上述的幾個說明搭配起來,繪製成底下的流程圖,比較好理解:

上圖的重點在『主體』如何取得『目標』的資源存取權限! 由上圖我們可以發現,(1)主體程序必須要通過 SELinux 政策內的規則放行後,就可以與目標資源進行安全性本文的比對, (2)若比對失敗則無法存取目標,若比對成功則可以開始存取目標。問題是,最終能否存取目標還是與檔案系統的 rwx 權限設定有關喔!如此一來,加入了 SELinux 之後,出現權限不符的情況時,你就得要一步一步的分析可能的問題了!

安全性本文 (Security Context)

CentOS 7.x 的 target 政策已經幫我們制訂好非常多的規則了,因此你只要知道如何開啟/關閉某項規則的放行與否即可。 那個安全性本文比較麻煩!因為你可能需要自行設定檔案的安全性本文呢!為何需要自行設定啊? 舉例來說,你不也常常進行檔案的 rwx 的重新設定嗎?這個安全性本文你就將他想成 SELinux 內必備的 rwx 就是了!這樣比較好理解啦。

安全性本文存在於主體程序中與目標檔案資源中。程序在記憶體內,所以安全性本文可以存入是沒問題。 那檔案的安全性本文是記錄在哪裡呢?事實上,安全性本文是放置到檔案的 inode 內的,因此主體程序想要讀取目標檔案資源時,同樣需要讀取 inode , 在 inode 內就可以比對安全性本文以及 rwx 等權限值是否正確,而給予適當的讀取權限依據。

那麼安全性本文到底是什麼樣的存在呢?我們先來看看 /root 底下的檔案的安全性本文好了。 觀察安全性本文可使用『 ls -Z 』去觀察如下:(注意:你必須已經啟動了 SELinux 才行!若尚未啟動,這部份請稍微看過一遍即可。底下會介紹如何啟動 SELinux 喔!)

# 先來觀察一下 root 家目錄底下的『檔案的 SELinux 相關資訊』

[root@study ~]# ls -Z

-rw-------. root root system_u:object_r:admin_home_t:s0 anaconda-ks.cfg

-rw-r--r--. root root system_u:object_r:admin_home_t:s0 initial-setup-ks.cfg

-rw-r--r--. root root unconfined_u:object_r:admin_home_t:s0 regular_express.txt

# 上述特殊字體的部分,就是安全性本文的內容!鳥哥僅列出數個預設的檔案而已,

# 本書學習過程中所寫下的檔案則沒有列在上頭喔!

如上所示,安全性本文主要用冒號分為三個欄位,這三個欄位的意義為:

Identify:role:type

身份識別:角色:類型

這三個欄位的意義仔細的說明一下吧:

-